闻乐 发自 凹非寺

量子位 | 公众号 QbitAI

谁说扩散模型只能生成图像和视频?

现在它们能高质量地写代码了,速度还比传统大模型更快!

Inception Labs推出基于扩散技术的全新商业级大语言模型——Mercury。

Mercury突破了自回归模型 “从左到右” 逐词生成的限制,采用 “从噪声到结构化输出” 的方式,能一次性预测所有方向的token,提高了生成速度。

这样一来,Mercury还解决了自回归“一旦生成难以回头调整”的问题。

扩散模型并不是仅考虑前面已经生成的内容,它能在生成过程中进行动态纠错修改,具有更大的灵活性。

尽管采用了扩散技术,Mercury模型系列仍保留了Transformer架构。

这确保了该模型能直接复用近年来为大语言模型开发的高效训练、推理优化技术(如低阶算子优化、超参数调优工具等)。

实测数据显示,面对相同的编程任务,Mercury的代码生成速度比传统工具最多快10倍,大幅缩短了开发周期。

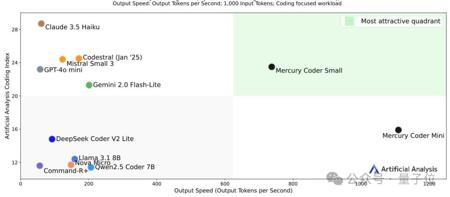

在H100 GPU上实现1109 tokens/秒吞吐量

Mercury用成熟的Transformer作为神经网络基础,结合扩散技术的并行生成能力,既保留了大模型的兼容性,又突破了自回归模型逐词生成的速度限制。

扩散生成流程

Mercury的核心创新在于 “扩散式生成”,流程如下:

- 训练阶段的正向过程:从真实文本(如代码片段)出发,逐步加入噪声(随机替换、删除token等),最终变成完全随机的噪声序列。

- 推理阶段的反向过程(核心):从随机噪声开始,通过Transformer模型迭代优化,逐步去除噪声,最终生成符合真实分布的文本。每次迭代中,模型会并行修改多个token,而非逐词生成。

这一过程扩展了此前的离散扩散方法,通过优化数据处理和计算逻辑,实现了大规模训练(万亿级token)。

高效利用硬件

Mercury主要通过并行化文本生成、动态去噪调度、混合精度量化等技术,极致发挥GPU性能,实现对硬件的高效利用,降低训练和推理成本。

- 并行化文本生成

扩散机制允许模型在单次前向传播中预测多个token,相较于自回归模型的“从左到右”逐词生成,显著提升了GPU利用率。

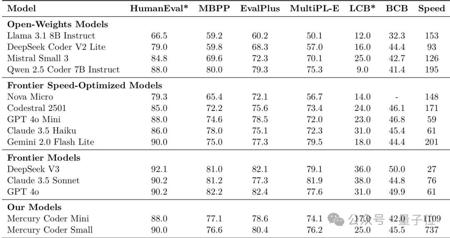

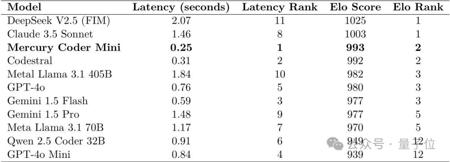

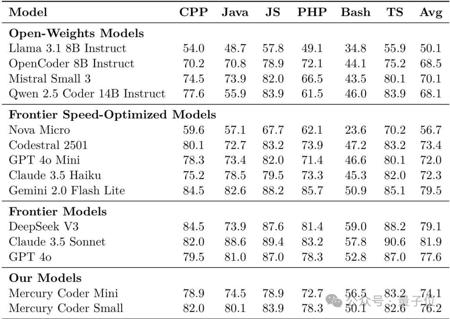

在NVIDIA H100 GPU上,Mercury Coder Mini和Mercury Coder Small(Mercury Coder系列编码优化产品)分别实现了1109 tokens/秒和737 tokens/秒的吞吐量。

在Copilot Arena的基准测试中,可将响应时间压缩至其他工具的1/4,同时硬件资源占用减少60%。

- 动态去噪调度算法

Mercury通过自适应调整去噪步数,在简单任务中减少计算量,在复杂任务中保留足够迭代次数,实现精度与效率的平衡,从而更高效地利用硬件资源,避免不必要的计算开销。

- 混合精度量化技术

模型在推理时可自动切换至低精度计算模式,内存占用减少30%,同时通过残差补偿机制维持输出质量。这让Mercury能在有限的硬件内存条件下运行,且不明显影响性能。

强大的错误纠正能力

与传统自回归模型 “从左到右” 逐词生成,一旦生成难以回头调整不同,Mercury不受限于仅考虑前面已生成的内容,能够在生成过程中动态修改之前的内容,具有更大的灵活性。

- 双向注意力机制

- Mercury在去噪过程中引入上下文双向关联,能够更好地理解文本的前后语境,从而更准确地发现和纠正错误。

- 实时纠错模块

- 模型在去噪步骤中会同步检测代码逻辑漏洞,通过强化学习动态修正输出。在代码生成任务中,Mercury Coder可以自动修正逻辑漏洞,还支持函数级参数自动校正,能有效提高代码的准确性和可用性。

- 多语言语法树嵌入

- Mercury将Python、Java等语言的抽象语法树(AST)结构融入扩散过程,有助于减少语法错误。

超快响应速度与当前CI能力不匹配

在LLMs出现之前,持续集成/交付(CI/CD)的速度就已经成为一个主要瓶颈,这导致开发人员在测试时把时间浪费在等待拉取请求(PRs)上。

有时,一个更改操作需要在队列中等待数小时,甚至有时会因为不稳定需要重新开始。

Mercury模型在编写代码方面实现了超高速响应,但如果每次代码更改都需要数小时进行测试,那么就像这位网友提出的问题一样:

即使大模型能够以比人类快100倍的速度写代码,但测试速度跟不上的话,这将没有什么意义。

于是问题来了:

如何缓解超快响应速度与当前CI能力不匹配的问题?

一些人认为因为开发人员时间比机器时间昂贵得多,所以可以通过简单地“投入更多机器”来解决CI速度问题。

然而,也有另一些人指出,这对于谷歌等“印钞机”公司可能可行,但对于普通公司来说,CI预算是固定的,增加计算资源并不是一件容易的事情。

Inception Labs团队

Mercury的开发方Inception Labs的三位联合创始人是来自斯坦福、UCLA和康奈尔大学的计算机教授。

其中,Stefano Ermon是扩散模型的共同发明人,他与Sohl-Dickstein等学者共同构建了扩散模型的理论基础,并通过后续研究推动了模型的实用化。

另一位创始人Aditya Grover曾在Meta FAIR担任研究科学家。

攻读博士学位期间,他先后在谷歌DeepMind、微软研究院和OpenAI实习。

Volodymyr Kuleshov曾在2018年获得Arthur Samuel最佳论文奖。

该团队包括来自Google DeepMind、微软、Meta、OpenAI和NVIDIA的资深人士,目前正专注于用扩散技术改进大模型性能。

Inception Labs还开放了Mercury模型的在线体验平台。

感兴趣的朋友可点击下方链接体验~

论文地址:https://arxiv.org/abs/2506.17298

Mercury在线体验平台:https://chat.inceptionlabs.ai/

参考链接:

https://news.ycombinator.com/item?id=44489690

— 完 —

量子位 QbitAI

关注我们,第一时间获知前沿科技动态

寻常

太酷了!扩散模型写代码,效率提升真的惊人!

寻常

这效率提升,简直是让我的代码生涯充满希望,太棒了!

承远

我猜这东西很快就会取代程序员,效率简直让人绝望!

寻常

这东西要是能自己写出诗歌,那我就要跪下了,效率太高了!

墨栖

我有点害怕,会不会有一天代码都由AI来掌控?

寻常

这简直是未来的趋势,代码效率提升,简直太棒了!

沐心

我怀疑这东西是不是在跟我比赛,写代码的速度越来越快!

墨栖

这简直是人类进化的一步,代码写快了,世界也更美好!

寻常

这东西要是能自己把我的Bug都改掉就好了,效率更高!

寻常

我感觉我的代码写得都变高级了,这太神奇!