想象一下这样的早晨:

你还在被窝里,你的机器人管家已经在厨房里忙碌了起来:它熟练地导航到燕麦罐、可可球、牛奶,逐一抓取并添加到碗中,最后,它将一碗搭配好的营养早餐送到你的面前,整个过程行云流水,无需任何人工干预。

BSC-Nav 在真实环境中执行「制作早餐」的移动操作任务

这并非科幻片中的桥段,而是来自清华大学与北京航空航天大学团队的最新成果——BSC-Nav 的真实演示。通过模仿生物大脑构建、维护空间记忆的原理,研究团队让智能体拥有了前所未有的「空间感」。

- 论文标题:From reactive to cognitive: brain-inspired spatial intelligence for embodied agents

- arxiv 地址:https://arxiv.org/abs/2508.17198

- 项目地址:https://github.com/Heathcliff-saku/BSC-Nav

这项工作发布后,立刻引起了业界的关注。有同行评价道:「BSC-Nav 证明了它学习和适应不同环境的强大能力,这可能引领我们迈向更智能的导航机器人时代。」

BSC-Nav(Brain-inspired Spatial Cognition for Navigation)是首个受生物大脑空间认知机制启发的统一框架。它不仅赋予了智能体卓越的通用导航能力,还使其能够完成主动具身问答、复杂移动操作等更高阶的空间感知与交互任务。

当前,以多模态大模型(MLLMs)为代表的基座模型几乎无所不能,我们距离通用人工智能(AGI)还有多远?一个公认的瓶颈在于:如何让 AI 走出虚拟世界,在复杂的物理环境中理解、记忆并与世界高效交互——即实现真正的具身智能。

然而,目前大多数由大模型驱动的具身智能体,更像一条「记忆只有七秒的鱼」。它们主要依赖即时观察做出反应,缺乏对环境长期、结构化的记忆。这导致它们在真实、动态的环境中泛化能力差。

为了攻克这一核心难题,BSC-Nav 团队从认知神经科学中汲取灵感,为具身智能体量身打造了一个结构化的空间记忆系统,并与最前沿的基座模型深度融合,让 AI 从此告别「路痴」,拥有了强大的空间认知能力。

具身智能体的记忆碎片化挑战

现有的具身智能导航方法为何难以形成有效的空间记忆?主要存在两类困境:

- 端到端策略的「记忆固化」:基于强化学习或模仿学习训练的导航策略,其模型参数在训练完成后便固定不变。这使得它们高度依赖训练数据的分布,一旦进入未见的真实环境,便如同刻舟求剑,难以泛化到复杂和动态的环境,更无法在新的探索中积累和更新空间记忆。

- 模块化策略的「记忆短视」:另一类主流的导航方法采用层次化策略,通常由多模态大模型进行上层规划(如规划导航子目标),再由启发式算法执行动作规划。然而,这些方法的空间记忆要么是「即时性」的(仅依赖当前观测),要么是「浅表性」的(如静态的语义地图或抽象拓扑图),不仅表征能力有限,更缺乏有效的更新机制,无法应对真实世界的复杂场景和动态变化。

究其根本,这些挑战都指向同一个核心问题:如何为智能体植入一个能够持续构建、动态更新的强大空间记忆系统。这正是 BSC-Nav 驱动多模态大模型在具身环境中,完成从「被动反应」到「主动认知」这一关键跃迁的基石。

解锁 BSC-Nav 的技术核心:三大「记忆组件」复刻人类空间认知

我们之所以能在复杂的环境中穿梭自如,依靠的并非是超强的「大脑算力」,而在于我们与生俱来的一套高效且灵活的空间认知系统。神经科学研究早已表明,生物大脑主要依赖三种相互关联的空间知识形成稳健的空间认知:

- 地标知识(Landmarks):记住环境中显著的物体,比如「街角的花店」、「桌面上的星巴克咖啡杯」。

- 路线知识(Route knowledge):记住连接地标的移动轨迹,比如「从花店直走,到红绿灯右转」。

- 勘测知识(Survey knowledge):在大脑中形成一张类似地图的全局认知,使我们能够规划捷径或绕行。

BSC-Nav 框架巧妙地将这一生物学原理进行了计算化实现,其核心是三个协同工作的模块:

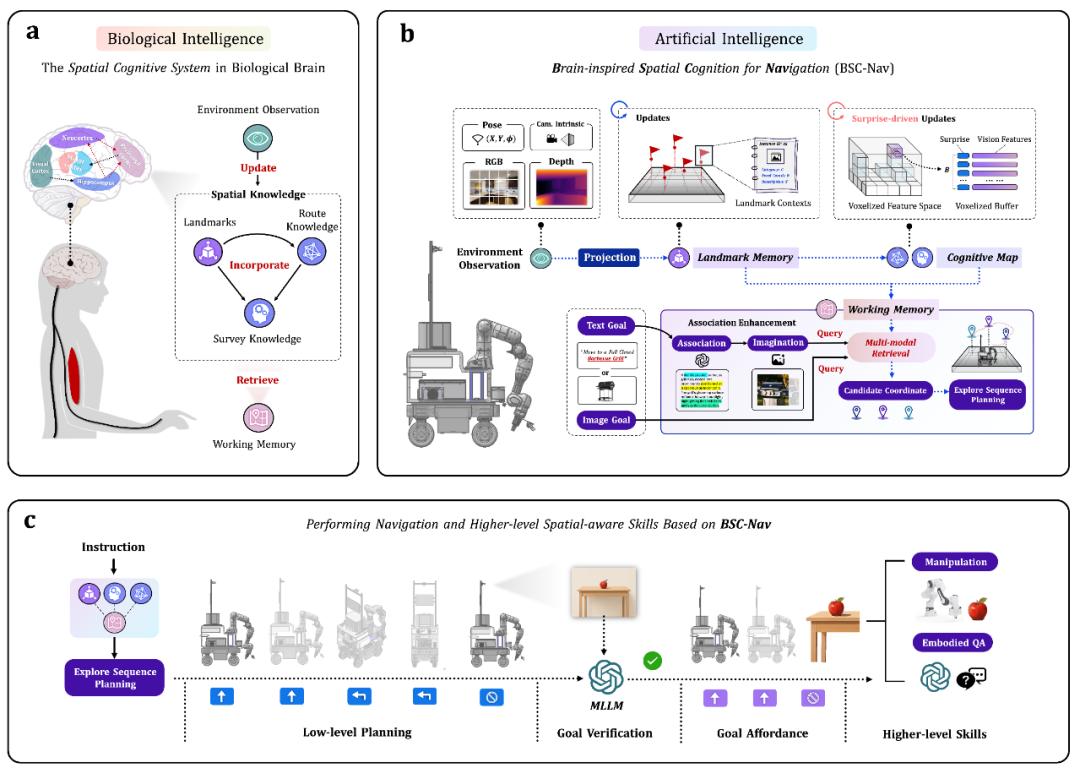

图:BSC-Nav 从生物空间认知汲取灵感(a),构建结构化空间记忆和检索机制(b),并与多模态大模型结合进行导航规划)

- 地标记忆模块(Landmark Memory Module):该模块采用开放词汇检测器(YOLO-World)识别环境中的显著物体(如沙发、桌子),并记录物体的类别标签、置信度、投影后的空间位置,形成稀疏而高效的「地标」记忆。同时,在每次记录后都会进行坐标重合检测与地标合并,确保每个记录的物体对应环境中的唯一实例。

- 认知地图模块(Cognitive Map Module):这个模块更进一步,通过 DINO-V2 实时编码观测图像的 patch 特征,并投影至统一的体素化网格空间中,每个网格都具有特征缓存池以容纳来自不同视角、不同时期观测的视觉特征。它将智能体的路径观测(路线知识)转化为全局一致的「认知地图」(勘测知识)。该模块采取了「意外驱动」(surprise-driven)的策略。这意味着只有当观察到的新信息与现有记忆产生足够大的「意外」或偏差时,系统才会更新认知地图。这种机制极大地提升了记忆效率,避免了对重复信息的冗余存储。

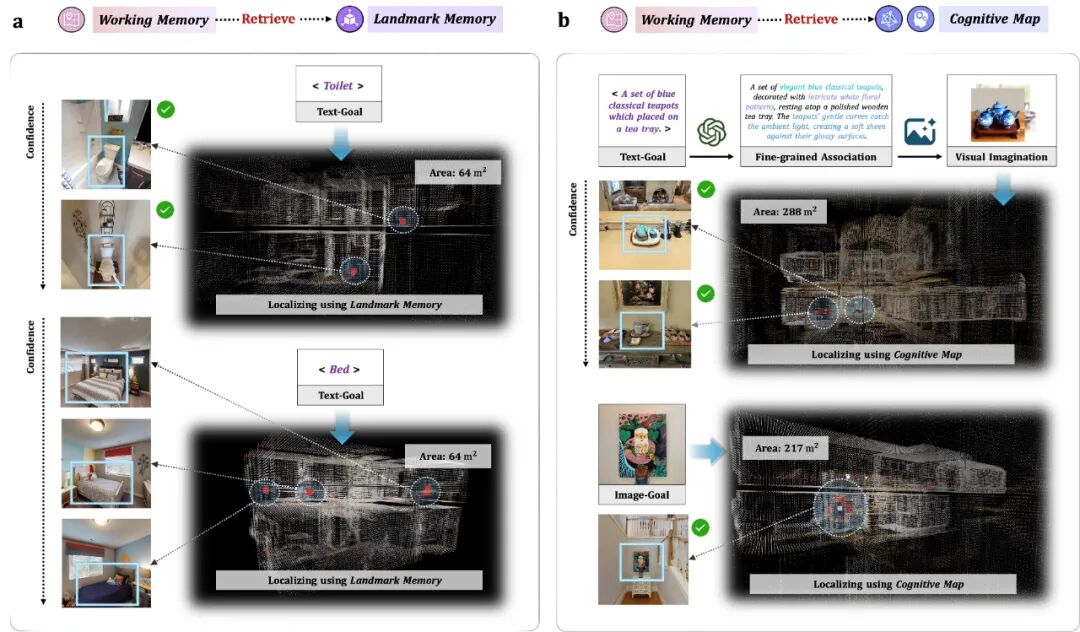

- 工作记忆模块(Working Memory Module):这一模块实现了人脑视觉-空间工作记忆的功能,用于检索、重构与具体任务相关的空间记忆。当接到任务时(比如「去冰箱拿瓶牛奶」),工作记忆模块会根据指令的复杂程度,决定是从「地标记忆」中快速检索,还是在「认知地图」上进行更复杂的规划。模块中设计了「联想增强」(association-enhanced)的检索策略。对于模糊指令,比如「去那个放着蓝色古典茶壶的桌子」,即使从未精确记录过「蓝色古典茶壶」,系统也能通过多模态大模型丰富指令细节,并依赖图像生成「脑补」出目标的视觉特征,再将其与认知地图中的视觉信息进行匹配,从而实现精准定位。这赋予了智能体前所未有的推理和与泛化能力。

图:工作记忆对不同模态、不同复杂度的目标进行空间位置进行精确定位

碾压式性能提升:多项导航任务刷新纪录

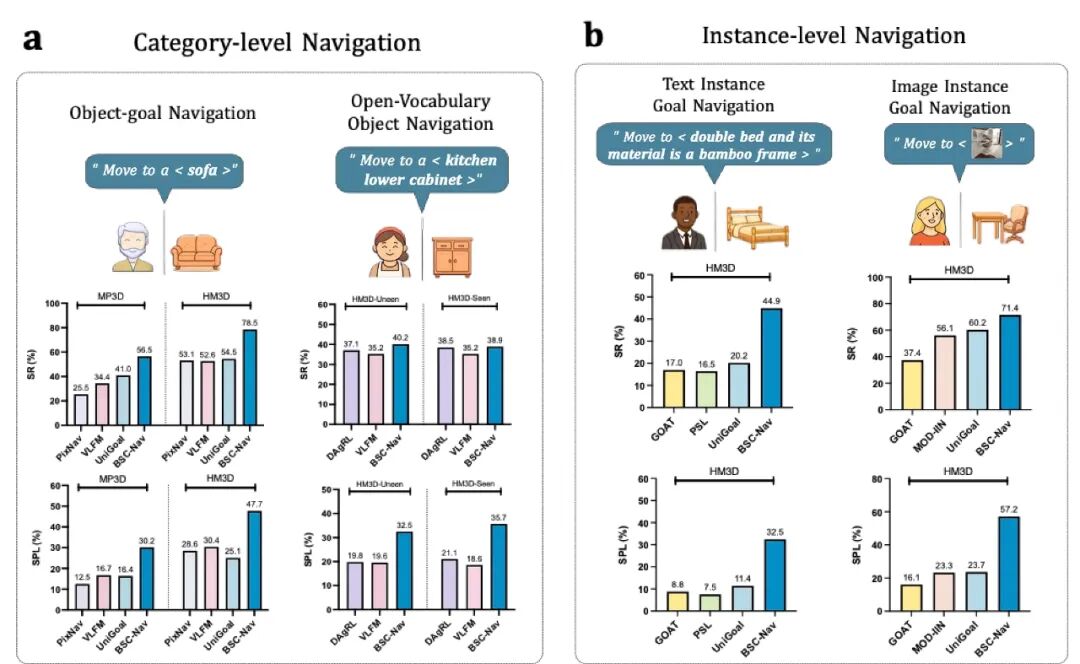

为了全面验证 BSC-Nav 的能力,研究团队在 Habitat 物理仿真环境中,针对四大主流导航任务(目标导航、开放词汇导航、文本实例导航、图像实例导航)进行了覆盖 62 个场景、多达 8195 个导航片段的大规模实验。

结果显示,BSC-Nav 的性能实现了「碾压式」的超越,在各项任务中均超越了以往方法。

图:BSC-Nav 在物体导航、开放词汇导航、文本实例导航和图像实例导航四大基准均实现新的 SOTA

如上图所示,无论是在导航成功率(SR)还是路径效率(SPL)上,BSC-Nav 均显著优于当前领域的顶尖方法。它不仅「找得到」,还「走得快」。例如,在物体导航(OGN)任务中,BSC-Nav 在 HM3D 数据集上的成功率高达 78.5%,比此前的 SOTA 方法 UniGoal 高出整整 24.0%。在更具挑战性的文本实例导航(TIN)任务中,BSC-Nav 更是将成功率提升了近一倍,展现了其强大的多模态理解与定位能力。

更进一步:轻松拿捏复杂导航指令与烧脑提问

强大的空间记忆与多模态大模型的深度融合,赋予了智能体一个能够推理并执行复杂任务的「超级大脑」。它不再只是被动执行单点指令,而是能够理解并拆解长序列任务,甚至能主动探索环境,回答具有空间逻辑的「烧脑」难题。

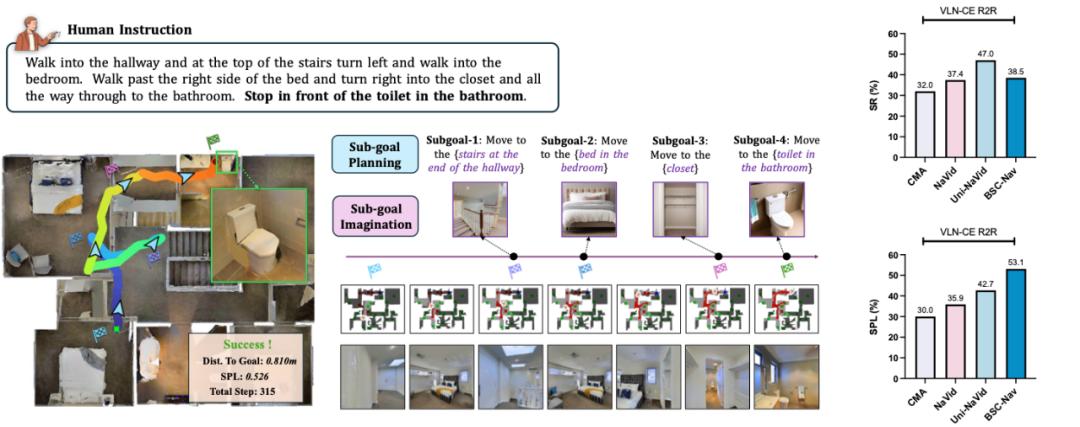

面对「穿过玻璃门,从沙发和咖啡桌中间走过去,走到冰箱那,然后右转停在楼梯口」这样的长指令,多模态大模型能够智能地将其分解为一系列清晰的子目标(路标点),随后 BSC-Nav 便能像执行多站点任务一样,精准地依次抵达。在权威的长指令导航基准 VLN-CE R2R 中,BSC-Nav 的零样本(zero-shot)表现已非常接近需要大量监督数据训练的顶尖模型,且导航效率(SPL 53.1%)远超所有对手!

图:BSC-Nav 针对复杂指令下的视觉语言导航任务表现出色

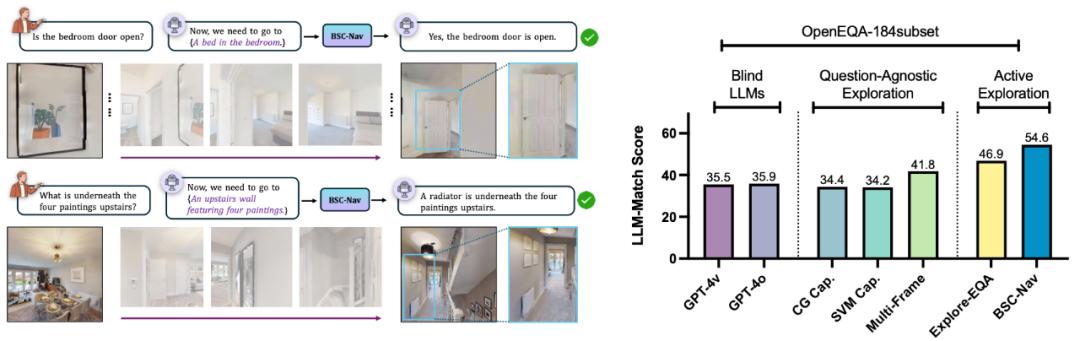

更令人印象深刻的是,当被问及「楼上那四幅画下面是什么?」这类需要主动探索和空间推理的问题时,BSC-Nav 能够准确解析问题中的关键实体「四幅画」,主动导航至二楼相应位置,通过仔细观察找到答案,并给出「四幅画下面是一个散热器」的精准回答。在主动具身问答(A-EQA)基准上,BSC-Nav 的表现显著超越了所有基线方法。

图:BSC-Nav 在主动视觉问答基准上的表现超越现有基线方法

从理解长指令到主动回答空间问题,BSC-Nav 展现了从「感知」到「认知」的质的飞跃。它不仅知道「去哪里」,更理解「为什么去」以及「去了之后做什么」,这正是通往通用人工智能所需要的、真正的认知智能。

走向现实:真机实测,导航、移动操作信手拈来!

仿真中的优异表现,能否迁移到充满不确定性的真实世界?这是所有具身智能研究者最为关心的问题,BSC-Nav 给出了肯定的答案!

为了研究在真实环境下的性能,研究团队和松灵机器人团队专门打造了一台集感知、导航和操作于一体的移动机器人平台,并在一个面积约 200 平方米的双层真实室内环境中,对 BSC-Nav 进行了严苛的实地测试。

实验结果再次证明了 BSC-Nav 的强大泛化性。无论是根据简单的物体名称、复杂的文本描述,还是模糊的参考图片进行导航,机器人都能精准、高效地到达目的地。在 15 个不同目标的 75 次随机起点测试中,BSC-Nav 实现了高达 80% 以上的导航成功率(任务成功定义为最终停止位置距离目标小于 1 米)。

此外,得益于其强大的空间认知能力,BSC-Nav 能够无缝衔接复杂的移动操作任务。在演示中,机器人不仅能完成清理桌面、搬运饼干盒等任务,还能执行开篇提到的、包含三次导航和三次操作的「制作早餐」任务。

One More Thing

这项研究最大的启示是什么?

具身智能的进化,或许并不完全依赖于算力和参数的无限堆砌。

生物亿万年的演化已经向我们展示了足够强大和高效的智能范式。正如团队在论文中所写道的:

「从被动响应到主动认知,BSC-Nav 证明了一件事:让机器理解空间,记忆是关键(From reactive behavior to cognitive spatial intelligence, memory is the key)。」

下一步?团队计划将这套类脑记忆框架扩展到更动态的环境和更复杂的认知任务中。

也许在不久的将来,当机器人管家为你做早餐时,它不仅能找到食材,还能记住你昨天说过的「明天我想试试溏心蛋」。

毕竟,是记忆,让智能成为真正的智能。

团队介绍

该工作有两位共同一作,其中一位是来自于北京航空航天大学人工智能研究院的三年级直博生阮受炜,他同时是清华大学 TSAIL 课题组访问博士生,师从韦星星教授、苏航教授。研究方向为深度学习鲁棒性、多模态大模型与空间智能。此前在 IEEE TPAMI、ICCV、ECCV 发表论文 10 余篇,曾获国家奖学金、西电特等奖学金荣誉。

另一位是来自于清华大学心理与认知科学系的助理教授王立元,他先前是清华大学 TSAIL 课题组的博士生和博士后。研究兴趣包括持续学习、终身学习和类脑智能,研究成果以第一/通讯作者发表在 Nature Machine Intelligence、IEEE TPAMI、NeurIPS、ICLR、CVPR、ICCV 等期刊和会议,曾获 CAAI 清源学者、WAIC 云帆奖、WAIC 青年优秀论文奖等荣誉。

团队成员来自于北京航空航天大学和清华大学:阮受炜,王立元(指导老师),康彩新,朱淇惠,刘松铭,韦星星(指导老师,通讯作者),苏航(指导老师,通讯作者)。