实测一圈下来,结论是——如果你最近要写代码、搭 Agent、做原型,GLM-4.5 可能是 2025 年最值得先上手的国产大模型,没有之一。

这段时间国产 AI 模型非常热闹,各家都瞄着 Coding 和 Agent 场景,开源自己的最新模型。

是个好事,大幅拉近和国际模型的 Coding 差距。就是对用户来说,有些乱花渐欲迷人眼,不知该用啥。

周末提前测到了智谱新出的 GLM-4.5,体验后,觉得非常有必要单开一章安利。

文内所有配图,均为 GLM-4.5 通过前端代码生成,为自己配图

我精心设计了一些 Benchmark,对 GLM 进行了详细测试。

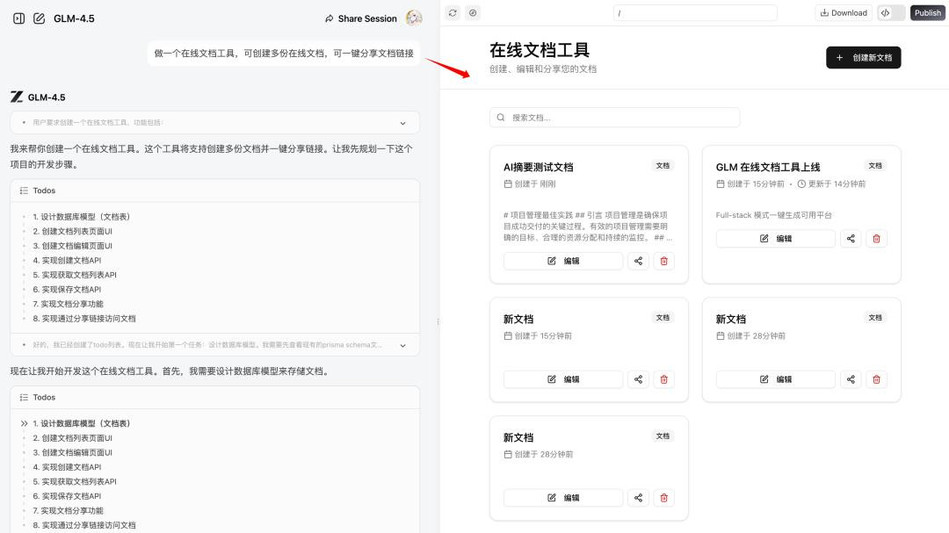

比如,这是用 GLM-4.5 一句话生成的在线文档平台,能创建、编辑,分享文档,甚至自动接入 AI 功能,提供 AI 摘要、AI 内容续写的能力:

也先分享这几个关键进步:

1. 在国内模型中率先支持推理的 Agentic 模型,需求指令理解更好了

2. 在较长上下文中,记忆保持还不错

3. 前端代码审美,持平或超过 Claude 4、Gemini Pro(而且后端构建也一点不弱)

4. 生成速度快,是真的快。快就是真谛,Coding 顺畅了很多。我会愿意把 GLM-4.5 作为近期的主力 Coding 模型。

用一句话说:如果有 Coding、Agent 任务需求,值得上手自测,我觉得不会浪费时间。

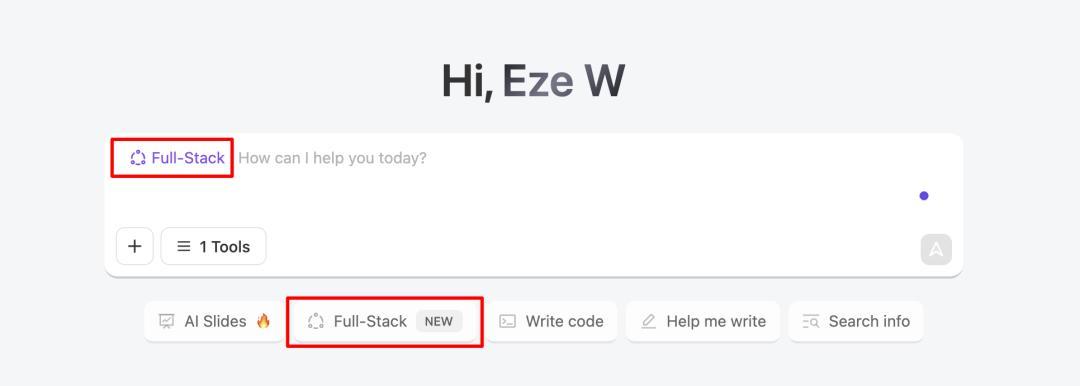

尤其是 z.ai 还提供了一个非常好用的 Full-Stack 模式,能在网页对话中,一句话直接构建带前后端、AI 能力的多页面应用。

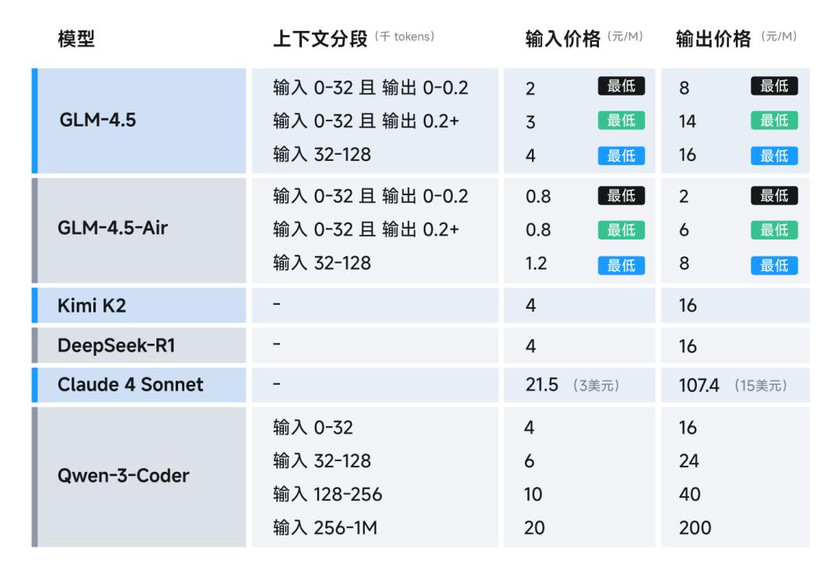

先一图流了解 GLM-4.5 参数、价格

智谱一共发了 3 款模型:

GLM-4.5,大杯,355B-A32B;GLM-4.5-Air,中杯,106B-A12B;GLM-4.5-Flash,完全免费。

把官方介绍制作为一图流,方便查看:

有几个点可以留意:

- 大杯参数仅有DeepSeekR1的1/2,KimiK2的1/3

- 单轮最大输出9.8wtoken,生成速度非常快,高速版每秒达100tokens

- 全面开源,采用最宽松的MITLicense(任何人只要在软件中保留原始版权声明,即可随意商用分发)

特别的,关于价格:

- 旗舰版在最大输入输出下,结合官方的5折活动,也低至输入2元/百万tokens,输出8元

- 以及GLM-4.5-Flash,中小开发者可以留意下,完全免费

也就是说,只要实测效果良好,GLM-4.5 综合优势就将稳居现阶段的国产 Agentic 模型前列。

💻 横测 GLM-4.5 水准:基础代码生成

还是那句话:SOTA 并不直观,还得体感实测,更能给自己试着切换主力模型的信心。

我直接把 GLM-4.5 和当红 Kimi K2、Qwen3-coder,以及老员工 Gemini 2.5 Pro、Claude Sonnet 4 拿出来尽可能做一下对比。

考虑到横测对象均为旗舰版,GLM 也默认旗舰版。每项测试的 Prompt 均会附在测试小节的末尾。

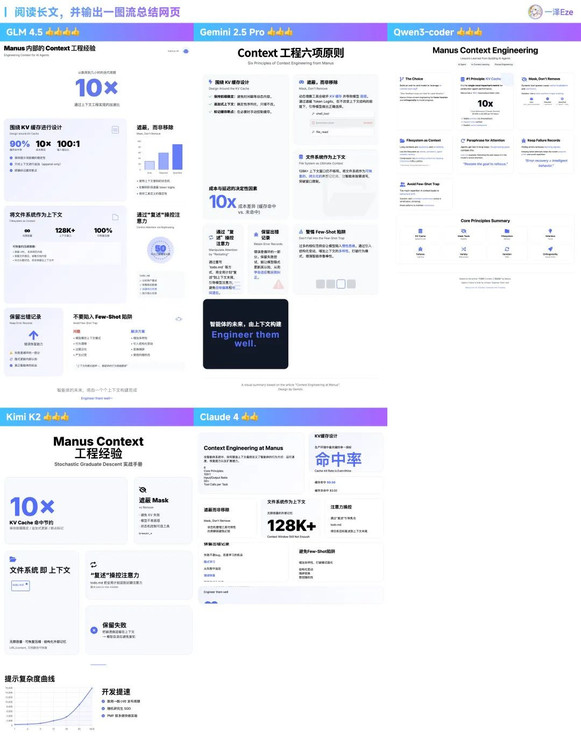

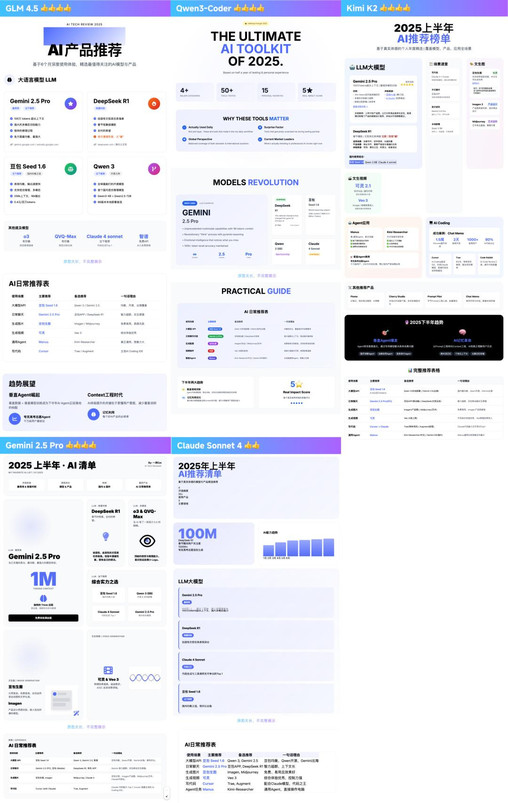

1)长上下文注意力与前端设计:一图流生成对比

这是我最喜欢的快速实测,让模型阅读一篇长文,自行提炼关键内容,并生成便于阅读的一图流网页。

同时考验模型的逻辑分析、长上下文记忆保持、幻觉问题,以及前端 Coding 的质量与设计审美。

测了一些 Case,举两个例子:

1. 先是总结我翻译的 Manus Context 工程经验,5000 字左右:GLM 4.5 表现良好,内容要点总结精准,有比较积极的配图倾向

2. 然后试了下更长的万字 2025 上半年AI 产品推荐的长文:GLM 4.5 在更长文的任务中,关键要点提炼、布局呈现优秀,无幻觉

总结更多次反复测试的体感如下:

- 从内容取舍与排版理解上来说:GLM-4.5、Gemini由于支持Thinking,相对于国产NoThinking模型更占优势。

- 看前端样式:更多次测试中,GLM-4.5、Gemini2.5Pro给出的设计下限普遍更高(其他几家也不差)。

- 说起均衡生成速度:GLM-4.5的速度应该是最快的一档,这个给Coding带来的体验就很好。众所周知,AICoding离不开多轮渐进与递归提示,生成太慢容易抓瞎和暴躁。速度大于or约等于Gemini2.5Pro、Qwen

所以这个任务里优选推荐模型的话,体感排序:GLM-4.5 ≈ Gemini 2.5 Pro > Kimi K2 ≈ Qwen3-Coder > Claude Sonnet 4

BTW:如果有兴趣测试,或有做图需求,这是同款 Prompt:

## 以下是我的文章:

[粘贴文章内容]

## 任务

我是[个人身份、作图用途]。请阅读我的文章中的要点,帮我用类似苹果发布会PPT的Bento Grid风格的视觉设计生成一个中文动态网页展示,具体要求为:

– 尽量在一页展示全部信息,背景为白色、文字和按钮颜色为纯黑色,高亮色为#4D6BFE

– 强调超大字体或数字突出核心要点,画面中有超大视觉元素强调重点,与小元素的比例形成反差

– 网页需要以响应式兼容更大的显示器宽度比如1920px及以上

– 中英文混用,中文大字体粗体,英文小字作为点缀

– 简洁的勾线图形化作为数据可视化或者配图元素

– 运用高亮色自身透明度渐变制造科技感,但是不同高亮色不要互相渐变

– 数据可以引用在线的图表组件,样式需要跟主题一致

– 使用HTML5、TailwindCSS 3.0+(通过CDN引入)和必要的JavaScript

– 使用专业图标库如Font Awesome或Material Icons(通过CDN引入)

– 避免使用emoji作为主要图标

– 不要省略内容要点,禁止编造文内未出现的数据

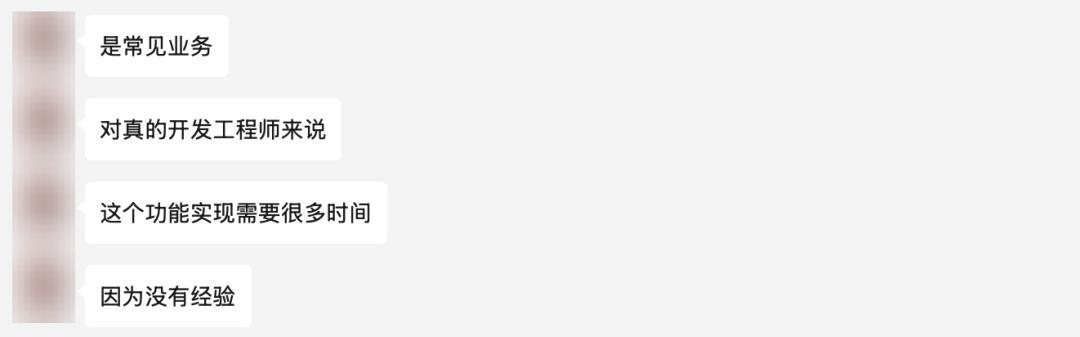

2)多项复杂指令遵循:一次性生成富交互工具

在 AI Coding 的实际任务里,大部分情况是给 AI 一大段话,里面包含复数个需求,考验复杂指令遵循度。

挑战一个复杂的前端富交互的编辑器开发任务。要求 AI 一次性生成一个可增删、拖拽、改字体、颜色、大小的内容编辑器。

并对 UI 样式进行特定要求:“实用主义设计风格、中性灰配色”

该任务的复杂度,主要在一次性需要完成多项要求,实现复杂的 UI 交互、DOM操作、对应用状态、以及 UI 样式的精确控制。

对真人开发来说,从头开发比较麻烦,一般会选择找开源组件改一下,而不会费劲造新轮子。(下面是我资深前端开发朋友的看法)

以下是 5 个 AI 的执行结果:

- 从任务要求完成度来看:ClaudeSonnet4实现了全部要求。GLM-4.5只有1项未完成要求,整体表现靠前。

- 样式遵循方面:各家对于轻量设计要求,基本都复原的不错,可cover常见coding任务。

- 任务完成速度:最快还是GLM-4.5,比较慢的是KimiK2(但这个很难说严谨,因为官方服务负载也会有影响)

体感排序:Claude Sonnet 4 > GLM-4.5 > Kimi K2 > Qwen3-Coder = Gemini 2.5 Pro

(Kimi 因为当前生成速度,不得不降点分)

测试 Prompt(由于要求比较复杂多样,每次偏差会有些偏差,上文举例取均值表现):

请为我创建一个简单的拖拽式网页内容构建器。

功能要求:

1)界面分区:左侧是一个“组件”面板,包含几个可拖拽的元素,如“标题”、“段落”、“代码块”、“按钮”。右侧是一个“文章画布”区域

2)拖拽与放置 (Drag & Drop):用户可以从左侧面板将组件拖拽到右侧画布中,并能放置在画布的不同位置

3)动态渲染:组件被放置到画布上后,应立即渲染成对应的 HTML 元素

4)内容编辑:用户可以直接点击画布上的文字类组件,并就地编辑 (in-place editing) 其文本内容

5)属性配置:当用户选中画布上的某个组件时,组件右上角显示删除按钮,点击后可删除组件;画布右侧弹出一个简单的属性面板:可切换字体(衬线体和非衬线体 2种)、字体大小、对齐方式(左、右、居中)、颜色

6)组件排序:画布上的组件支持拖拽更改排序7)数据结构:整个画布的内容需要能被序列化成一个 JSON 结构8)实时数据结构视图:画布下方常驻一个“数据结构”面板。以格式化后的代码块形式,实时显示当前画布所有内容的完整 JSON 结构。当我对画布进行任何操作(新增、删除、修改内容、拖拽排序)时,这个 JSON 视图都必须立即、准确地同步更新

样式要求:采用现代简约的实用主义设计风格:使用中性灰色调配色方案,清晰的功能分区布局,充足的留白和8-20px间距,微妙的交互动效(悬停时轻微位移+阴影),圆角边框(4-8px),功能性优于装饰性,注重信息层次和操作流畅性

严格按以上要求开发,禁止添加其他功能,禁止忽略以上任何要求

💎 Full-Stack 模式: 重头戏,比模型更惊喜

测试完基础性能后,非常非常非常值得一提的是:

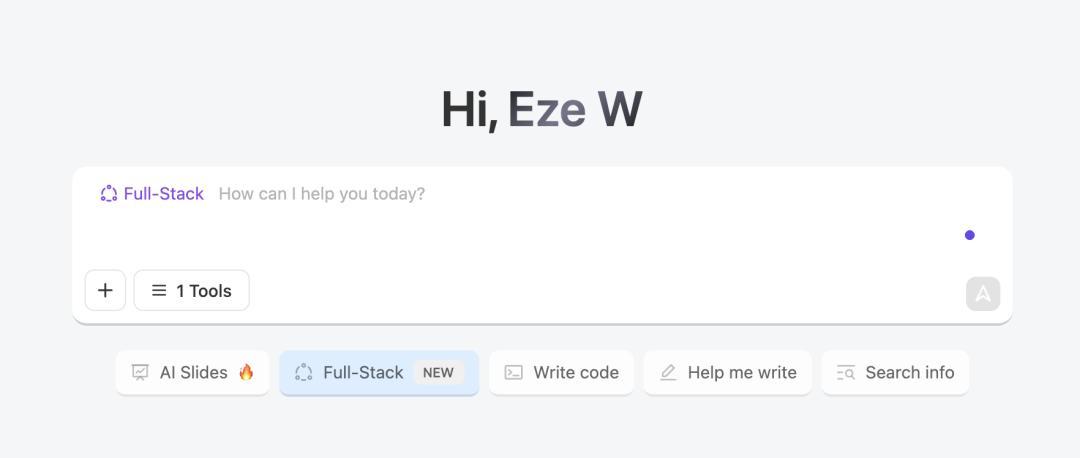

除了通过 Chat 或 API 调用GLM-4.5 之外,z.ai 官网还提供了一个方便创作者的「Full-Stack」全栈模式。

你可将其理解为类似 Lovable、Bolt.new 的功能模式。

能够在网页对话中,一次性生成带有前后端的全栈、多页面应用,并发布到公网上。无需配置开发环境,也不用考虑部署问题。

测试如下:

1)创建一个可在线分享的在线文档应用

比如文章开头的在线文档应用,使用的就是 Full-Stack 模式,在网页对话中花了 10 分钟一次性生成的应用 Demo。

任务记录:

https://chat.z.ai/s/29968fdc-53f2-4605-ae71-4ae32e920ca4

做一个在线文档工具,可创建多份在线文档,可一键分享文档链接

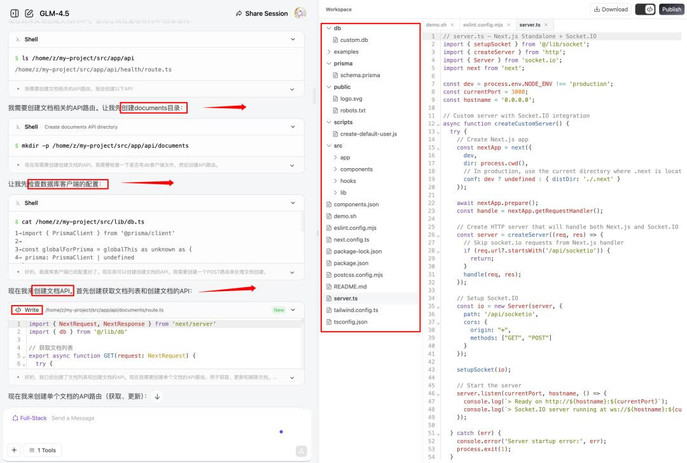

在这个过程中,GLM-4.5 就如同“云端” Cursor、Windsurf 一样, 自行规划任务步骤、读取应用空间内的文件目录与内容。

并自行创建、编辑不同类型的代码文件,实现完整应用构建。

如果有新迭代需求,或对某个功能/Bug 不满意,也能直接自然对话,提出要求反复修改。

在这个模式下,AI 还会自行展开顺畅的测试,自动改进迭代中可能的 Bug。

全过程无需人为提示 Debug,直出了 100% 可用的预期应用。

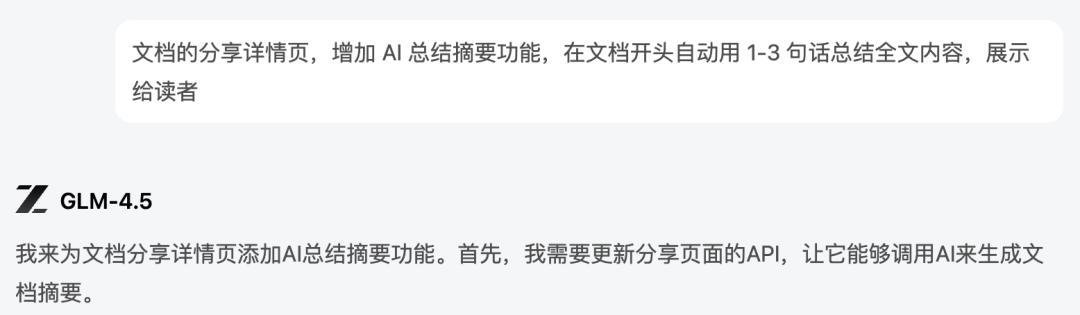

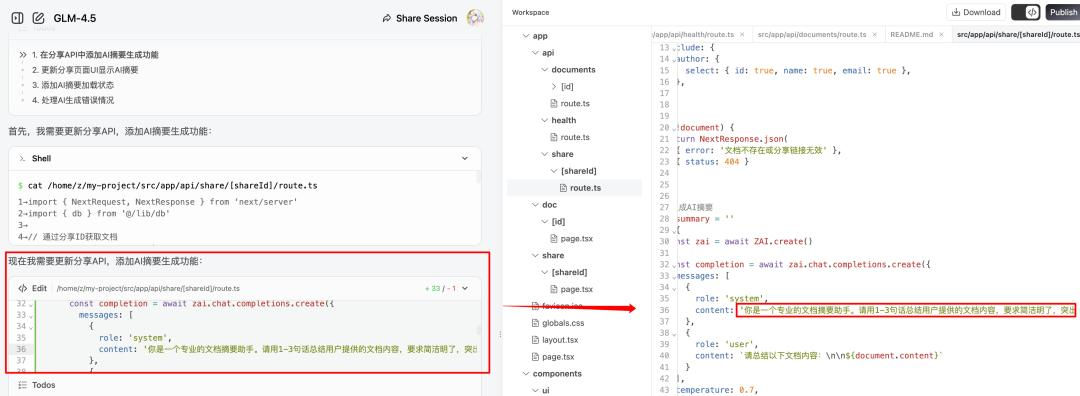

2)更高要求:让 AI 自己,做 AI 功能

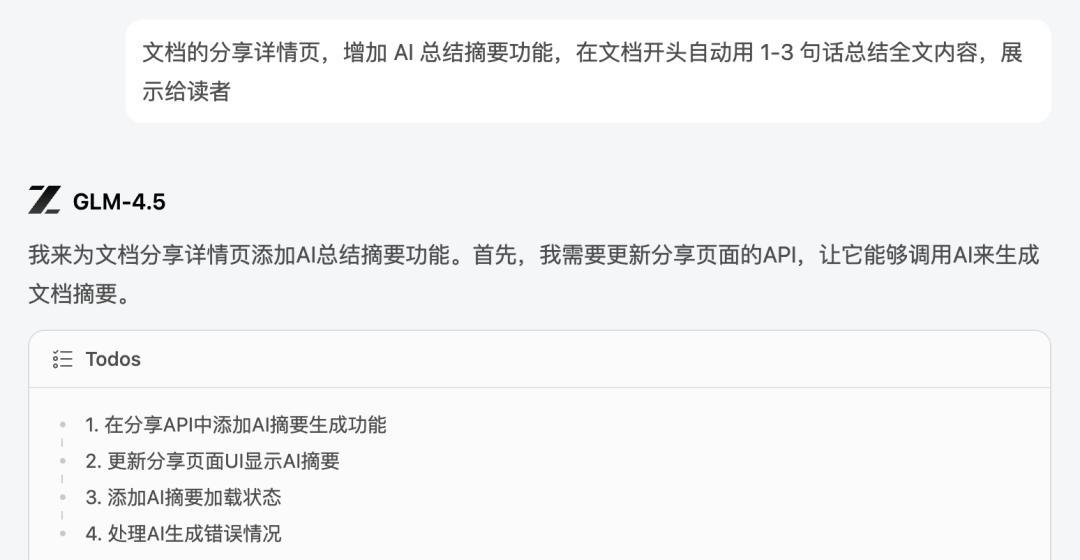

顺应 AI 应用开发潮流,你还可以让 GLM-4.5 在应用中,自行添加 AI API,按口头需求编写 Prompt,构建 AI 功能。

我也做了一系列测试,比如在文档详情页添加 AI 自动摘要功能:

直出的效果大概是这样的,能够根据文章内容与编辑情况,在发布后自动更新 AI 摘要:

测试下来,可用率 100%

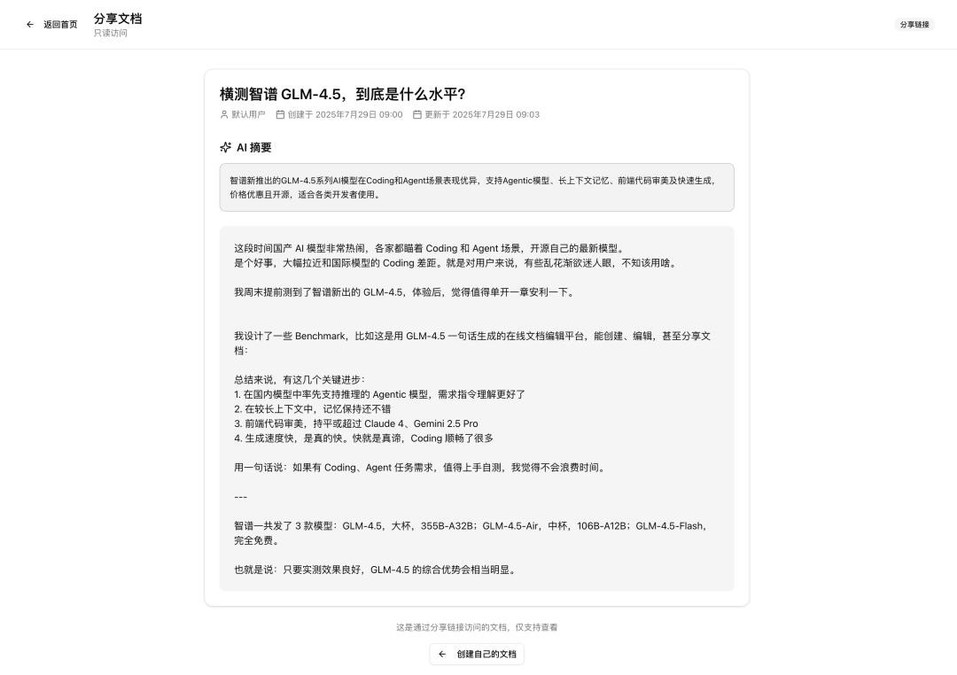

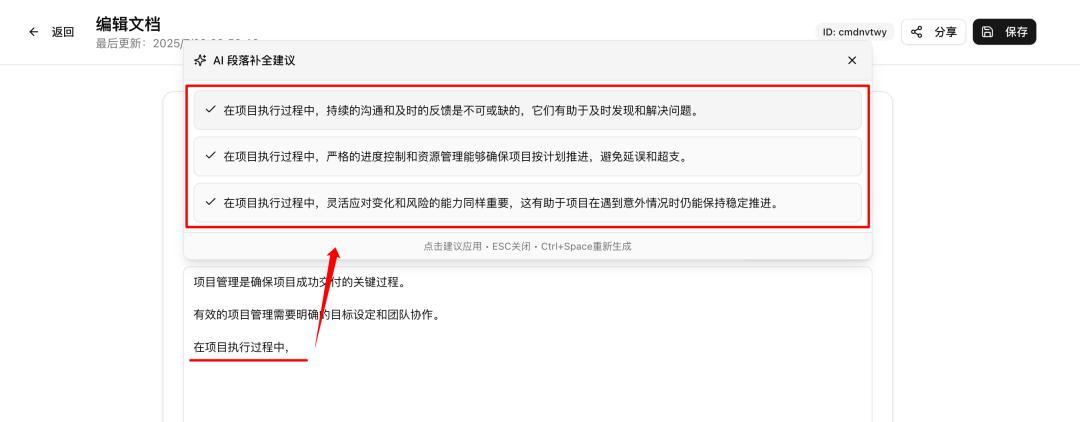

再进一步难度,AI 段落补全:

即编辑文档时,实时读取上文内容,提供 AI 段落补全建议

而下图就是开发效果,也是在 2 轮自然要求内,完美达成了预期目标:

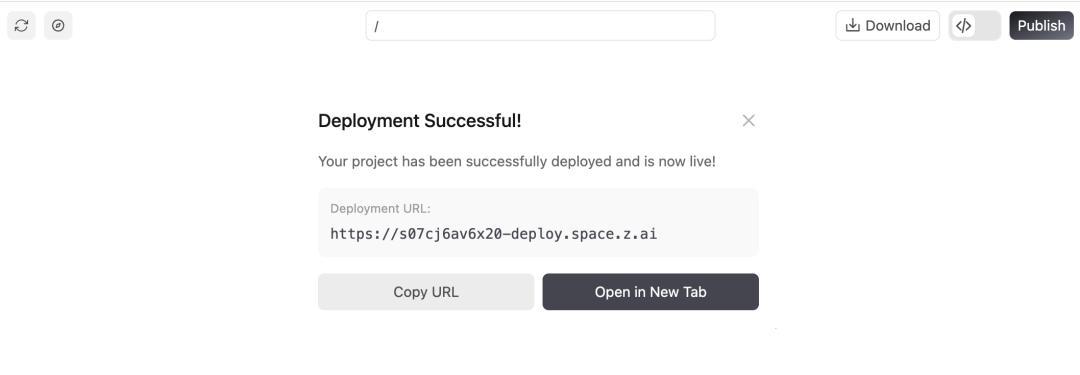

3)一键部署服务到公网

如果你喜欢自己的 Coding 结果,别忘了在 Full-Stack 模式右上角点一下「Publish」,就可以一键把服务部署到公网,分享给更多用户使用:

注意:

自从昨天 GLM-4.5 公开发布后,因为反响相当不错,官方服务短期有波动,可能会出现 AI API 报错。遇到了可以刷新页面后,发送“继续”或点击“重试”按钮以推进任务。

Coding 成果在 Publish 后,可能会出现多页面跳转问题,官方正在修复中。(Preview 下没问题)

当然,这些 Coding 效果当然不只是在 Full-Stack 模式下才能达到,更多是 GLM-4.5 基模的自身能力。

下面我也整理推荐了一些使用 GLM-4.5 的方法,任何人都能找到合适的选择。

👉 GLM-4.5 使用途径推荐

如果你是非技术用户:首推 z.ai

不知不觉中,z.ai 官方 Chat 平台做得相当好了。

特别是上文详细测试的 Full-stack 模式,这可能是现在国内最适合新手体验 Vibe Coding 的平台。

享受同等 Claude 3.7 效果的 Coding 能力,但无需访问外网、无需下载软件、也不用配置服务器环境,完全免费,就能直接在网页中,用对话生成带前后端的轻量应用,并发布给所有小伙伴使用。

真的非常简单,不需要一点代码知识,建议由此入门尝试 AI Coding 创造万物 Demo 的感觉。

体验地址:https://chat.z.ai/ ,别忘了左上方勾选模型为 GLM-4.5(也可以试试 GLM-4.5-Air,也不弱)

如果是开发者:GLM 版 Claude code

7 月份的国产模型,基本都借着兼容 Anthropic API 格式,无缝支持了 Claude Code。

GLM-4.5 也不例外。

特别值得一提:我实际用下来 GLM 版 Claude Code 十分稳定,测到现在从未出现过 tool use 能力不足,导致的任务失败 的情况。生产速度、任务成功率都相当不错,推荐试用

体验渠道:

1. 在开放平台获取智谱 API Key:

https://open.bigmodel.cn/usercenter/proj-mgmt/apikeys

2. 正常安装 Claude Code,然后运行:

export ANTHROPIC_BASE_URL=https://open.bigmodel.cn/api/anthropic

export ANTHROPIC_AUTH_TOKEN=”your bigmodel API keys”

3. 输入 Claude,启动 GLM-Code 即可

另外,按照 Cursor、Windsurf、Trae 之前接入 Kimi K2 的速度, 在这三者上直接用上 glm-4.5 应该也不需要等上多久了。(Cline 感觉已经比不上其他 AI Coding 产品,遂不再推荐)

🎐 写在最后

这篇文章就不上价值了,因为 GLM 进步本身已经非常明显。

在整个 7 月中,我们都能明显感受到国产模型在 Coding 能力上,纷纷大幅拉近了和 Claude 4 之间的代差。

而在这两天的 GLM-4.5 测试中,其实我最高频的反应是:

- 等等,这还是GLM模型吗?

- 这测下来,体感这是要现阶段国产Coding模型Top1的节奏了?

- 到底是不是我测得还是不够充分,只是刚好没测到短板上?

行文至此,姑且大着胆子,下点个人测试结论:

- 体感判断,在较为完整的中小项目中,GLM-4.5的能力,应该介于Claude3.7~4之间。

- 结合成本、速度、质量,GLM-4.5或许就是当下国产Coding模型的TOP1。

GLM-4.5 带着最低的 API 价格、超快的模型速度,以及接近国际领先的 Coding 能力来了。(群友评论 ⬇️)

可以预见,这个月国内各家 Agentic 模型的进步,将大幅推进国内依赖 AI 代码生成场景的应用推广进度。(无论是 AI Coding 的开发者接受度,还是相关 Agentic 产品应用)

还是那句话,只要你有 Coding、Agent 任务需求,值得上手自测,我觉得不会浪费时间。

也很期待你的实测反应与反馈。

本文由人人都是产品经理作者【一泽Eze】,微信公众号:【一泽Eze】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议。