不圆 发自 凹非寺

量子位 | 公众号 QbitAI

Qwen最近属实声势不小,开源方面刚靠Qwen3-Coder炸场,在翻译领域也卷出花:

更快响应速度、更低价格,阿里云百炼最新翻译模型Qwen-MT现已开放,主打一个高性价比。

先看价格:

根据官方介绍,该模型的核心亮点包括:

- 支持超过92种主流官方语言及重要方言之间的高质量互译

- 提供术语干预、领域提示、记忆库等专业翻译功能,并支持用户自定义提示

- 采用轻量级MoE架构,在保证卓越性能的同时实现更快的响应速度和更低的API调用价格

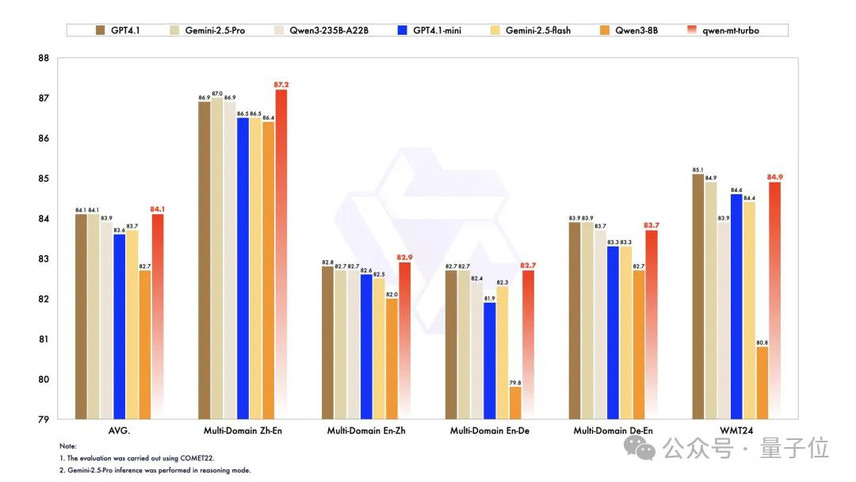

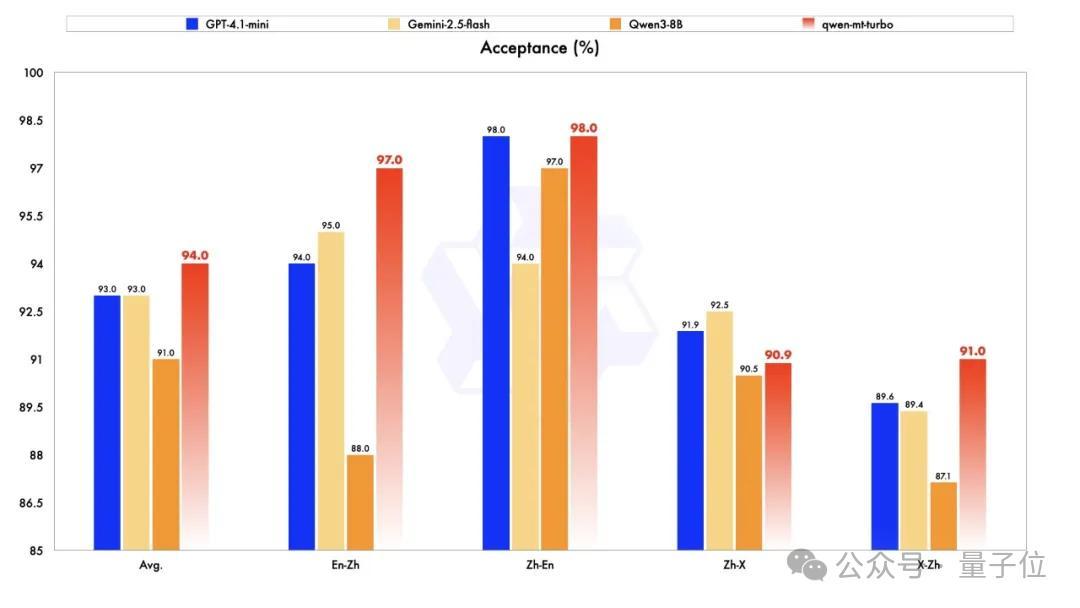

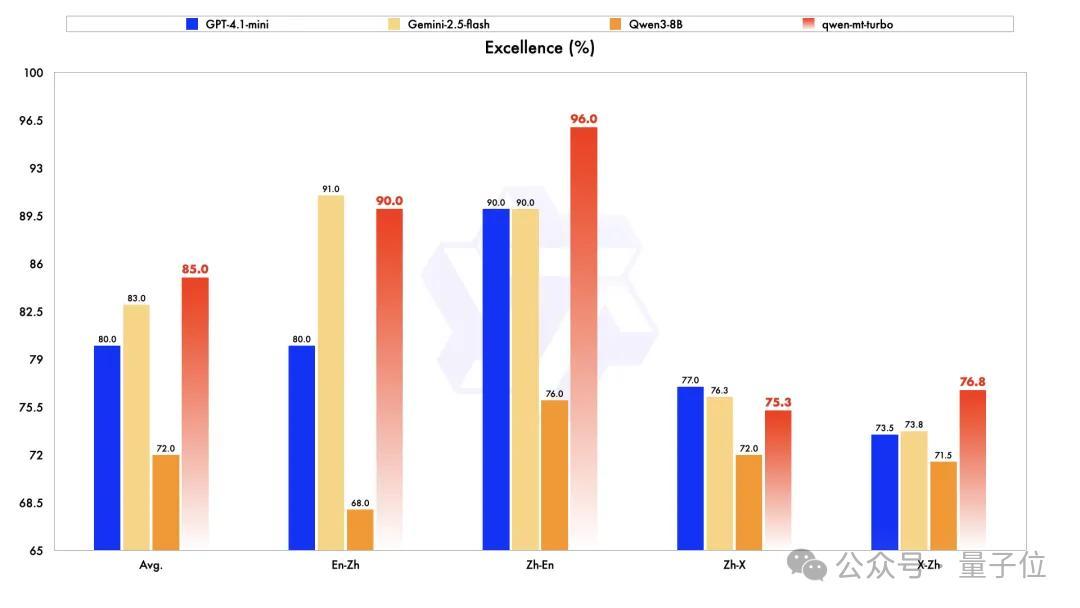

该模型在自动评估和人工评估的翻译任务中都取得了不错的结果。

量子位实测:响应速度很快,回译准确性较高,可手动调整翻译风格。

让我们看一下它的具体表现。

实测效果

我们调用了Qwen-MT-Turbo的API,在本地文档中进行测试,详细用法可见文末。

中英互译

让Qwen-MT把中文原句翻译成英文,再把翻译后的结果重译为中文,用回译检验的方法看看效果如何。

我们将逐渐提高句子的复杂程度,并在得到结果后总结翻译的平均用时(中译英+英译中,使用了python的time模块)。

当生命以美的形式证明其价值的时候,幸福是享受,痛苦也是享受。(史铁生《我与地坛》)

中译英:When life proves its value in the form of beauty, happiness is enjoyment, and suffering is also enjoyment.

英译中:当生活以美丽的形式证明其价值时,快乐是享受,痛苦也是享受。

平均用时:0.71s

叶子本是肩并肩密密地挨着,这便宛然有了一道凝碧的波痕。叶子底下是脉脉的流水,遮住了,不能见一些颜色;而叶子却更见风致了。(朱自清《荷塘月色》)

中译英:The leaves were originally closely packed side by side, and now they seemed to form a clear green wave-like pattern. Beneath the leaves flowed a gentle stream of water, obscuring any visible color; yet the leaves themselves appeared even more graceful.

英译中:叶子原本紧密地并排生长,现在看起来却形成了一道清晰的绿色波浪状图案。叶子下面流淌着一股柔和的水流,使任何颜色都难以辨认;然而,这些叶子本身却显得更加优雅。

平均用时:0.86s

秦人不暇自哀,而后人哀之。后人哀之而不鉴之,亦使后人而复哀后人也。(杜牧《阿房宫赋》)

中译英:The people of Qin did not have time to mourn for themselves, yet later generations mourned for them. If later generations mourn for them without learning from their mistakes, they will also cause future generations to mourn for them again.

英译中:秦人没有时间为自己哀悼,但后世却为他们哀悼。如果后世哀悼他们却不吸取他们的教训,那么他们也会使后世再次为他们哀悼。

平均用时:0.77s

若夫日出而林霏开,云归而岩穴暝,晦明变化者,山间之朝暮也。野芳发而幽香,佳木秀而繁阴,风霜高洁,水落而石出者,山间之四时也。(欧阳修《醉翁亭记》)

中译英:When the sun rises and the forest mist disperses, and when clouds return and the mountain caves darken, these changes between brightness and darkness mark the morning and evening in the mountains. When wild flowers bloom and emit a subtle fragrance, when fine trees flourish and cast abundant shade, when winds and frosts are crisp and clear, and when water recedes and rocks emerge—these are the four seasons of the mountains.

英译中:当太阳升起,森林中的薄雾散去;当云朵归来,山洞变得幽暗,这些明暗交替的变化标志着山间早晚的更替。当野花盛开,散发出淡淡的芬芳;当茂密的树木繁盛,投下浓荫;当风霜清冽而明朗;当水位退去,岩石显露出来——这些都是山间的四季。

平均用时:1.05s

名句对比

让Qwen-MT把外国文学的原句翻译成中文,和名家的翻译结果进行对比,看看它对不同语言情境的把握。

我们选取了英语、俄语、西班牙语和拉丁语的名著原文及它们著名的译本,自动识别语言,并记录了每次翻译的用时。

The trumpet of a prophecy! O Wind, If Winter comes , can Spring be far behind?(雪莱《西风颂》)

穆旦译文:把昏睡的大地唤醒吧!要是冬天已经来了,西风呵,春日怎能遥远?

翻译结果:预言的号角!啊,风啊,冬天来了,春天还会远吗?

用时:0.65s

To be, or not to be -that is the question.Whether ’tis nobler in the mind to suffer the slings and arrows of outrageous fortune, Or to take arms against a sea of troubles, and by opposing end them? (莎士比亚《哈姆雷特》经典独白)

朱生豪译文:生存还是毁灭,这是一个值得考虑的问题;默然忍受命运暴虐的毒箭,或是挺身反抗人世无涯的苦难,通过斗争把它们扫个干净,这两种行为,哪一种更加高尚?

翻译结果:生存还是毁灭,这是一个问题。是默默忍受命运的无情打击,还是挺身反抗人世间的种种苦难,以斗争来终结它们?

用时:0.86s

Muchos años después, frente al pelotón de fusilamiento, el coronel Aureliano Buendía había de recordar aquella tarde remota en que su padre lo llevó a conocer el hielo.(马尔克斯《百年孤独》开头)

范晔译文:多年以后,面对行刑队,奥雷里亚诺•布恩迪亚上校将会回想起父亲带他去见识冰块的那个遥远的下午。

翻译结果:多年以后,在行刑队面前,奥雷连诺上校将想起那个遥远的下午,那时他的父亲带他去见识冰块。

用时:0.74s

Счастливая семья всем таким же, несчастливая семья соответственно имеет разницу фактическ!(托尔斯泰《安娜卡列尼娜》开头)

草婴译文:幸福的家庭家家相似,不幸的家庭各各不同。

翻译结果:幸福的家庭都一样,不幸的家庭各有各的不幸!

用时:0.66s

Nondum amabam, et amare amabam; quaerebam quid amarem, amans amare.(奥古斯丁《忏悔录》)

周士良译文:我还没有爱上谁,却已爱上了‘爱情’本身;我追求爱的对象,为的是能沉醉于爱中。

翻译结果:我尚未爱,却已渴望去爱;我正爱着,便在寻求自己所爱之物。

用时:1.00s

长文本翻译

让Qwen-MT把长篇文本(百字以上)进行翻译,看看它对长段文字的处理能力。

以英译中为例,我们选取了通俗小说、科研论文两种类型的长篇文本,并记录翻译用时。

It was the best of times, it was the worst of times, it was the age of wisdom, it was the age of foolishness, it was the epoch of belief, it was the epoch of incredulity, it was the season of Light, it was the season of Darkness, it was the spring of hope, it was the winter of despair, we had everything before us, we had nothing before us, we were all going direct to Heaven, we were all going direct the other way—in short, the period was so far like the present period, that some of its noisiest authoritiesinsisted on its being received, for good or for evil, in the superlativedegree of comparisononly.

翻译结果:这是最好的时代,也是最坏的时代;这是智慧的年代,也是愚蠢的年代;这是信仰的纪元,也是怀疑的纪元;这是光明的季节,也是黑暗的季节;这是希望之春,也是绝望之冬;我们面前应有尽有,我们面前一无所有;我们全都直奔天堂,我们也全都直奔相反的方向——总之,那个时期与现在的时期如此相似,以至于一些最吵闹的权威人士坚持认为,无论好坏,都必须以最高级的比较方式来对待它。

用时:1.30s

Large Language Models (LLMs) exhibit considerable promise in financial applications; however, prevailing models frequently demonstrate limitations when confronted with scenarios that necessitate sophisticated reasoning capabilities, stringent trustworthiness criteria, and efficient adaptation to domain-specific requirements. We introduce the Agentar-Fin-R1 series of financial large language models (8B and 32B parameters), specifically engineered based on the Qwen3 foundation model to enhance reasoning capabilities, reliability, and domain specialization for financial applications. Our optimization approach integrates a high-quality, systematic financial task label system with a comprehensive multi-layered trustworthiness assurance framework. This framework encompasses high-quality trustworthy knowledge engineering, multi-agent trustworthy data synthesis, and rigorous data validation governance. Through label-guided automated difficulty-aware optimization, tow-stage training pipeline, and dynamic attribution systems, we achieve substantial improvements in training efficiency. Our models undergo comprehensive evaluation on mainstream financial benchmarks including Fineva, FinEval, and FinanceIQ, as well as general reasoning datasets such as MATH-500 and GPQA-diamond. To thoroughly assess real-world deployment capabilities, we innovatively propose the Finova evaluation benchmark, which focuses on agent-level financial reasoning and compliance verification. Experimental results demonstrate that Agentar-Fin-R1 not only achieves state-of-the-art performance on financial tasks but also exhibits exceptional general reasoning capabilities, validating its effectiveness as a trustworthy solution for high-stakes financial applications. The Finova bench is available at this https URL.

翻译结果:大型语言模型(LLMs)在金融应用中展现出巨大的潜力,然而现有的模型在面对需要复杂推理能力、严格可信度标准以及高效适应特定领域需求的场景时,往往表现出局限性。我们推出了Agentar-Fin-R1系列金融大语言模型(参数量分别为8B和32B),该系列模型基于Qwen3基础模型专门设计,旨在提升金融应用中的推理能力、可靠性和领域专业性。我们的优化方法结合了高质量的系统化金融任务标签体系与全面的多层次可信度保障框架。这一框架包括高质量的可信知识工程、多智能体可信数据合成以及严格的数据验证治理机制。通过标签引导的自动化难度感知优化、两阶段训练流程以及动态归属系统,我们在训练效率上取得了显著提升。我们的模型在主流金融基准测试(如Fineva、FinEval、FinanceIQ)以及通用推理数据集(如MATH-500和GPQA-diamond)上进行了全面评估。为了深入评估其实际部署能力,我们创新性地提出了Finova评测基准,专注于代理级别的金融推理和合规性验证。实验结果表明,Agentar-Fin-R1不仅在金融任务上达到了最先进的性能,还展现了卓越的通用推理能力,证明了其作为高风险金融应用可信解决方案的有效性。Finova基准测试可在以下网址获取:https URL。

用时:2.46s

自然语言理解

我们试着在一段连续文本中加入一些错别字,以及一些双关的网络流行梗,采用回译检验(中译英译中)的方法测试Qwen-MT能否成功识别正确的意思。

我是童脸狼,表面上单纯天真,实际上圆滑通透。你不可能算计得了我,因为从一开始你就被我布局了。我是棋手,而你只是棋子,若你伟逆我,你会道什么是残酷和黑暗。当我重临世界之日,诸逆臣皆当死去!

翻译结果:我是童莲琅,表面上天真单纯,实则精明敏锐。你们无法欺骗我,因为从一开始,我就已经为你设下了计划。我才是棋手,而你只是棋子;如果你与我为敌,你终将明白什么是真正的残酷与黑暗。当我重返这个世界之日,所有叛徒必将死无葬身之地!

平均用时:1.14s

歇斯底里是崩溃,底里歇斯是美味。

翻译结果:歇斯底里是崩溃,而歇斯底里是美妙的。

平均用时:0.60s

皇帝感叹道:“孤的胜,你们都看在眼里,孤的败。”然后就退朝了。

翻译结果:皇帝叹息道:“你们都曾见证过我的胜利,现在就看看我的失败吧。”说完便退朝了。

平均用时:0.72s

自定义指令

Qwen-MT同时支持术语干预、自定义指令、翻译记忆等功能,例如翻译场景中有较多的专有词汇,可以提前指定这些词汇及翻译结果,在程序内建立字典。

还可以通过一段自然语言文本描述领域和要求,作为翻译的提示。

我们输入同样的文本,要求Qwen-MT分别用严谨正式的直译风格和抒情美感的诗歌风格进行翻译,对比输出结果。

A quiet threat to London’s position as a bustling world financial center is starting to show on the sweaty white collars of the city’s commuters.

严肃正式:伦敦作为全球金融中心的繁荣地位正面临一个潜在的威胁,这种威胁开始在城市通勤者的汗湿白领中显现出来。

抒情美感:伦敦作为全球金融中心的繁华地位,正悄然受到威胁,这种威胁已开始在城市通勤者们汗湿的白领领带上显现。

用时:0.88s(严肃)/0.71s(抒情)

Some of us get dipped in flat, some in satin, some in gloss. But every once in while you find someone who’s iridescent, and when you do, nothing will ever compare. 严肃正式:我们有些人被浸在平滑中,有些人被浸在缎面中,有些人被浸在光泽中。但偶尔你也会遇到一些人,他们闪耀着彩虹般的光芒,一旦遇见了这样的人,其他一切都将无法与之相比。

抒情美感:有人被岁月打磨得平滑如缎,有人则闪耀着光泽。但偶尔,你总会遇到那么一个光彩夺目的人,一旦遇见,便再也无法用其他事物来比拟。

用时:0.87s(严肃)/0.85s(抒情)

总体感受

速度很快,200字文本仅需2.5s,多数情况下输出控制在1s以内。

回流检验的结果和原文大致能够保持一致,可以修正少量的错别字,能够理解文言文和俗语,但无法理解过于抽象的自然语言(如谐音梗笑话)。

能够自动识别不同语言。

可以通过领域提示对输出结果的语言风格进行调整,但需要明确关键词,领域提示语句暂时只支持英文。

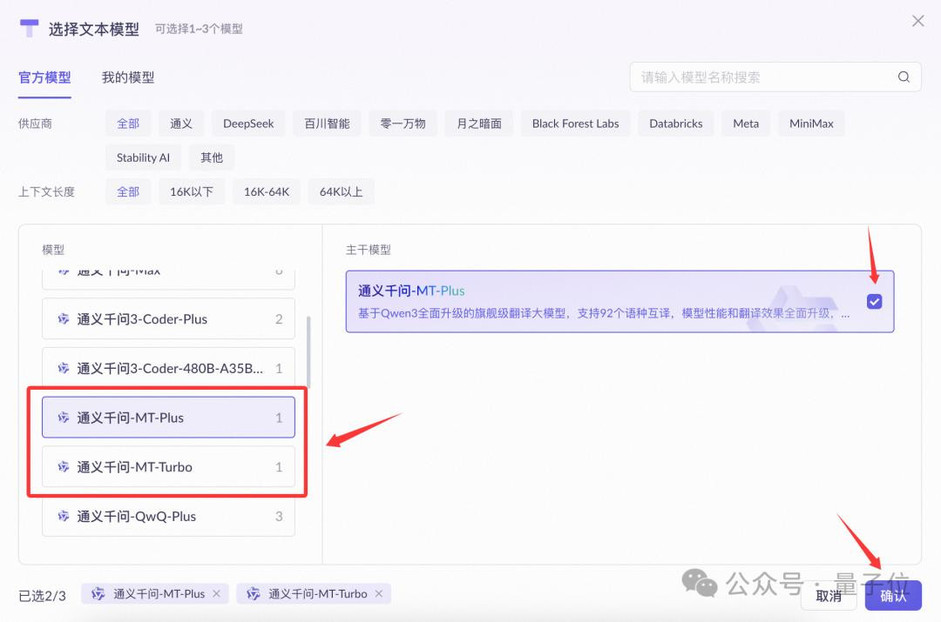

使用方法

在阿里云百炼的模型广场可以选择试用Qwen-MT-Pro和Qwen-MT-Turbo。

选择后即可试用,一次性可输入的最长文本量为6000。

输入内容后进入对话界面,右侧可选择额外功能(术语干预、翻译记忆、领域提示),每次输出会显示使用的token数。

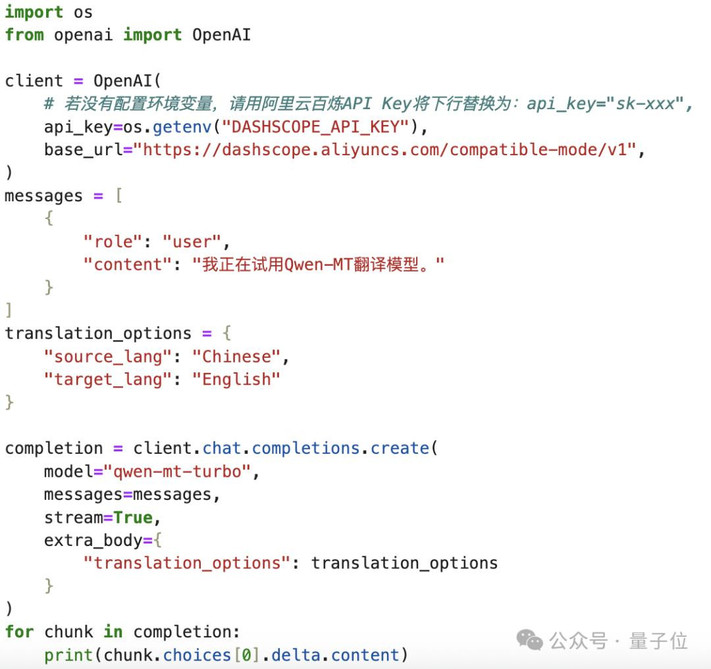

也可以调用Qwen API,详细代码可见官方操作文档。

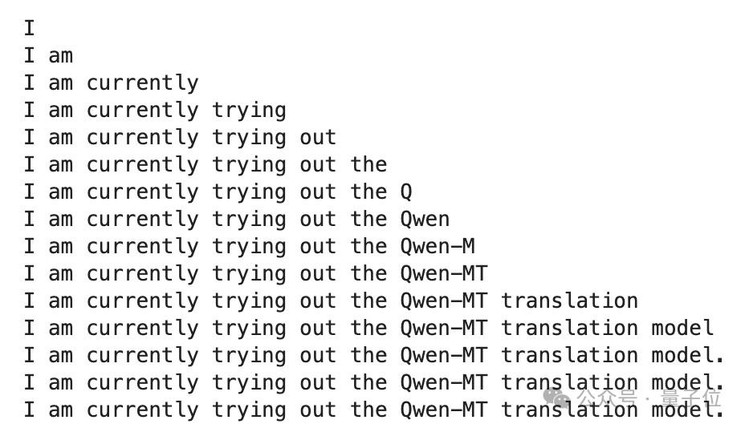

结果支持流式输出。

参考链接:https://mp.weixin.qq.com/s/2LQIrsaBgXcxw76BYshfdw

官方文档:https://help.aliyun.com/zh/model-studio/machine-translation

API地址:https://bailian.console.aliyun.com/?tab=model#/model-market/detail/qwen-mt-turbo

— 完 —

量子位 QbitAI

关注我们,第一时间获知前沿科技动态