智能体不是AI的“新功能”,而是AI的“新物种”。它重构了任务执行、系统协同与产品形态,背后是一整套认知范式的跃迁。本文深度解析智能体的冰山结构,揭示你没看到的系统性力量。

现在,越来越多的公司开始探索“智能体(Agent)”的应用:它可以对话交流、生成内容、调用工具,甚至完成订票、查报告、分析财务等具体任务。

看起来,似乎只要接入一个大语言模型(LLM),再连上几个接口,就能快速搭建出一个“智能体”。但当真正部署上线后才会发现:事情远比想象中复杂。

这些看似“能说话”的智能体,之所以能够稳定响应、准确执行、安全可控,其背后依赖的并不是模型本身的能力,而是一整套系统架构与工程支撑。

如果我们把智能体的能力比作一座冰山,大语言模型只是水面上露出的冰尖,而更多决定它“能不能上线”、“用得稳不稳”的部分,其实都深藏在水面之下。

什么是一个完整的 AI 智能体系统?

一个真正可投入实际使用的智能体系统,往往不只是“模型 + 接口”的组合,它通常包含以下几个核心组成部分:

- 大脑:调用 LLM,比如 GPT、Claude、Gemini、DeepSeek 等;

- 工具箱:集成外部能力,如搜索引擎、数据库、RPA 接口;

- 对话控制器:识别用户意图、调度功能模块、保持上下文一致性;

- 接口支持:支持从网页、微信、App、电话等多种渠道接入;

- 安全风控模块:识别敏感信息、防止越权访问、保障合规;

- 运维监控体系:记录行为、监控出错、提供可观测性指标;

- 测试与发布系统:上线前回归测试,有问题能回滚;

- 数据记录与反馈机制:支持数据回流与迭代优化。

换句话说:

一个真正的 Agent,不只是一个“能回答问题的小工具”,而是运行在一套完整系统之上的智能角色,拥有感知、决策、行动、记忆与反馈的能力。

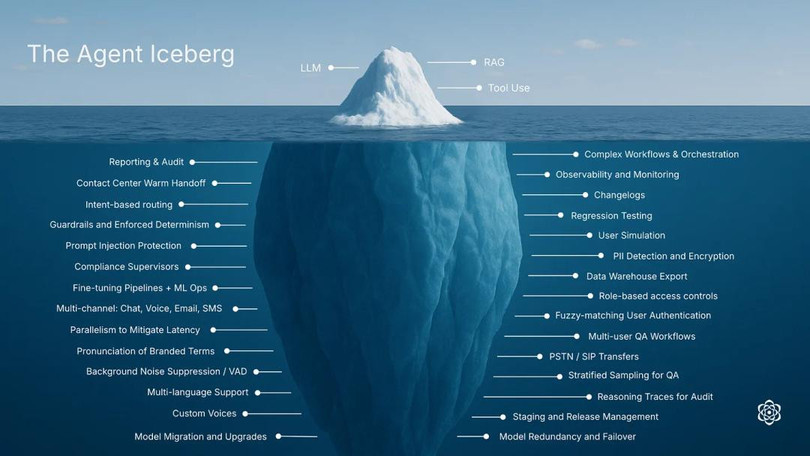

智能体冰山:只有 3 项能力在水面上,其余都藏在水面下

为了更清晰地理解智能体系统,我们可以借助一张结构图 ——The Agent Iceberg(智能体冰山):

这张图揭示了一个关键事实:

大语言模型是智能体的重要基础,但远远不是全部。智能体之所以能够真正运行、执行任务、融入业务流程,依赖的是一整套系统性的能力支撑。

在这张图中:

1)水面之上,我们能直接看到的能力只有 3 项:

- LLM(大语言模型)

- RAG(检索增强生成)

- ToolUse(工具调用)

这三项能力构成了智能体与用户交互的“显性部分”,它们决定了 Agent 的语言能力和基础执行力。

2)水面之下,则隐藏着智能体真正得以落地和扩展的核心支撑结构——共计 29 项系统模块。它们涵盖了权限管理、流程编排、日志监控、发布测试、安全风控、数据回流等关键能力,共同构成了智能体从 Demo 演示走向可靠产品、从会说话走向能交付的底层支撑系统。

接下来,我们将这 29 项“冰山之下”的能力划分为六大类,逐一拆解每一个你可能未曾意识到,却必须补齐的系统能力模块。

一、平台基础设施(6项)

目标:模型要“跑得起来”,系统得“撑得住”。

1、Model Migration and Upgrades(模型迁移与升级)

模型版本如何平滑切换?如何从 GPT-4 升级到 GPT-5 不崩?

2、Model Redundancy and Failover(模型冗余与故障转移)

系统故障时是否能自动切换备用服务?

3、Staging and Release Management(阶段发布与版本管理)

上线前是否有测试环境?上线能否灰度?

4、Fine-tuning Pipelines + ML Ops(微调流程 + 模型运维)

有一套完整的训练、部署、监控、更新机制吗?

5、Parallelism to Mitigate Latency(并行处理降低延迟)

上千用户同时用,会不会变慢、卡住?

6、Observability and Monitoring(系统监控与可观测性)

模型延迟高、错误多,有没有监控面板?

二、安全与合规体系(7项)

目标:智能体必须“可控”、“合规”,不能出事。

1、Prompt Injection Protection(提示注入保护)

防止用户通过“指令技巧”绕过限制或窃取信息。

2、Guardrails and Enforced Determinism(安全护栏与可控输出)

限制模型输出范围,避免自由发挥胡说八道。

3、Compliance Supervisors(合规监管机制)

满足医疗、金融等行业监管需求,有留痕、可查。

4、PII Detection and Encryption(敏感信息识别与加密)

检测用户输入/输出中是否含有隐私信息,并加密处理。

5、Role-based Access Controls(基于角色的权限控制)

不同用户或模块的权限边界是否清晰?

6、Reasoning Traces for Audit(推理路径追踪)

模型是怎么得出这个答案的?是否有可追溯过程?

7、Reporting & Audit(审计与报告生成)

可导出日志、数据记录、操作流程以供审查。

三、对话智能与多通道入口(8项)

目标:用户说什么,系统能听懂;无论在哪,都能接入。

1、Intent-based Routing(基于意图的路由)

用户说“我要请假”,系统知道该走人事流程,不是闲聊。

2、Contact Center Warm Handoff(客服转接与无缝交接)

模型答不了时,能否转接人工客服,并保留上下文?

3、Multi-channel: Chat, Voice, Email, SMS(多通道统一接入)

网页、电话、邮箱、短信能不能统一支持?

4、PSTN / SIP Transfers(电话网络转接)

支持传统电话线路与 SIP 呼叫系统的对接。

5、Pronunciation of Branded Terms(品牌名语音发音优化)

比如“蔚来汽车”,模型发音是否清楚、准确?

6、Background Noise Suppression / VAD(背景噪音消除 / 语音检测)

在嘈杂环境下也能识别语音内容。

6、Multi-language Support(多语言支持)

是否支持中英互译、多语言切换?

7、Custom Voices(自定义语音风格)

你希望它说话像谁?能不能换声音语气?

四、质量保障与版本控制(5项)

目标:系统更新不可怕,怕的是更新后变“傻”。

1、Regression Testing(回归测试)

更新后回答是否变差?性能是否下降?

2、User Simulation(用户行为模拟)

模拟真实用户提问行为进行测试。

3、Multi-user QA Workflows(多用户质检工作流)

多人协作检查模型输出,标注错误。

4、Stratified Sampling for QA(分层抽样质检)

不同场景、功能、用户层级各有覆盖。

5、Changelogs(变更日志)

所有更新记录是否可追踪、可还原?

五、数据与身份集成(2项)

目标:智能体能“听懂人话”,也能“对上业务”。

1、Data Warehouse Export(数据仓库对接导出)

对话数据是否能进入 BI 系统或用于二次训练?

2、Fuzzy-matching User Authentication(模糊匹配用户认证)

你叫“老王”、“Wang123”都能识别是你本人。

六、工作流与系统编排(1项)

目标:不只是聊天,还要能干活。

1、Complex Workflows & Orchestration(复杂工作流与任务编排)

例如“查订单→修改地址→重新下单→短信通知”,能否一步到位完成?

总结:Agent 能否落地,取决于系统是否撑得住

如今,越来越多的智能体实践还停留在“调好一个提示词、接上一个模型”的探索阶段。但当我们面对真实业务时,会发现智能体要真正跑起来,并不是一句回答的事,而是一套系统工程的事。

一个真正可落地、可服务的 Agent,不是“能说话”,而是“能执行”、“可控”、“可持续”。

它背后依赖的不只是大模型的能力,还包括权限控制、流程编排、日志监控、质量保障、工具调度、数据闭环等29 项系统能力,正是这些“冰山之下”的工程支撑,决定了 Agent 是否具备产品化、规模化、商业化的可能。

请记住:

- 能回答≠能上线

- 能对话≠能闭环

- Agent≠Prompt工程,而是系统工程

Agent 是一个“智能角色”,而系统是它能真正完成任务、支撑业务的舞台。当系统搭建完备,Agent 才不再只是一个“回答器”,而能成为真正“干活的人”。

如果你正站在 Agent 应用的起点,那么此刻,就是往冰山之下看一眼的好时候:把系统补齐,把细节打牢,未来才有可能跑得稳、用得久、放得开。

本文由 @AI思·享@蓉77 原创发布于人人都是产品经理。未经作者许可,禁止转载。

题图来自 Pixabay,基于CC0协议。

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。