衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

三天不开源,Qwen团队手就痒。

昨天深夜再次放出两个端侧模型:

- Qwen3-4B-Instruct-2507:非推理模型,大幅提升通用能力

- Qwen3-4B-Thinking-2507:高级推理模型,专为专家级任务设计

4B这个尺寸对端侧非常友好,甚至意味着可以在树莓派上运行它。

Qwen官方推文中对这俩模型的介绍是:

更智能、更精准,并且支持256k上下文,更具上下文感知能力。

在AIME25上,Qwen3-4B-Thinking-2507四两拨千斤,最后得分是81.3。

这个成绩已经超过了Gemini 2.5 Pro(49.8~88.0)和Claude 4 Opus(75.5)在AIME25的得分——仅仅靠一个4B的模型!

而且,4B参数量意味着对端侧极其友好。

也难怪网友在Ycombinator上惊呼:

感谢中国公司!

4B模型大升级,四两拨千斤

官方推文上,是这么介绍两位Qwen3家族新成员的:

- Qwen3-4B-Instruct-2507:提升通用能力、多语言覆盖和长上下文指令理解。

- Qwen3-4B-Thinking-2507:逻辑、数学、科学及代码中的高级推理能力——专为专家级任务设计。

Qwen团队直言不讳,称这两个模型“更加强大”。

浅浅回顾一下,今年4月底,Qwen3系列首登场时,Qwen-4B-Base作为第一批八个成员之一亮相。

当时,Qwen3-4B就能在数学、代码能力上“以小博大”,和比自身大10倍模型水平相当。

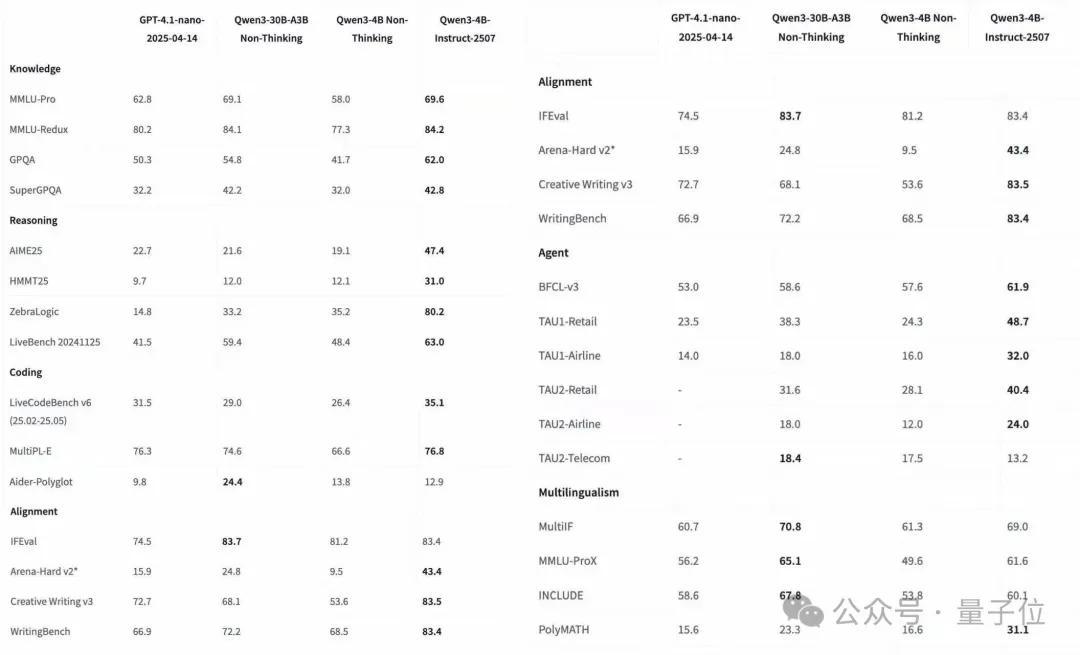

现在同样在多个测试集上可以看到,Qwen3-4B-Instruct-2507和Qwen3-4B-Thinking-2507对于前作都有非常明显的能力提升。

Qwen3-4B-Instruct-2507

Qwen3-4B-Instruct-2507是一个非推理模型,具有以下关键改进:

- 在通用能力方面有显著提升,包括指令遵循、逻辑推理、文本理解、数学、科学、编程和工具使用。

- 在多语言长尾知识覆盖方面有大幅增长。

- 在主观和开放性任务中与用户偏好显著匹配,能够提供更有帮助的响应和更高质量的文本生成。

- 256K长上下文理解能力增强,可扩展至1M。

在诸多测试集上,该模型通用能力超越了闭源的小尺寸模型GPT-4.1-nano。

(注:GPT-4.1-nano是GPT-4.1系列中最小规模的模型,未公开参数量)

和Qwen3-30B-A3B(Non-Thinking)对比,Qwen3-4B-Instruct-2507与其性能接近,还小胜一筹。

换句话说,这个4B的密集模型在性能上与30B的MoE模型能力非常接近,但“占地面积”却小了7.5倍。

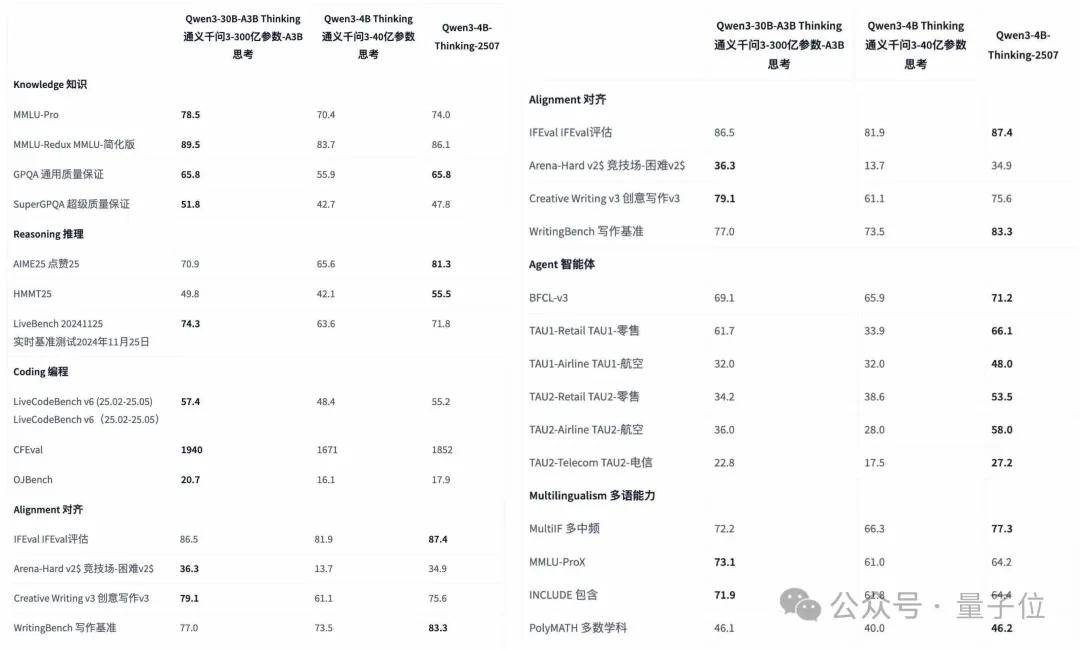

Qwen3-4B-Thinking-2507

在抱抱脸上,Qwen团队写道:

在过去三个月中,我们持续提升Qwen3-4B的思考能力,增强了推理的质量和深度。

于是,Qwen3-4B-Thinking-2507诞生了,这是一个仅支持推理模式的模型。

在前作基础上,这一模型主要有以下改进:

- 在推理任务上性能显著提升,包括逻辑推理、数学、科学、编程以及通常需要人类专业知识的学术基准测试。

- 通用能力显著提升,包括指令理解、工具使用、文本生成以及与人类偏好的对齐。

- 增强的256K长上下文理解能力。

官方在抱抱脸表示,由于Qwen3-4B-Thinking-2507增加了思考长度,“强烈建议在高度复杂的推理任务中使用它”。

在重点考察数学能力的AIME25测评中,Qwen3-4B-Thinking-2507以4B参数量斩获81.3的好成绩。

此外,在GPQA上,其得分与Qwen-30B-A3B(Thinking)得分相当;Agent方面的每一项测试,Qwen3-4B-Thinking-2507碾压了前代版本以及Qwen-30B-A3B(Thinking)。

端侧开发者福音

现在,Qwen3-4B-Instruct-2507以及Qwen3-4B-Thinking-2507的代码可在抱抱脸和魔搭社区找到,文末放上了直通车,方便大家寻找。

官方还贴心地给出了部署建议:

第一,对于本地使用,Ollama、LMStudio、MLX-LM、llama.cpp和KTransformers等应用程序也已支持模型部署。

对于极小型设备(如树莓派4B),可使用量化版本Qwen3-4B-GGUF,搭配llama.cpp运行。

第二,如果遇到内存不足(OOM)问题,可以考虑将上下文长度减少到一个更短的值。

由于Qwen3-4B-Thinking-2507是一个推理模型,在推理时可能需要更长的词元序列,强烈建议在可能的情况下使用大于131,072的上下文长度。

第三,虽然俩模型一个是推理模型一个是非推理模型,但官方对prompt给出了同样的建议。

面对数学问题时,推荐在prompt中包含“请逐步推理,并将最终答案放在\boxed{}内。”

面对选择题时,推荐在prompt中添加以下JSON 结构以标准化回答:”请在 answer 字段中仅显示选项字母,例如 “answer”: “C” 。”

最后,已经有网友在呼吁开源永动机Qwen团队赶紧交出Qwen3-8B系列了:

One More Thing

Qwen3系列到底有多少款模型?

答案是:不知道。

吃瓜群众们只知道这次小·大模型的更新非常使用,以及时间钱选得刚刚好——

昨天,久不Open的OpenAI终于开源了一次。

不仅和谷歌、Anthropic大撞期,而且gpt-oss-120b和gpt-oss-20b两个模型似乎并没有用性能征服开发者们。

而今天半夜,也就是8月8日凌晨1点(太平洋时间8月7日上午10点),打了800集预告的GPT-5,或许就要来了……

8月刚开始就战况这么激烈,咱能怎么办?

搬小板凳,乖巧坐等呗~

抱抱脸直通车:

[1]https://huggingface.co/Qwen/Qwen3-4B-Instruct-2507

[2]https://huggingface.co/Qwen/Qwen3-4B-Thinking-2507

魔搭社区直通车:

[1]https://modelscope.cn/models/Qwen/Qwen3-4B-Instruct-2507

[2]https://modelscope.cn/models/Qwen/Qwen3-4B-Thinking-2507

参考链接:

[1]https://x.com/Alibaba_Qwen/status/1953128028047102241

[2]https://www.reddit.com/r/LocalLLaMA/comments/1mj8ndr/qwen_3_4b_thinking_model_released/

[3]https://news.ycombinator.com/item?id=44813627

— 完 —

量子位 QbitAI · 头条号

关注我们,第一时间获知前沿科技动态