只需一张照片、一段音频和文字描述,普通人也能制作出好莱坞级别的说话视频!

这就是清华大学和字节跳动智能创作实验室共同提出的多模态视频生成框架:HuMo,专注于人类中心的视频生成。

技术创新

HuMo通过以下创新方法解决多模态协同难题:

高质量训练数据

团队构建了涵盖文本、图像和音频的配对数据集,包含常见风格(如漫画)与小众风格(如赛博朋克),有效提升模型泛化能力。

分阶段训练策略

阶段一:主体一致性优化 采用高效图像注入技术,在保证生成速度的同时显著提升角色外观保持效果,主体保持任务性能超越已有最佳模型23%。

阶段二:音视频同步增强 通过智能聚焦策略自动关联音频与面部区域,结合动态权重调节技术,在去噪过程中自适应平衡多模态输入,确保同步质量。

功能特点

文本-图像驱动视频生成:结合文本提示和参考图像,定制角色的外貌、服装、妆容、道具和场景,生成个性化视频。

文本-音频驱动视频生成:仅用文本和音频输入生成与音频同步的视频,无需图像参考,提供更大创作自由度。

文本-图像-音频驱动视频生成:融合文本、图像和音频指导,实现最高级别定制和控制,生成高质量视频

多模态协同处理:支持强文本提示跟随、主体一致性保留以及音频驱动的动作同步,实现多种模态输入的协同驱动。

高分辨率视频生成:兼容480P和720P分辨率,720P生成质量更高,满足不同场景需求。

性能表现

对比在文字和参考图像输入下,对主体保留的效果,涵盖人物、场景等不同类型内容;从视频质量、文本遵循度、主体一致性等维度,HuMo在多个指标上表现出色。

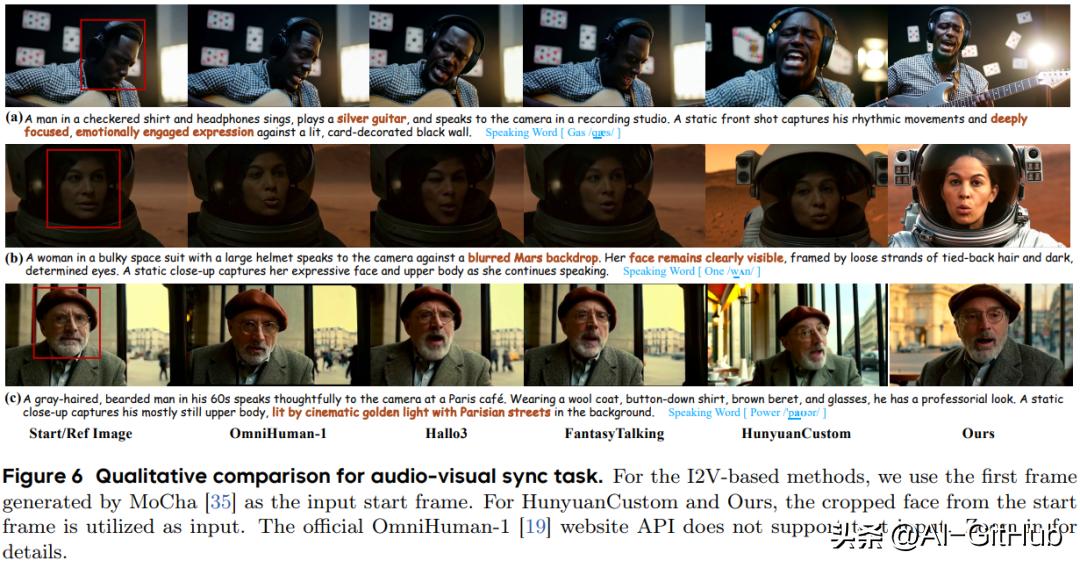

通过不同方法生成的视频示例,对比在音频与视觉同步方面的效果,场景包括录音室、火星背景、巴黎咖啡馆等,展示了不同方法在捕捉人物表情、动作与音频同步性上的差异,HuMo在画面呈现和同步效果上有较好表现。

对比不同变体在保留人物身份、场景元素等方面的效果,HuMo在人物形象和场景还原上表现更好。

从原始视频中提取字幕和音频,使用 HuMo 以两种模式生成新视频:文本 - 音频(TA)和文本 - 图像 - 音频(TIA),TIA 模式的参考身份图像显示在左上角,对比不同模式下角色形象等的呈现效果。

HuMo项目已在完全开源,提供完整论文、演示、代码和模型下载,点击下方链接即可查看。

GitHub:https://github.com/Phantom-video/HuMo

项目官网:

https://phantom-video.github.io/HuMo/