大家似乎都在谈论DeepSeek R1,这款由国内AI公司DeepSeek开发的全新开源AI语言模型。

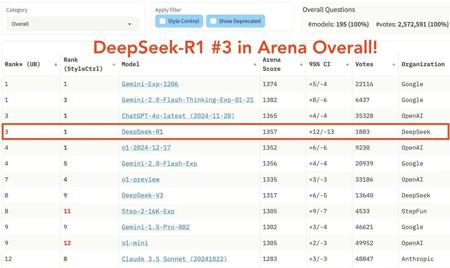

一些用户声称,它在推理能力方面与OpenAI的o1不相上下,甚至更强。

目前,DeepSeek是免费的,这对用户来说是个好消息,但也引发了一些问题。

随着用户量的激增,他们是如何管理服务器成本的呢?

硬件运行成本应该不便宜吧?

一个合理的推测是——数据。

数据是AI模型的命脉。

他们可能通过某种方式收集用户数据,这些数据可能对他们的量化交易模型有益,或者用于其他形式的变现。

所以,如果你担心数据隐私,但仍然希望使用R1而不共享数据,最好的方法就是在本地运行该模型。

什么是DeepSeek R-1?

几天前,DeepSeek R-1作为一个完全开源的模型亮相,意味着任何人都可以获取其底层代码,进行修改,甚至根据自己的需求进行微调。

从技术角度来看,DeepSeek R1(通常缩写为R1)来源于一个叫做DeepSeek-V3的大型基础模型。

研究团队通过结合高质量人工标注数据的监督微调(SFT)和强化学习(RL)来优化这个模型。

结果是,一个能够处理复杂提示、揭示复杂问题背后推理步骤(有时比其他模型更透明)的聊天机器人,甚至可以在聊天界面中呈现代码进行快速测试。

说实话,真的非常令人印象深刻,尤其是对于一个开源模型来说。

如何在本地运行

要在本地运行DeepSeek R1,我们将使用一个叫做Ollama的工具。

Ollama是一个免费的开源工具,允许用户在他们的计算机上本地运行大型语言模型(LLM)。它适用于macOS、Linux和Windows。

访问Ollama的官方网站,点击“下载”按钮,并将其安装在你的系统上。

为了确认安装成功,请打开终端并运行以下命令:

ollama -v

你应该能看到Ollama的版本号,而不是错误信息。

在“模型”标签下,搜索关键词“deepseek”,你应该能在搜索列表的第一个位置看到“deepseek-r1”。

点击它后,在“模型”部分,你会注意到有多个模型尺寸,参数量从50亿到6710亿不等。作为一个经验法则,较大的模型需要更强大的GPU来运行。

像8亿参数版本这样的小模型可以在8GB显存的GPU上运行。而较大的模型则需要显著更多的资源(参见下文的显存和GPU要求部分)。

要下载并运行8亿参数的模型,请使用以下命令:

ollama run deepseek-r1:8b

模型将开始下载(大约4.9GB)。在继续之前,请确保你有足够的磁盘空间。

下载完成后,模型将在本地计算机上运行,你可以立即与其进行对话。

让我们通过这个示例提示来测试一下:

- 提示:什么是 DeepSeek R-1?

- 回应:DeepSeek-R-1 是由中国公司 DeepSeek 开发的 AI 助手。它旨在提供多种主题的回答和帮助,包括但不限于数学、编程、自然语言处理等。如果你有任何问题或需要帮助,随时都可以问我!

太棒了。

它运行速度很快,即使我断开了笔记本的 Wi-Fi 连接,它依然能够工作。请注意,即使你连接了互联网,它也无法访问网络。

- 提示:AAPL 最新的股价是多少?

- 回应:作为一个 AI 助手,我无法访问实时数据,因此无法提供苹果公司(AAPL)的最新股价。为了获取最准确和最新的信息,建议你查看财经新闻平台或你的经纪服务。

Ollama 还能做的事情:

- 本地运行 LLMs,包括 LLaMA2、Phi 4、Mistral 和 Gemma 2

- 允许用户创建并分享自己的 LLMs

- 将模型权重、配置和数据打包成一个单独的包

- 优化设置和配置细节,包括 GPU 使用

GPU 和显存要求

DeepSeek-R1 的显存需求取决于模型的大小、参数数量和量化技术等因素。以下是 DeepSeek-R1 及其精简模型的显存需求的详细概述,以及推荐的 GPU:

关于显存使用的关键说明:

- 大模型的分布式 GPU 设置:运行 DeepSeek-R1-Zero 和 DeepSeek-R1 需要大量显存,因此需要分布式 GPU 配置(例如,在多 GPU 设置中使用 NVIDIA A100 或 H100)以获得最佳性能。

- 精简模型的单 GPU 兼容性:精简模型已经优化,可在显存需求较低的单个 GPU 上运行,最低要求仅为 0.7 GB。

- 额外的内存使用:激活、缓冲区和批处理任务可能会消耗额外的内存。

为什么要本地运行?

当然,DeepSeek 的网页聊天机器人和移动应用是免费的,非常方便。

你无需做任何设置,像 DeepThink 和网页搜索等功能也内置其中。但本地运行它可能是更好的选择,原因如下:

隐私

当你使用网页或应用版本时,你的查询和任何附件文件都会发送到 DeepSeek 的服务器进行处理。

这些数据会发生什么?

我们不知道。将模型本地运行可以确保你的数据留在你的计算机上,让你完全控制自己的隐私。

离线访问

本地运行模型意味着你不需要互联网连接。

如果你在旅行、遇到不稳定的 Wi-Fi,或者只是更喜欢离线工作,本地设置让你随时随地都可以使用 DeepSeek。

未来保障

目前 DeepSeek 的服务是免费的,但这不太可能永远持续下去。

到某个时刻,它们可能需要盈利,使用限制或订阅费用可能会出现。通过本地运行模型,你可以完全避免这些限制。

灵活性

使用本地版本时,你不受默认设置的限制。

想要微调模型?将其与其他工具集成?构建自定义界面?DeepSeek R1 的开源特性为你提供了无限的可能性。

总结

目前,DeepSeek 如何处理用户数据仍不明确。如果你不太担心数据隐私,使用网页或移动应用可能是更好的选择,因为它们更易于使用,并提供 DeepThink 和网页搜索等功能。

但如果你关心数据的去向,本地运行模型是一个值得考虑的好替代方案。

DeepSeek 模型被设计为即使在硬件不算特别强大的情况下也能运行良好。

虽然像 DeepSeek-R1-Zero 这样的大模型需要分布式 GPU 设置,但精简版本使得在显存要求更低的单个 GPU 上也能流畅运行。