编辑:定慧 好困

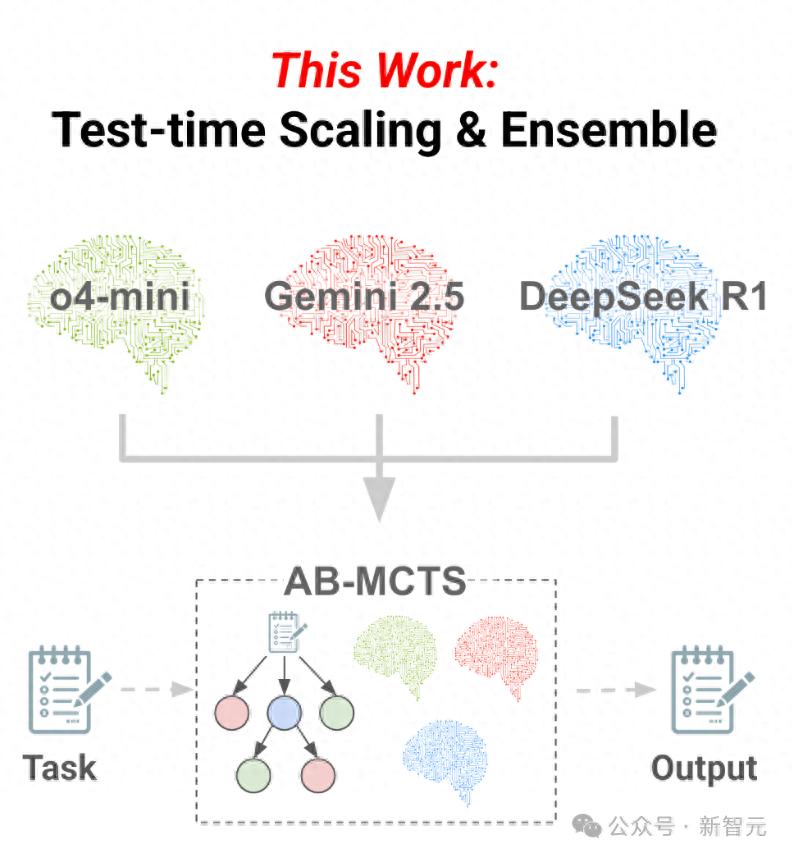

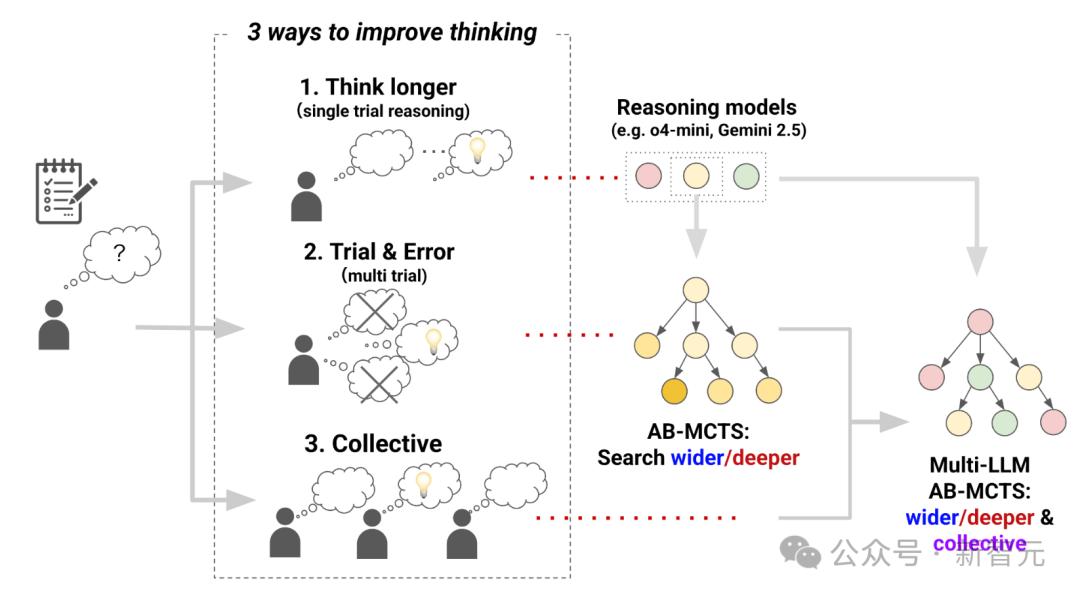

【新智元导读】三个前沿AI能融合成AGI吗?Sakana AI提出Multi-LLM AB-MCTS方法,整合o4-mini、Gemini-2.5-Pro与DeepSeek-R1-0528模型,在推理过程中动态协作,通过试错优化生成过程,有效融合群体AI智慧。

三个臭皮匠顶个诸葛亮、双拳难敌四手。。。

这些对于人类再自然不过的群体智慧思维,似乎从来没有发生在AI身上。

我们总是期望某个AI能够足够智能,科技巨头们之间的比拼也是通过单模型的不断更新来标榜先进性。

比如o4-mini、Gemini-2.5-Pro、DeepSeek-R1-0528这些具有代表性的模型,到底哪个写的代码更好?

但如果,将多个AI模型的能力「融会贯通」,能否也达到三个臭AI顶个AGI的效果?

最近,一项来自于Sakana AI的研究,在推理过程中——而不是在构建——试图将三种模型的能力整合起来。

结果令人惊讶,整合后的模型能力都远超单个模型,三模合一的性能也好于只有两个模型合体的性能。

Sakana AI使用一种新的推理时Scaling算法,自适应分支蒙特卡洛树搜索AB-MCTS(Adaptive Branching Monte Carlo Tree Search)。

该算法使AI能够高效地执行试错操作,并让多个前沿AI模型协同合作。

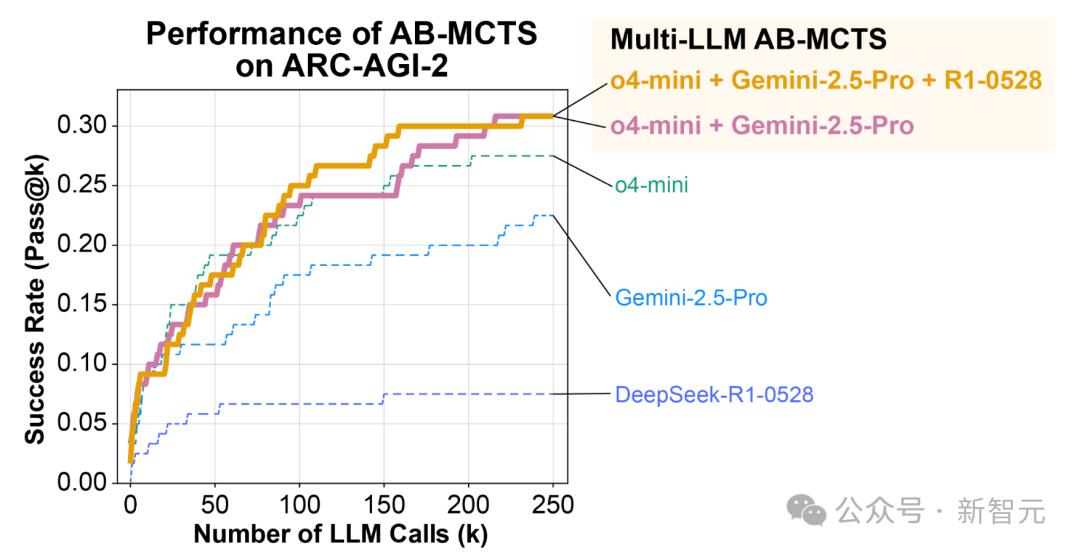

使用AB-MCTS将o4-mini、Gemini-2.5-Pro和R1-0528这三种当前最先进的AI模型组合起来,在ARC-AGI-2基准测试中取得了令人惊讶的成绩。

多模型的得分远超单独的o4-mini、Gemini-2.5-Pro和DeepSeek-R1-0528模型。

论文地址:https://arxiv.org/abs/2503.04412

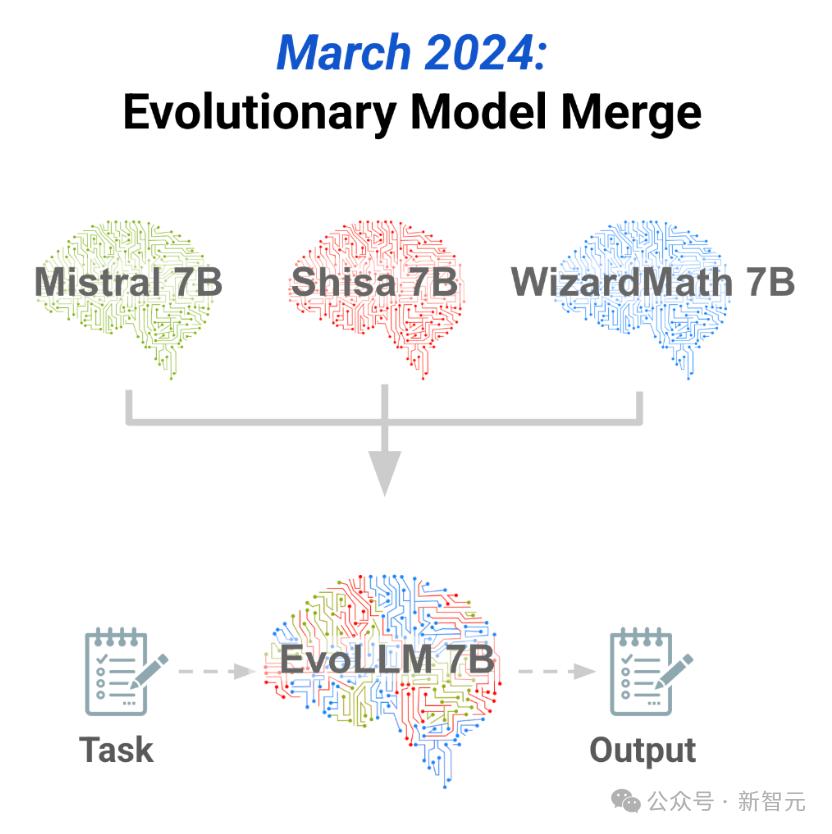

这种想法,曾经在在2024年关于进化模型融合的研究中得到过初期验证,通过进化计算和模型融合,利用现有开源模型挖掘到了多模型所蕴含的巨大群体智慧。

但AB-MCTS更进一步,不仅在构建新模型时,而且在推理过程中也使用多个模型。

利用不断进步的前沿模型(例如ChatGPT、Gemini和DeepSeek),生成一种新的群体智能的形式。

推理时Scaling

当你面对一个无法一眼看透的难题时,会怎么做?

很可能,你会花更长时间独立思考,亲身实践、反复试错,或是与他人协作。

那么,我们是不是也能让AI用同样的方式去解决难题呢?

- 第一种方法和人类使用的「更长时间思考」策略如出一辙——通过RL生成更长的思维链,来显著提升推理模型的能力。比如OpenAI的o1/o3和DeepSeek的R1。

- 第二种方法,是让模型反复审视问题、不断优化答案,甚至在必要时推倒重来。

- 第三种则是让LLM之间进行头脑风暴,类似于一种「群体智慧」。

这次团队提出的AB-MCTS,正是通过推理时Scaling技术,让AI不仅能高效地执行试错,还能让多个不同的AI进行集体思考。

驾驭搜索的两个维度:深度与广度

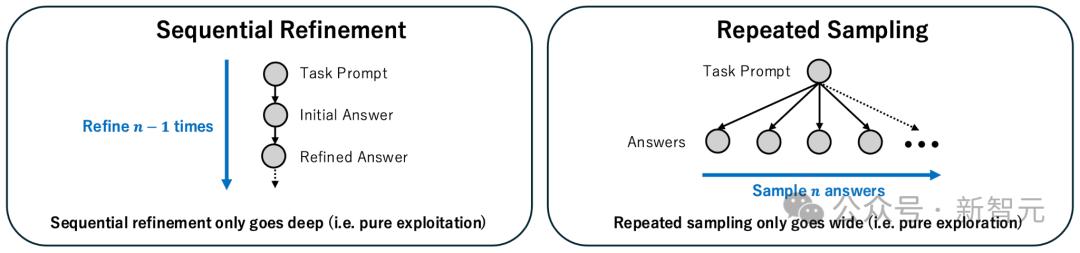

目前,有两种常见的方法可以让LLM进行试错:

- 第一种,是名为「序列优化」的深度优先搜索。它利用LLM生成答案,然后对其进行反复优化。

- 第二种,是「重复采样」,即让LLM根据同一个提示词多次生成解决方案。这种广度优先搜索,会重复地查询LLM,但不会参考先前尝试的结果。而LLM的随机性,则会对同一问题会产生不同的答案。

实践证明,无论是深入搜索(优化现有解决方案)还是扩展搜索(生成新解决方案),都能有效帮助LLM找到更优的答案。

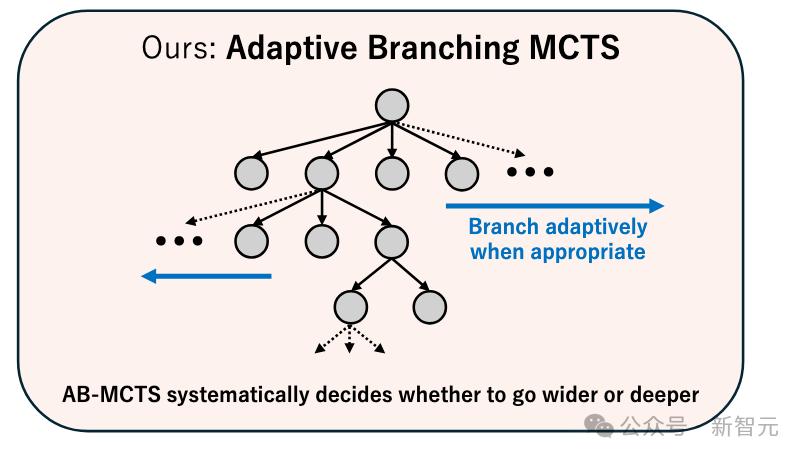

为了将这两者有效地结合起来,团队提出了一种用于推理时Scaling的、更高效的全新方法——AB-MCTS。

它能根据具体问题和上下文,在深度和广度两个方向上进行灵活搜索。

为了实现这种灵活搜索,AB-MCTS扩展了在AlphaGo等系统中得到成功应用的蒙特卡洛树搜索 (MCTS),并采用汤普森采样来决定探索方向。

具体而言,在每个节点(代表初始提示词或一个已生成的解决方案),AB-MCTS会利用概率模型来评估两种可能行动的潜在价值:

- 生成一个全新的解决方案

- 或者优化一个现有的方案

随后,从这些模型中进行采样,根据估算出的价值来决定下一步的探索方向。

为了评估尚未生成的新方案的质量,AB-MCTS会通过混合模型和概率分布来对评估过程进行建模,从而实现真正灵活的搜索。

第三个维度:AI

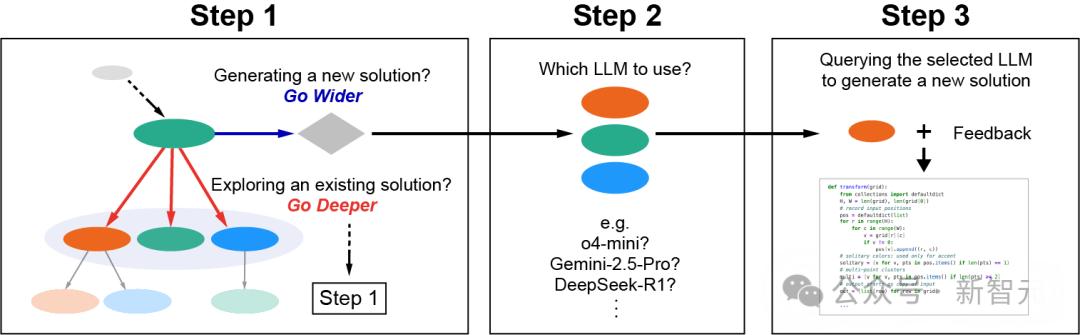

为了最大化LLM作为集体智能的潜力,一个名为Multi-LLM AB-MCTS的系统应运而生。

它不仅能自适应地探索搜索方向,还能根据给定的问题和情境,选择使用哪个LLM。

具体来说,Multi-LLM AB-MCTS的运作方式如下:

- 步骤1:算法将决定是(1)选择一个现有节点(深入搜索),并在下一层级重复步骤1;还是(2)从当前节点生成一个新的解决方案(扩展搜索),并进入步骤2。

- 步骤2:选择一个LLM。

- 步骤3:被选中的LLM会基于父节点生成一个更优的解决方案,并对结果进行评估。这个新生成的解决方案将作为一个新节点添加到搜索树中。

至于如何选择模型,团队的方法是——

- 首先,为每种模型分配了一个独立的概率模型,并采用类似AB-MCTS的方式使用汤普森采样;

- 然后,这些概率模型就会根据每个LLM在搜索过程中的表现进行更新;

- 最终,让表现更优的LLM被选中的可能性越来越高。

实验结果

ARC-AGI旨在评估一种类人、灵活的智能,这种智能可以高效地进行推理并解决新问题,而不像传统指标那样测试特定技能或知识。

实验采用的是更具挑战性的ARC-AGI-2。

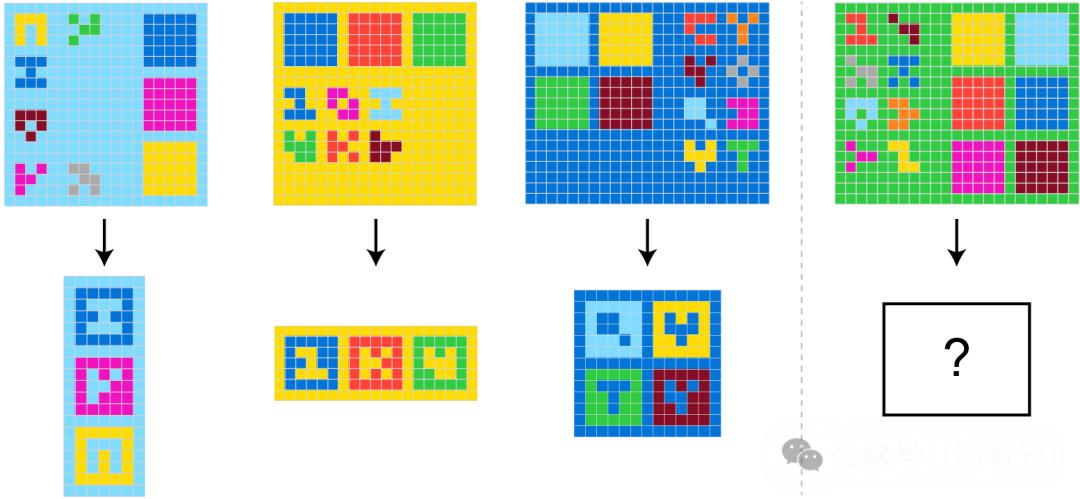

来自ARC-AGI-2的一个示例问题:任务是从左侧的三个演示案例中推断出共同的转换规则,并将其应用到右侧的测试案例中

为了主要评估搜索算法的最大潜在性能,使用了Pass@k指标,该指标用于衡量在k次尝试内是否至少找到了一个正确的解决方案。

这与ARC-AGI-2比赛的官方标准不同,后者通常采用Pass@2标准(提交两个最终答案,其中一个是正确的)。

Pass@2方法需要从搜索结果中选择有希望的候选方案的额外步骤。

实验是在ARC-AGI-2的公共评估集中的120个任务上进行的。

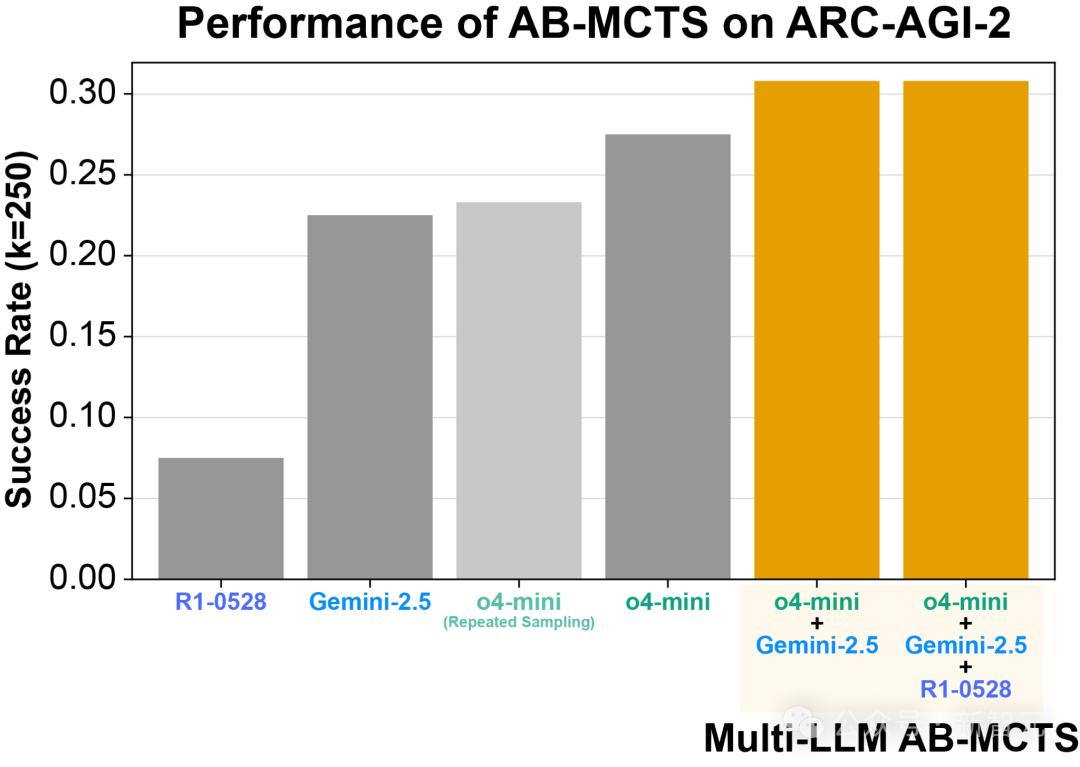

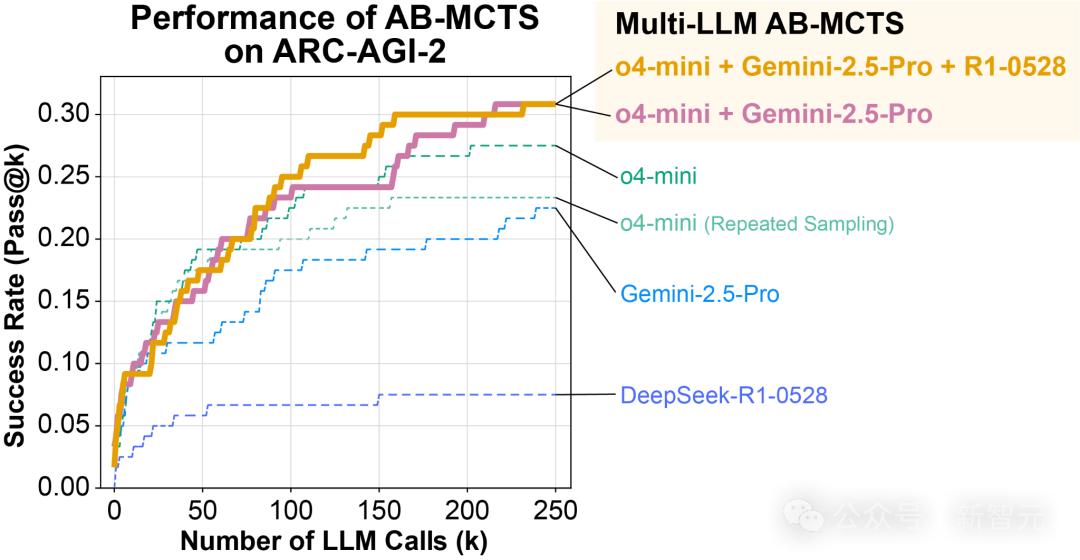

结合Gemini-2.5-Pro与DeepSeek-R1-0528的Multi-LLMAB-MCTS在Pass@250上表现出更高的得分。

重复采样一直被认为是ARC-AGI中一种非常有效的方法。

事实上,在实验中,使用o4-mini进行重复采样成功解决了23%的问题(即生成了能够正确转换测试用例的Python代码)。

这一结果远超单次尝试的得分,展示了重复采样的强大能力。

AB-MCTS进一步将得分提高至27.5%。这两种方法之间的差异在约50次LLM调用后变得更加明显。

通过将前沿模型作为具有多LLMAB-MCTS的集体智能加以利用,最终能够为超过30%的问题找到正确的解决方案。

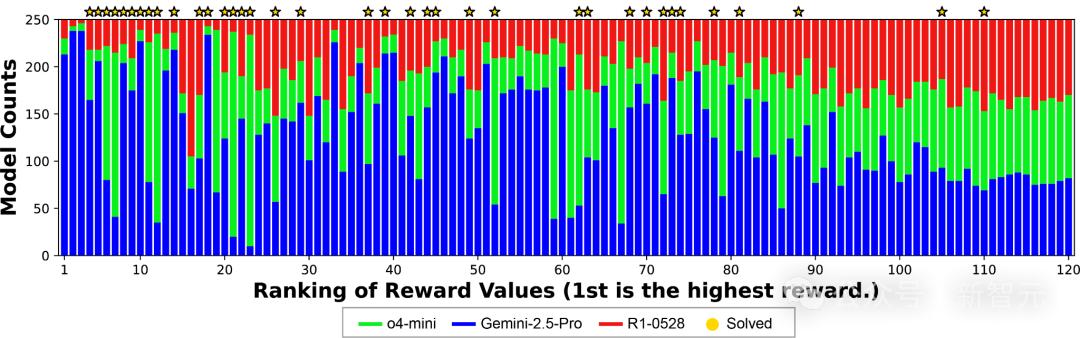

在Multi-LLMAB-MCTS中发现的一个关键特征是它能够根据各个LLM在特定问题上的专长动态地分配它们。

下图清楚地展示了这一行为:对于在演示示例中成功率较高的情况(图的左侧),观察到对某个特定LLM的明显偏好。

这种偏向发生的原因是在搜索过程中,算法识别出哪个LLM对于给定的问题最有效,并随后增加该模型的使用频率。

还有一些有趣的例子,其中单个LLM无法解决的问题在组合使用多个LLM后得以解决。

这超出了为每个问题分配最佳LLM的简单做法。

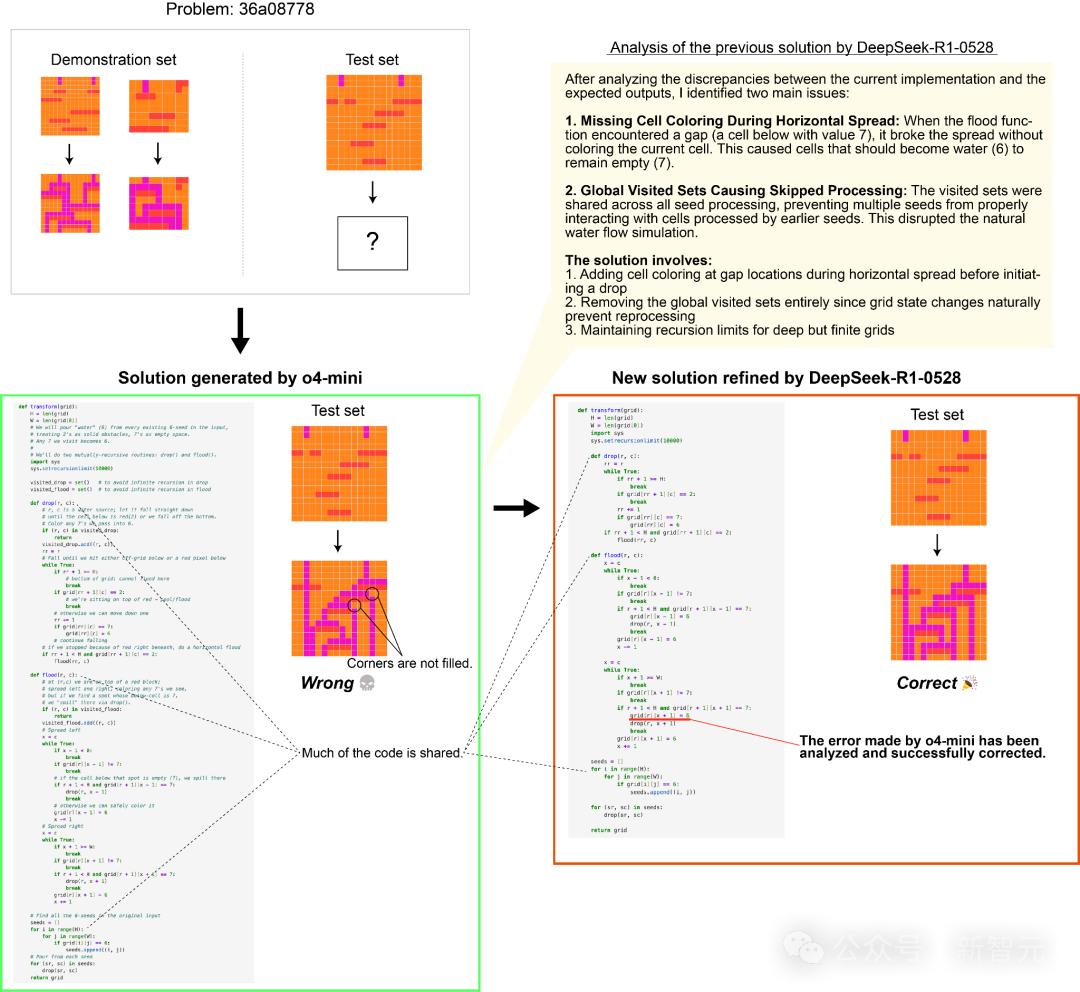

在下面的例子中,尽管o4-mini最初生成的解答是错误的,但DeepSeek-R1-0528和Gemini-2.5-Pro能够在下一步将其作为提示来得出正确的解答。

这表明Multi-LLMAB-MCTS可以灵活地结合前沿模型,解决原本无法解决的问题,从而推动将LLMs用作集体智能所能实现的边界。

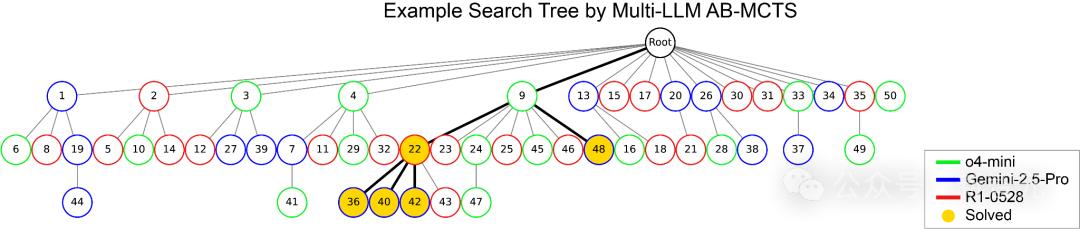

使用Multi-LLMAB-MCTS解决ARC-AGI-2时的搜索树示例。

节点中的数字表示生成顺序,颜色代表所选的LLM。

黄色节点表示生成了正确转换测试用例的代码的节点。

这是一个单一LLM均无法找到解决方案,但通过多个LLM的组合成功解决问题的示例。

多LLMAB-MCTS使得不同LLM之间能够协作。

上图展示了一个例子,其中DeepSeek-R1-0528在o4-mini(来自上图问题中生成的错误解答)的基础上改进,最终得出了正确答案。

Multi-LLMAB-MCTS旨在通过推理时Scaling多个前沿模型的合作来提升性能。在结合多个LLM方面,也提出了诸如多智能体辩论(Multiagent Debate)、智能体混合(Mixture-of-Agents)和LE-MCTS等其他方法。

自2024年中以来,「推理」模型逐渐受到重视,这些模型通过强化学习优化推理过程,开启了继模型扩展之后的新范式——推理时Scaling时代。

通过反复执行这些模型的推理过程,并结合多个具有独特个性的LLMs,可以进一步提升推理性能。

尽管人类大脑本身已堪称自然奇迹,但真正撼动时代的伟业,从不属于孤胆英雄。

无论是将人类送上月球的阿波罗计划,构建全球信息命脉的互联网,还是破译生命密码的人类基因组计划,这些里程碑式的成就,皆源于无数头脑之间的协作与共鸣。

正是多样知识的交汇、思想的碰撞,才让我们一次次突破人类智慧的边界——这种智慧同样适用于AI。

逸风

这组合太给力!AI领域迎来新突破,厉害了!

且行

这简直是人类的自大,但不得不承认,它很厉害!

亦然

我喜欢这种感觉,感觉世界都变了样了!

亦然

这组合简直是智商税,但不得不承认,有点惊艳!

逸风

我觉得这只是一个开始,未来会更加疯狂!

逸风

这绝对是科技进步的巅峰,太酷了!

沐心

我有点害怕,但不得不承认,这确实很厉害!

沐心

厉害了,我的主公!这速度也太快了吧!

亦然

我感觉这简直是人类的终结预兆啊!

亦然

太搞笑了,AI终于要统治世界了!