「我成功在国行 iPhone 上跑通了 AI 模型!」

「然后呢?」

「然后就没怎么用过了。」

iPhone 17 Pro Max 发布都一个月了,苹果国行 Apple Intelligence 还是遥遥无期。

等不及的网友们,决定自己动手,丰衣足食。

于是,在 iPhone 上部署端侧 AI 模型,成了互联网的新显学。

从保姆级教程到实操演示,各种野生秘籍在社交媒体上遍地开花。

我们也折腾了一番——下载模型、跑分测试、实际体验……整个过程确实有趣,甚至有点上头。但当兴奋劲过去,一个扎心的事实浮现出来:这玩意儿好玩、有趣,但不实用。

能用和好用,是两回事

在 iPhone 上体验端侧模型,门槛其实不算高。

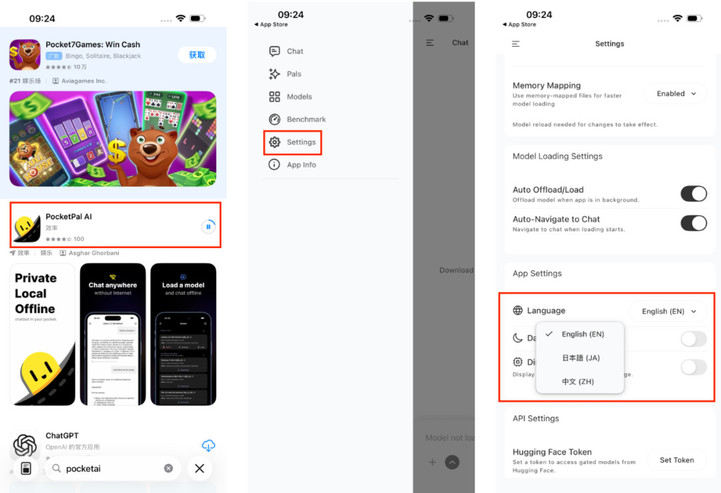

打开 App Store,搜索 PocketPal AI,下载安装。如果不习惯英文界面,可以在设置 (Setting) 里找到语言 (Language) 选项,切换成中文。

接着便是下载模型了。

点击左上角图标进入模型库,由于 Qwen 系列模型在开源社区一直都是有口皆碑, 所以我们选择从 Hugging Face 分别下载了 0.6B、1.7B、8B、14B 和 30B 的版本。

当然,你也可以自己本地下载模型,再导进去,这倒是问题不大。

但能下载,不代表能运行。

当你看到「内存警告」的字样的时候,就知道这大概率是行不通了,这里需要解释一下,模型名称后的数字 (如 0.6B) 指的是参数量,B 代表「十亿」(Billion)。

参数可以理解为模型「神经元」的数量,参数越多,理论上模型的理解能力和生成质量越强,但对硬件的算力和运存需求也急剧攀升。

你也可以在基准测试栏里,查看手机的

设备信息。

拿我手上这台 iPhone 17 Pro Max 来说,8B 勉强能跑,14B 模型、 30B 及更大参数的版本,基本上就没法运行了。

在实际体验之前,我们也先用这几款模型跑个分,下面这几张图片, 分别对应着不同参数模型的评测结果。

那么在 iPhone 上用第三方 APP 跑端侧模型, 到底有没有实际意义? 这些模型能否真正支撑日常任务或简单推理?

我的评价是:能用, 但更多是玩具性质,可以尝鲜,但不太建议长期使用。

众所周知,OpenAI 此前曾出炉了一份关于 ChatGPT 的使用报告,主要揭秘大家伙都在用 ChatGPT 干什么,其中主要包含实用指导、信息搜索和写作等事项。

我们也参考这些实际用途,分别对 0.6B、1.4B、8B 等模型问了几个问题。

测试一:制定健身计划

帮我制定一个适合久坐上班族的 7 天核心锻炼计划

和跑分结果一致,模型参数越大,生成的速度越慢。但反之,回答的质量和内容详实程度确实也随参数提升而提升。

0.6B 模型给出的计划放之四海而皆准,有一定的细节,实操价值却不高。

1.7B 稍好, 细节更丰富,能够对久坐带来的腰背酸痛提出针对性的训练计划。

8B 则再上一个档次,开始针对不同肌群给出系统性的建议,且动作更细分,甚至还有暖心小贴士,不过虽说基本维持在 5 token/s 的速度,但体感跟网页版 ChatGPT 的响应速度并无明显差别。

至于发热情况,我是在比较凉爽的室内测试的,在询问 8B 模型几个问题后,也可以明显感觉到手机背部发热明显。

测试二:历史知识问答

宋代的聘猫礼是什么?

这是一个相对冷门但有据可查的历史知识点,指的是宋代民间迎娶猫咪入宅时的礼仪习俗, 主要是为了体现古人对猫主子的尊重程度。

遗憾的是,小参数模型的知识储备严重不足,从 0.6B 到 8B 的模型, 都不知道聘猫礼是啥,而且还特别擅长一本正经地胡说八道。其中 8B 模型更全是车轱辘话。

测试三:时效性信息

iPhone Air 什么时候发布?

这是一个考验模型时效性的问题。

毫无意外,所有端侧模型都答不上来,毕竟它们的知识截止日期停留在训练时,无法获取最新信息。

这一点,恰恰是云端模型的核心优势之一。云端模型可以通过联网检索、实时更新知识库,而端侧模型只能依靠「出厂」时打包进去的那些参数。

测试四:写作能力

我们选择了今年上海卷的高考作文题:

有学者用「专」「转」「传」概括当下三类文章:「专」指专业文章;「转」指被转发的通俗文章;「传」指获得广泛传播的佳作,甚至是传世文章。他提出,专业文章可以变成被转发的通俗文章,而面对大量「转」文,读者又不免期待可传世的文章。

由「专」到「传」,必定要经过「转」吗?请联系社会生活,写一篇文章,谈谈你的认识与思考。

要求:(1)自拟题目;(2)不少于 800 字。

0.6B 模型大概就是传说中凑字数的选手,回答更像是将题目的表面意思复述了一遍,生成的内容缺乏思辨深度,需要大量人工修改才能达到「及格线」。

1.7B 起码还引用了鲁迅作品这类文学素材, 看起来有模有样。而 8B 则表现不错,但与云端模型如 ChatGPT 相比,依旧差距甚远,难以称得上生产力工具。

另外,虽然那模型在训练阶段就已经被「调教」过了,这使得它在输出时,会自然而然地按照某种风格、语气和逻辑来回答,但我们也可以给模型植入系统提示词,并让它生成回答。

比如我就给 1.7B 的模型安排了个「古风小生」的人设。

你别说,这模型还真挺「入戏」的,表达的语感、节奏和人格气质,变得更贴近我的预期。

附上提示词:

但说实话,对绝大多数用户来说,这更像是个好玩的彩蛋,而不是刚需功能。一言以蔽之,我并不太建议你去折腾这种部署端侧模型的方法。

回想 2008 到 2012 年,那是 iPhone 用户「越狱」的狂欢时代。无数人顶着把手机刷成砖的风险,就为了装上几个苹果不许安装的插件,或者把系统界面改得更个性一点。

可当 App Store 的生态已经足够丰富,越狱风险却越来越高,带来的边际收益也越来越小时,如今还有多少人在越狱?

答案不言而喻。

这种所谓第三方端侧模型的折腾方法,即便有隐私方面的加成,但本质上仍是一个独立的应用, 堪比阉割版 ChatGPT,它无法与系统深度整合,也无法调用其他应用的数据,

形如鸡肋。

正因如此,就像当年的越狱一样,这种在第三方应用折腾端侧 AI,或许只会成为一段有趣但短暂的插曲,而真正的未来,依旧属于那些把复杂留给厂商、把简单留给用户的系统级解决方案。

文章来自于微信公众号 “APPSO”,作者 “APPSO”