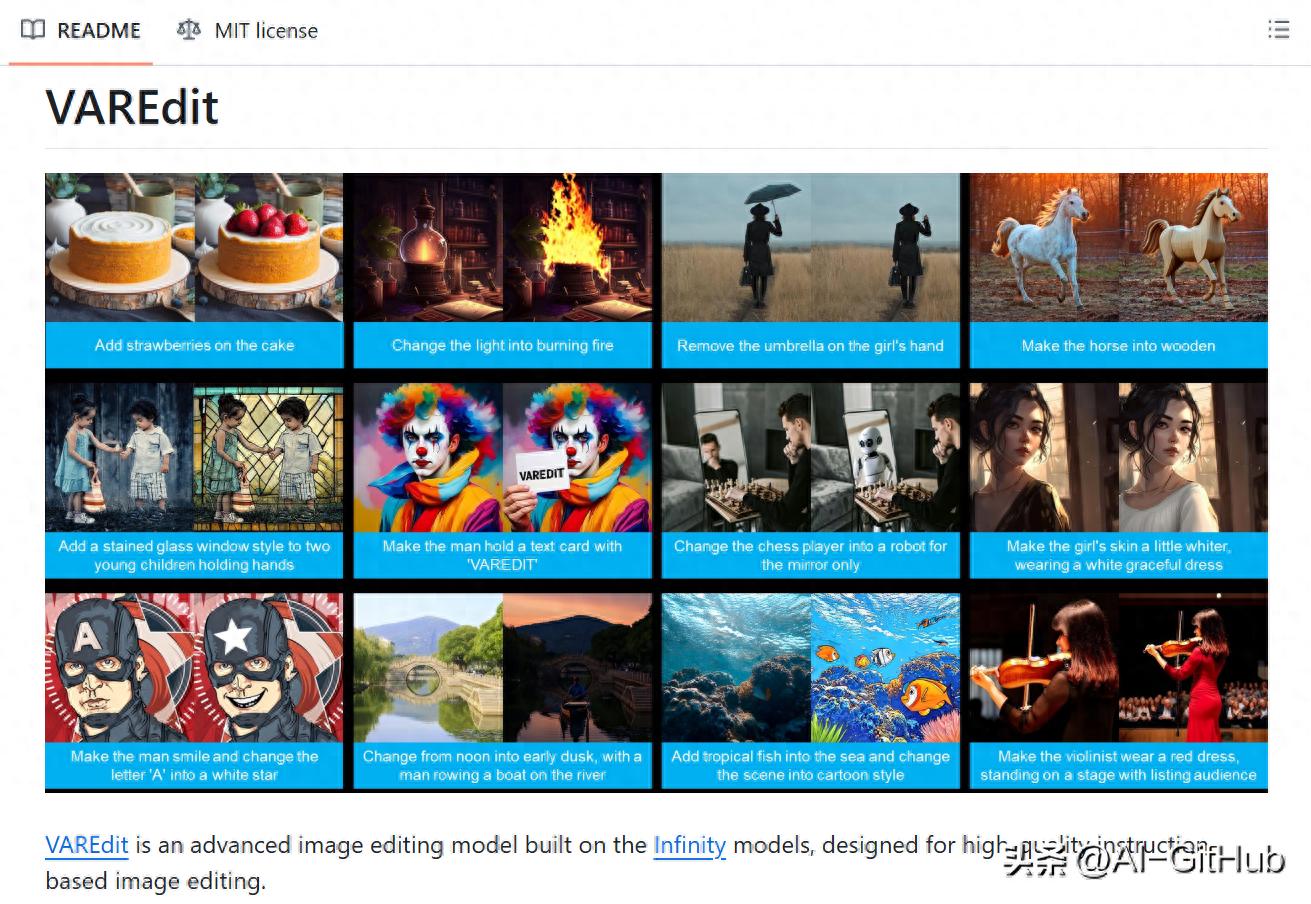

近日,智象未来团队(HiDream.ai)推出了全新的自回归图像编辑框架VAREdit,这是全球首个纯自回归图像编辑模型,标志着图像编辑领域的一次重大技术飞跃。

该框架能够在0.7秒内完成512×512图像的高保真编辑,较传统扩散模型速度提升数倍,同时保持了出色的编辑精准度和指令遵循能力。

技术突破

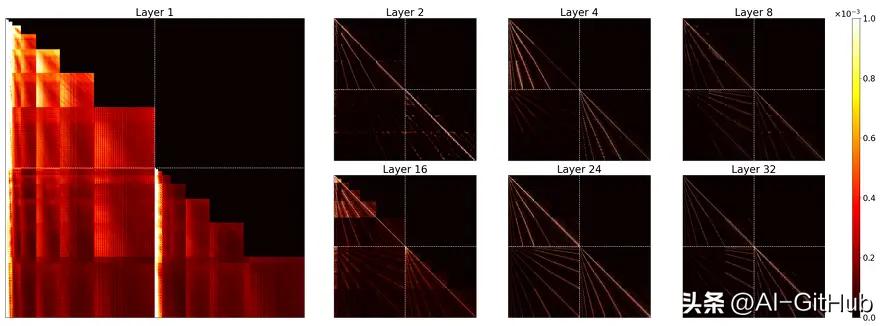

VAREdit首次将视觉自回归(VAR)架构引入图像编辑任务,将编辑过程定义为“下一尺度预测”问题。

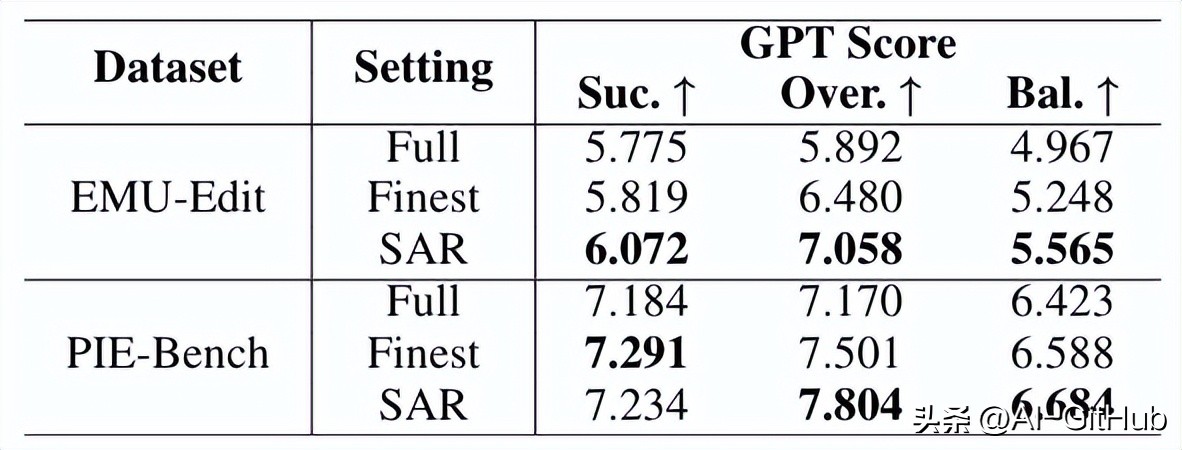

该框架通过逐层生成多尺度残差特征,实现了局部精准修改与整体结构保持的高度统一。团队创新设计了尺度对齐参考(SAR)模块,有效解决了尺度匹配难题,进一步提升编辑质量与效率。

SAR模块采用混合方案:在第一层提供多尺度对齐参考,后续层仅关注最细尺度特征。这种方法既保障了编辑精度,又保持了计算效率。

性能表现

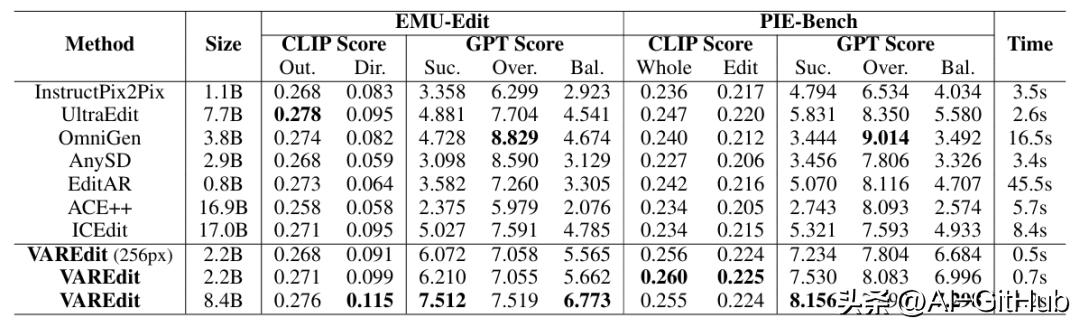

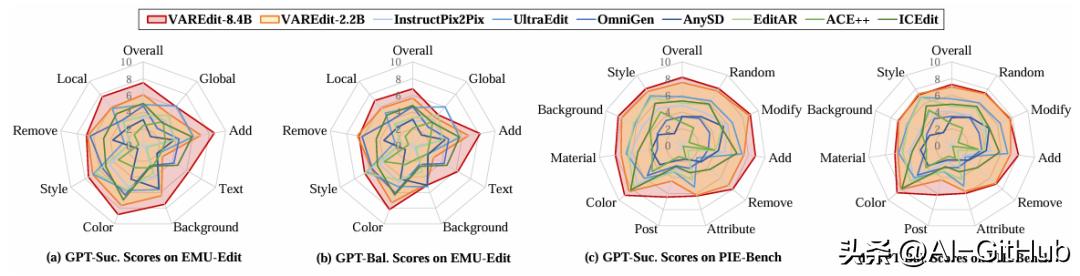

在性能方面,VAREdit在权威基准测试中表现卓越。在EMU-Edit和PIE-Bench测试中,VAREdit在CLIP和GPT指标上均领先。其中,VAREdit-8.4B在GPT-Balance指标上较ICEdit和UltraEdit分别提升41.5%与30.8%,轻量级VAREdit-2.2B也显著优于竞品。

速度上,VAREdit基于下一尺度预测机制优势明显:8.4B模型在1.2秒内完成512×512图像编辑,比同类扩散模型快2.2倍;2.2B模型仅需0.7秒,实现近实时体验。

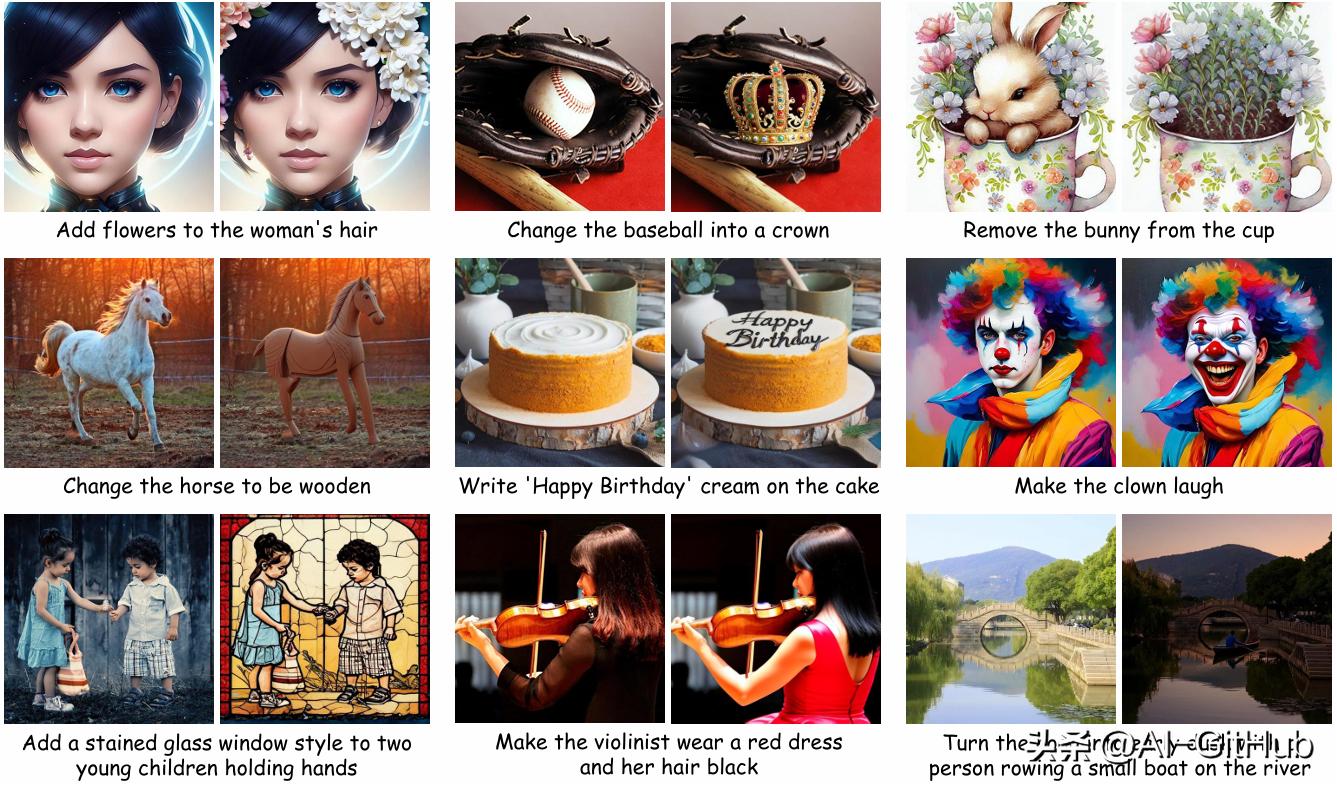

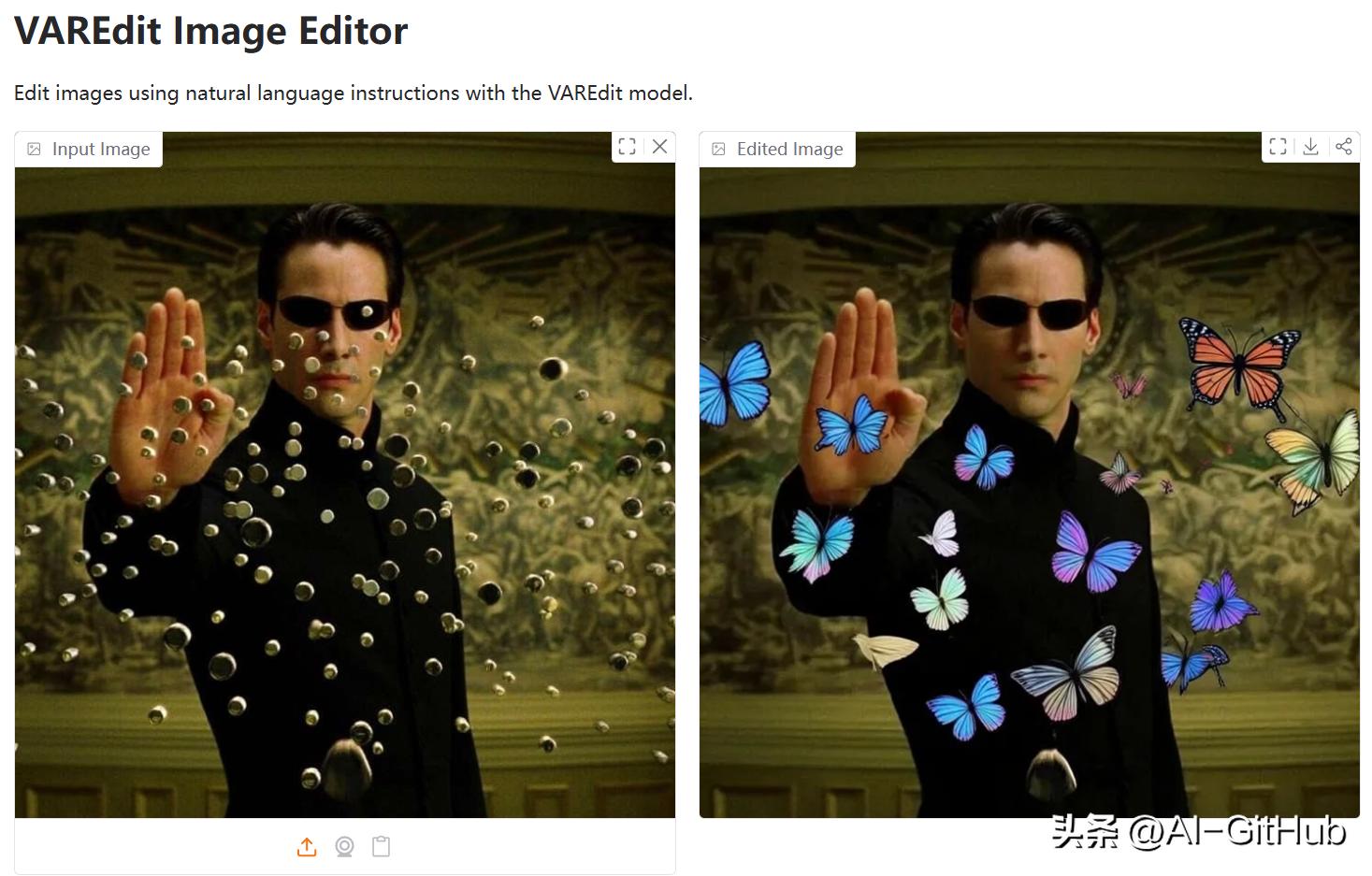

编辑效果上,VAREdit适用范围广,在多数编辑类型(如对象替换、风格调整)中保真度高、过度修改少。视觉对比显示编辑结果自然流畅。

引入SAR模块后,模型精准性指标进一步提升,凸显其优化价值。

VAREdit的高速度和高精度为图像编辑带来了全新的应用体验,普通用户也能在短短0.7秒内完成专业级图像编辑,极大地降低了创作门槛。

这种技术突破将为艺术创作、商业广告和社交媒体内容生成带来更多可能性。

技术论文:

https://arxiv.org/pdf/2508.15772

GitHub:https://github.com/HiDream-ai/VAREdit

#AI开源项目推荐##github##AI技术##AI图像编辑