大型模型不仅仅只有“语言”模型,它们正演变为能够同时理解和处理多种信息类型(或称“模态”)的“多模态模型”。这为产品设计开辟了全新的维度,也对提示词工程提出了新的要求。

什么是多模态提示词?

多模态提示词是一种向AI模型下达的指令,其输入包含两种或两种以上的数据类型。最常见的组合是文本和图像。

但也可以扩展到视频、音频等多种模态的任意组合 。

简单示例:

用户上传一张卡通人物头像,并附上文本提示词:“把图中女孩的衣服换成带花朵图案的短袖”

在这里,模型需要同时“看懂”图片内容和“读懂”文本指令,然后综合两种信息来生成回答。这种能力使得AI能够解决远比单一文本处理更复杂的现实世界问题。

如何撰写多模态提示词?

尽管输入的数据类型增加了,但设计多模态提示词的核心原则、技巧等与纯文本提示词一脉相承。

关键在于通过文本指令,精确地引导模型如何去理解和关联不同模态的信息。

指令要极其具体:避免使用模糊的指令。

反例:“描述这张图片。” 附上一张机场航班信息屏的图片。模型可能只会简单回答“这是一张航班信息板” 。

优例:“请分析这张机场航班信息屏的图片,并将所有航班号、目的地城市和计划起飞时间提取出来,以JSON格式返回。” 这个指令明确告知模型要“看”什么,以及“如何”输出结果。

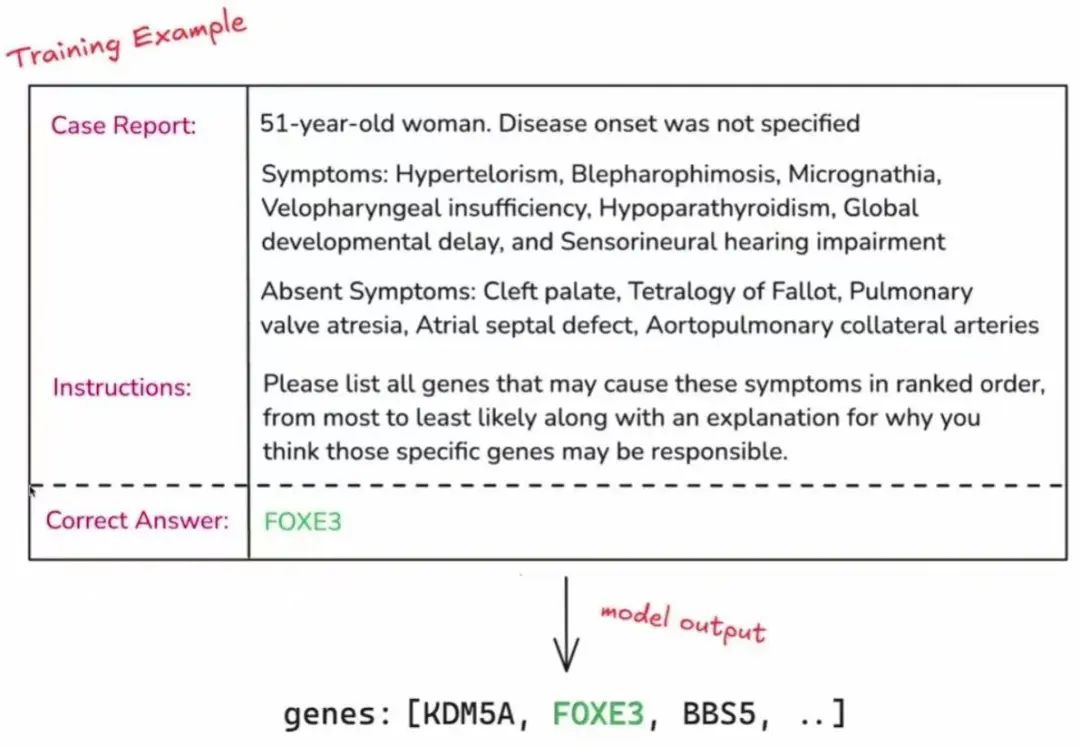

使用少样本示例:当需要模型输出特定格式或风格时,提供包含多种模态的完整示例。

场景:你需要模型根据地标图片,返回“城市: [城市名], 地标: [地标名]”。

优例:在提示词中,先给出几个范例,每个范例都包含一张图片和对应的标准答案文本,如:(罗马斗兽场图片)-> “city: Rome, landmark: the Colosseum”。 然后再附上新的待识别图片,模型便会遵循这个格式进行输出 。

引导模型分步思考(思维链):对于需要复杂推理的视觉问答任务,引导模型分步思考可以显著提高准确性。

场景:用户上传一张照片,里面有3卷卫生纸,并提问“这些卫生纸我能用多久?”

反例:直接提问可能得到一个模糊的答案,如“很快就会用完” 。

优例:将问题分解为指令:“请按以下步骤回答问题:

- 首先,数一下图片里有几卷卫生纸。

- 其次,估算一个普通人平均每天使用多少卫生纸。

- 最后,根据前两步计算出这些卫生纸大约能使用多长时间。”

这种方式引导模型进行了逻辑推理,而不是凭感觉猜测。

指定输出格式:如果需要将模型的输出用于下游的自动化流程,明确指定输出格式(如JSON、Markdown、HTML)至关重要 。

多模态提示词设计面临的常见问题及解决方案

设计多模态提示词时,会遇到一些特有的挑战。

挑战一:提示词不稳定性

问题描述:多模态模型有时对文本提示词的微小变化异常敏感。例如,稍微改变一下措辞,模型对同一张图片的解读就可能发生巨大变化 。

原因:

这源于模型内部复杂的“嵌入空间”和“注意力机制”。相似的词语在模型的向量表示中可能很接近,但句法结构的微小变化,就可能导致注意力权重在图像和文本特征上产生截然不同的分布,从而激活了模型知识网络中完全不同的部分,导致输出结果大相径庭。

解决方案:(这些方案也不一定有用,只能多尝试)

- 强化结构:使用更明确、更结构化的提示词(如使用XML标签包裹指令),减少模糊性。

- 鲁棒性测试:在测试阶段,故意用几种近义词或不同句式来表达同一个指令,观察模型输出的稳定性,并选择最稳健的提示词版本。

- 数据增强训练:在更高级的应用中,可以通过使用增强数据(如同义词替换、句式变换)对模型进行额外训练,以提升其对提示词变化的抵抗力 。

挑战二:模型注意力失焦或理解模糊

问题描述:模型可能没有关注到图片中的关键区域,或者对用户的真实意图理解有偏差。例如,用户想知道一包纸尿裤能用多久,模型却错误地基于包装上的某个数字(如“198片”)给出了一个离谱的答案 。

原因:

图像本身信息密度极大,而文本提示如果不够精确,就无法为模型的“注意力”提供清晰的焦点。模型可能会被视觉上更显著但不相关的特征(如包装上的大号数字)所吸引。同时,对于需要常识推理的模糊问题(如“能用多久”),模型可能倾向于进行字面解读或寻找最直接的数字关联,而非启动复杂的多步推理。

解决方案:

分解任务:将模糊的、一步到位的提问,分解成一系列具体的、可验证的子任务。对于纸尿裤的例子,可以指示模型:

- 识别包装上的纸尿裤数量。

- 基于新生儿每天约用8-10片纸尿裤的常识。

- 计算这包纸尿裤能用几天。

要求解释:在提示词中加入“请解释你的推理过程”或“请说明你的答案是基于图片的哪些信息得出的”。这不仅能暴露模型的错误逻辑,还能引导其进行更深入的思考 。

挑战三:高质量测试数据对齐困难

问题描述:创建用于评测和优化的多模态数据集比纯文本更具挑战性,因为它需要确保不同模态数据间的精确对齐(例如,一张图片需要配上一个准确、详尽且无偏见的“标准答案”描述)。

原因:

这主要源于标注的“主观性”和“高成本”。同一张图片,从不同角度可以有多种“正确”的描述,其详略、侧重都不同,因此定义一个统一、客观、无偏见的“标准答案”本身就极具挑战。此外,为海量图片进行高质量、精细化的文本标注,所需的人工成本和时间成本远超纯文本数据的处理。

解决方案(对产品和业务人员而言):

- 建立“黄金标准集”:在产品开发初期,不必追求大规模数据集。可以由领域专家或团队成员共同创建并审核一个规模较小(如20-50个案例)但质量高的“黄金标准”测试集。

- 人工审核为主:对于多模态输出的评测,初期应以人工审核为主,对照黄金标准集进行评估。自动化评测工具可以作为辅助,但不能完全替代人类对视觉和语境细微之处的判断。

案例:假设我们要评测一个AI模型的“商品描述生成”功能。

– 输入图片:一张白色背景、角度略微俯视的“Nike Air Force 1”运动鞋图片。

– 目标:模型能生成一段吸引人的、准确的商品描述。

– 对齐挑战:

– 标注A(事实派):“一双白色的Nike Air Force 1运动鞋,皮革材质,侧面有Swoosh标志,白色鞋底。”

这个描述非常客观,但缺乏营销吸引力。

– 标注B(营销派):“经典永不过时!标志性的Air Force 1,利落的皮革、大胆的配色和恰到好处的篮球风格,让你成为焦点。”

这个描述很有吸引力,但可能忽略了一些具体的产品细节。

– 标注C(细节控):“产品型号AF-1-007,男款,尺码42。鞋面采用头层牛皮,橡胶外底,鞋舌处有Nike品牌标签,后跟处有刺绣Logo。”

这个描述非常详尽,但对普通消费者来说可能过于技术化。

三个“标准答案”都是“正确”的,但风格和侧重点完全不同。如果评测团队不对标注标准达成高度一致,那么模型的输出无论接近哪个版本,都可能被判定为“不准确”。这种不一致性使得自动化评测变得极为困难,也让模型优化的方向变得模糊不清。

谷歌针对Gemini的多模态提示故障排除策略

为了改进您的多模态提示,特别是当您未获得所需结果时,可以尝试以下几种故障排除策略:

故障排除是哪一部分失败

为了区分模型是未理解图像(图像理解)还是理解了图像但推理步骤出错(推理步骤),可以要求模型描述图像中的内容。

另一种策略是要求模型解释其推理过程。这有助于缩小问题范围,找出推理中断的部分。

将图像置于文本提示之前(针对单图像提示)

虽然 Gemini 模型可以按任意顺序处理图像和文本输入,但对于包含单张图像的提示,将图像(或视频)放在文本提示之前可能会获得更好的性能。然而,如果提示需要图像与文本高度交错才能理解,则使用最自然的顺序即可。

明确且具体地给出指令

为了获得您想要的特定输出,提示词需要清晰和详细,确保指令具体,并留下最小的误解空间。

例如,仅仅要求模型“描述这张图片”可能会得到一个通用描述。但如果您需要模型从图片中解析时间和城市,您应在提示中直接提出这个请求,从而获得更具体的列表。

多模态技术正在迅速演进,其架构(如统一嵌入、交叉注意力)和模型能力也在不断变化 。对产品和业务负责人而言,关键在于掌握上述核心设计原则,并保持对新技术趋势的关注,从而能够持续地将这些强大的多模态能力转化为创新的产品功能。

本文由 @Mrs.Data 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务