中后台研发提效背景

目前,我们正处于AI研发在企业生产环境中应用落地的关键转折点。Web编码不仅限于Vibe式的"氛围"编程,而是能够切实地应用于围绕需求规范驱动的实际业务场景中。

中后台业务有特征使得非常适合落地ai编码的场景,包括不需要考虑:三端(Android,IOS,Web)一致性,对比页面加载性能和UI还原度,对比交付效率优先级会更高。

今年我们团队开发了业务前端页面的NC VSCode IDE开发插件,目前已在团队内全面推广应用。

随着大模型技术的快速发展,前端页面开发的成本已大幅降低。现在只需要明确三个关键要素:业务需求逻辑、交互设计和服务端接口定义,就能快速完成页面开发。

以最新的Claude 4等先进模型为例,它们在Web页面开发方面展现出卓越能力。这背后的核心原因在于训练数据的分布特征:大模型训练时,JavaScript和Python等主流编程语言在公共网络中拥有海量的高质量代码样本,为模型提供了丰富的学习素材。对于前端开发而言,JavaScript生态的开放性和活跃度为AI辅助开发提供了得天独厚的优势。

相比之下,COBOL等传统语言由于在开源社区和公共代码库中的数据稀少,模型的表现相对有限。这种训练数据的差异直接决定了大模型在不同技术栈上的能力边界。

提效瓶颈的深度分析

通过实际数据统计,我们发现AI辅助开发的提效结果并非线性关系——AI承担50%的编码工作,并不等同于工时减少50%。深入分析后,我们识别出两个核心制约因素:

制约因素一:场景适配性局限 当前主流的AI提效方案主要针对从零构建页面的场景,但实际业务需求中,大部分工作围绕长期工程项目的变更迭代展开。对于基于现有代码库的功能增量开发,现有方案的提效作用有限。

制约因素二:编码时间占比偏低 通过工时分析发现,程序员纯编码时间仅占整体工作量的25%左右,通常不超过40%。真正的效率瓶颈往往在于需求评审、会议协调、排期对齐等信息同步环节,而非编码本身。

所以今年在解决研发提效这个命题的时候,不是怎么去提升写代码的效率,而是如何把程序员从大量“CRUD类业务需求”的中解放出来,让Agent从PRD阶段就开始介入,实现从PRD到代码交付的完整需求研发流程。让开发同学能更专注于复杂的架构设计、技术选型和业务创新等更具创造性的工作。

核心技术重点

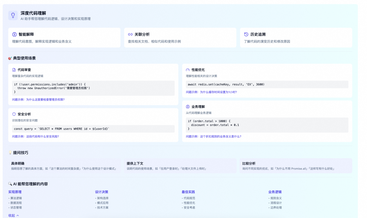

▐ 2.1. 研发Agent的设计理念

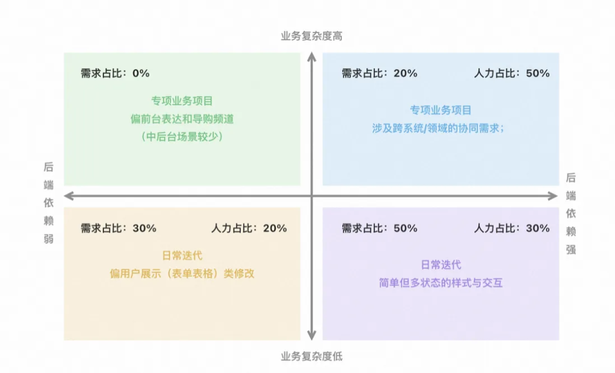

基于业务需求统计分析,我们将初期重点聚焦于中后台场景下1-3天人日及以下的日常开发需求。数据显示,此类需求在整体业务需求中占据相当高的比例,具备显著的规模化提效价值。

当前系统处于快速迭代阶段,我们正持续优化Agent的准确率和稳定性。待技术成熟度达到生产标准后,将推进云端部署策略。

一旦实现PRD到代码部署的完整自动化链路,可以向产品经理、业务运营等非技术角色开放,真正实现"人人皆可开发"的技术普惠愿景。这将从根本上重构传统的需求-开发协作模式。

2.1.1. 垂直化

当前市场上的通用Agent产品(如Manus等)普遍采用大对话框交互模式,表面上功能全面,但实际效果有限。以Manus为例,其任务完结率也就在35%不到,显示了通用型方案在不同类型的需求下落地的问题。

基于对行业趋势的深度分析,我认为Agent技术的未来发展方向必然是垂直化专业解决方案。以Cursor、Claude Code等产品为例,虽然它们在编码阶段表现出色,但由于缺乏企业内部研发SOP和标准化规范的深度集成,无法覆盖从需求到交付的完整业务流程。

知识沉淀的关键价值

垂直化场景需要大量行业专有知识信息的深度沉淀,包括业务规范、技术标准、流程模板等。缺乏这些专业语料输入,Agent在私有化、专业化业务场景下难以达到生产级别的需求交付质量。

2.1.2. 以需求为中心,而非工具导向

当前,无论是集团内部还是外部厂商,都在AI Native IDE赛道展开激烈竞争。外部有Cursor、Windsurf等产品,国内有Trae,CodeBuddy等方案,集团内部也是是百花齐放。

观察最前沿的编码智能体产品——Claude Code、Gemini CLI——我们发现一个重要趋势:顶级方案并非以IDE形态呈现,而是采用更加灵活的独立Agent架构。这种架构选择背后有着深刻的技术逻辑:当前编程智能体已具备仓库深度理解、智能代码召回、业务知识库集成等核心能力,开发者无需进行冗余的上下文描述或手动代码选中操作。

交互模式的根本性变革

在新的交互范式下,开发者只需直接提交问题或需求描述,Agent即可自主完成:

需求理解与代码定位 自动化代码变更实施 LLM驱动的单元测试生成与执行 基于Browser Use等服务的浏览器环境验证 Agent自主完成的Code Review流程

未来趋势:需求驱动的开发模式

当前IDE定位的局限性认知,目前绝大多数的IDE仍然局限于解决编码阶段的研发问题,这种定位在AI时代显得越来越不合时宜。无论是传统的VSCode、IntelliJ IDEA,还是新兴的AI增强型IDE如Cursor、Windsurf,它们的核心关注点依然停留在代码编写、调试和基础的智能提示层面。

以Amazon Kiro的SPEC模式发布为重要的行业转折信号,我们可以清晰洞察到研发模式的根本性变革趋势:从工具中心向需求中心的智能化转型。

Kiro的SPEC驱动开发将单一需求描述自动展开为完整的技术实现链路,这标志着行业正在从"如何更好地写代码"转向"如何更好地实现需求"的思维范式。在这种模式下,将单一提示(如"添加产品评价系统")自动展开为三个结构化组件:requirements.md(需求文档)、design.md(设计文档)和tasks.md(任务清单),真正实现了从"工具辅助编程"到"需求驱动开发"的范式转换。

相比于在IDE功能上的同质化,我们更应该专注于构建以需求为核心的智能化研发体系,未来的技术竞争核心将是需求理解能力和端到端交付的系统化程度,而非单点工具功能的堆叠。让技术真正服务于业务价值创造。

▐ 2.2. Multi Agent System:

关于Multi-Agent架构设计,行业内已有大量技术文章和ATA分享覆盖通用技术能力。这里重点聚焦Coding Agent与Cursor、Cline等主流研发工具在架构设计上的差异化对比。

2.2.1. 垂直化vs通用化的技术路径分析

主流工具的架构局限:单体Agent模式

当前主流Coding Agent产品普遍采用单体Agent架构。尽管部分产品引入了Planning阶段,但其核心能力仍局限于"Prompt到编码"这一单一环节的优化。

技术选择的底层逻辑 这种架构选择背后有着明确的产品定位考量:面向广泛行业技术开发群体的通用型产品,必须兼容多种行业和不同工作台研发流程,因此在架构复杂度上需要保持克制。

业务需求的完整链路映射

在实际业务开发中,标准研发流程通常包含以下关键阶段:

需求确认与PRD梳理 前端技术方案设计(常被简化或跳过) 开发任务拆解与分配 代码实现与单元测试 代码提交与发布部署

NC AI Coding Agent的Multi-Agent架构设计

基于业务链路的完整映射,我们构建了专业化的Multi-Agent体系:

子Agent职责分工

- 需求分析Agent:PRD解析与技术需求转换

- 任务拆解Agent:开发任务颗粒化与优先级排序

- 代码编写Agent:具体功能实现与代码生成

- 发布部署Agent:CI/CD流程执行与环境部署

协调机制设计 各子Agent作为独立可运行的模块,由Master Agent统一协调管理,支持基于实际需求动态调整执行序列,确保流程的灵活性和可扩展性。

Workflow模式的优势选择

考虑到行业内需求研发链路的相对标准化特征,我们采用Workflow模式替代完全动态的Agent调度。这种设计选择能够:

提供更清晰的流程可视化 降低系统复杂度和故障排查难度 保持足够的灵活性同时确保流程标准化

这种架构既保证了专业深度,又兼顾了工程实践的可靠性。

2.2.2. ReAct模式和Human in the Loop:智能协作的核心机制

ReAct模式:推理与行动的统一框架

ReAct(Reasoning and Acting)模式是现代Agent系统的核心架构模式,通过将推理过程与具体行动紧密结合,实现了更加可靠和可解释的智能决策。该模式的核心特征包括:

推理透明化:Agent在执行每个操作前都会明确表达其推理逻辑 行动可追溯:每个决策步骤都有明确的思考路径记录 错误自纠正:通过观察行动结果调整后续推理策略 工具链集成:支持复杂的多步骤工具调用与结果整合

Human in the Loop(HITL)强调在自动化流程中加入人工监督和干预,确保AI系统在复杂业务场景下的可控性和准确性:

核心协作机制

- 人工审核校验:通过人工审核检查和修正AI输出,确保结果质量符合业务标准

- 实时干预控制:在关键决策节点暂停执行,等待人类专家判断和指导

- 反馈学习优化:收集人类反馈数据,持续改进系统决策能力和准确率

在Coding Agent中的应用实践

关键节点控制&反馈机制设计

- 需求理解确认:PRD解析完成后,由产品或技术负责人确认需求理解准确性

- 技术方案评审:架构设计方案生成后,由工程师进行技术可行性评估

- 代码质量把关:核心功能代码生成后,通过人工Code Review确保代码质量

- 即时纠错反馈:开发者可在任意环节对AI输出进行实时修正和指导

- 历史经验沉淀:将人工干预的决策逻辑沉淀为知识库,提升后续类似场景的自动化率

- 持续学习循环:基于人类专家的反馈数据,不断优化Agent的决策模型和执行策略

通过ReAct模式与Human in the Loop的深度结合,我们实现了既保证自动化效率,又确保输出质量的智能研发体系。

2.2.3. Requirement Agent:智能需求分析的技术实现

需求分析Agent作为整个研发链路的起始环节,承担着将产品需求转化为技术实现方案的关键职责。该Agent具备专业前端开发视角,能够从多维度输入中精准提取技术实现要素。

多维度输入处理能力

需求分析Agent的输入源以核心PRD文档为主,同时根据项目复杂度灵活接纳相关补充资料。这些扩展材料通常包括后端接口文档与API规范、UI/UX设计稿与交互原型、业务流程图与数据模型,以及技术约束与性能要求等关键信息。

智能分析输出

基于专业前端开发经验,需求分析Agent对输入材料进行深度解析,自动识别并拆解核心功能模块边界,精准定位当前需求对现有系统的影响范围。同时生成清晰、结构化的技术实现规划,并识别模块间依赖关系和开发优先级,为后续开发环节提供明确指导。

MCP服务架构集成

Agent初始化时会自动启动多类型MCP(Model Context Protocol)服务,构建完整的工具生态。在本地服务通信方面,系统采用STDIO通信服务确保高效的本地进程间通信和低延迟响应,同时直接集成文件系统以访问本地代码仓库和文档资源。

远程服务集成则通过SSE流式通信支持实时数据流传输,配合Streamable协议在高并发场景下实现可靠数据传输。特别值得注意的是,系统深度集成了Aone MCP Marketplace这一集团内部标准化工具服务平台,为开发流程提供了丰富的基础工具支持。

数据安全与合规保障

在使用Cursor、Cline等第三方工具时,往往存在显著的数据泄露风险。业务敏感信息可能在无感知情况下传输至外部服务,API Key、数据库连接串等关键凭证面临暴露风险。当开发环境中同时使用VPN、代理工具时,数据流向的不可控性进一步加剧了安全隐患。

针对这些安全挑战,我们在PRD分析阶段采用了Qwen VL视觉语言模型的本地化部署方案。这种设计确保数据处理完全在本地环境中完成,在需求分析层面即实现了业务敏感数据的有效隔离。系统根据数据敏感级别采用差异化处理策略,关键数据处理环节与外网完全隔离,并基于角色实现细粒度的数据访问控制。

通过这种架构设计,我们在保证智能化分析能力的同时,从技术底层确保了企业数据的安全性和合规性,满足了企业级应用的严格安全要求。

2.2.4. TaskPlan Agent vs CodeAct Agent:从计划到执行的智能分离

任务拆解Agent的核心价值

在当前的一些编码Agent应用中,普遍会存在的一个问题:实际编写的代码质量极不稳定。这种现象如同一个人做事时缺乏思考,一股脑直接动手,结果往往难以令人满意。即使偶尔能产出不错的结果,也很难保障持续的稳定输出。

编程工作同样遵循这一规律。正确的开发流程应该是针对需求变更制定详细的变更计划。首先需要全面收集所有相关的有用信息,然后基于前一阶段需求分析Agent产出的"前端技术方案"进行编码策略的系统性拆解,最终产出一份详细的变更执行计划,即具体的编码任务清单。

Plan Mode与Act Mode的架构分离

目前主流的编码Agent都支持Plan Mode和Act Mode的模式切换,这种设计体现了软件工程中"思考与执行分离"的核心理念。

这种Plan-Act分离的架构设计带来了显著的工程价值。通过将思考与执行明确分离,我们不仅提高了代码生成的质量稳定性,还增强了整个开发过程的可控性和可追溯性。开发者能够在Plan阶段充分评估风险和制定策略,在Act阶段则专注于高效执行,从而实现了开发效率与代码质量的双重提升。

2.2.5. 任务设计:超越传统Plan模式的架构创新

相比Claude Code和Cline的规划过程,NC Coding Agent在任务设计维度实现了更精细化的颗粒度控制。经过反复测试验证,我们参考了业内知名项目Task Master的设计理念,构建了完整的任务对象架构体系。

每个任务对象包含丰富的元数据信息:从基础的ID标识和描述性标题,到详细的实施指导和验证策略,再到复杂的依赖关系管理和优先级排序机制。特别值得注意的是,我们引入了状态追踪机制,通过previousStatus字段实现变更轨迹的完整记录,为项目管理和问题追溯提供了可靠基础。

Property财产 |

Type类型 |

Description描述 |

Example例子 |

|

Number |

Unique identifier for the task |

|

|

String |

Brief, descriptive title简短的描述性标题 |

|

|

String |

Concise description of the task purpose |

|

|

String |

Current state ( , , |

|

|

Array |

IDs of tasks that must be completed before this task |

|

|

String |

重要性级别( |

|

|

String |

In-depth implementation instructions |

|

|

String |

Verification approach for the task |

|

|

Array |

List of smaller, more specific tasks |

|

|

String |

Status before the current one (for tracking changes) |

|

2.2.6. Deployment Agent:端到端交付的智能化闭环

代码编写完成后,需要进入代码管理和发布环节。Deployment Agent作为研发链路的最后一环,承担着从代码提交到最终交付的完整自动化流程。

核心功能职责

Deployment Agent的职责范围涵盖了完整的代码交付生命周期。在版本控制管理方面,它负责执行标准化的Git操作流程,包括创建符合命名规范的开发分支、生成规范化的提交记录以及推送代码到远程仓库。这些操作都严格遵循企业级的代码管理最佳实践,确保版本历史的清晰性和可追溯性。

平台集成与工作流自动化

通过与集团研发 Code MCP的深度集成,Deployment Agent能够自动生成Merge Request,并处理与部署相关的各项配置工作。整个流程完成后,系统会主动发送浏览器消息通知,及时告知用户需求已完成交付,可前往集团研发平台进行验收确认。这种端到端的自动化机制大大减少了人工干预的环节,提升了交付效率。

多平台部署能力扩展

在预发环境部署方面,Deployment Agent展现出了良好的平台适配能力。对于标准的集团研发应用,系统已经具备了直接部署的完整能力。针对前端中后台业务场景,目前对接了多种部署环境。

采用了可扩展的设计理念。随着各研发平台陆续提供对应的MCP服务支持,Deployment Agent将能够无缝集成更多的部署目标,实现真正意义上的多平台统一部署能力。这种设计不仅保证了当前业务需求的满足,也为未来的技术演进预留了充足的扩展空间。

通过这种智能化的部署管理,我们实现了从需求分析到最终交付的完整自动化链路,让开发者能够专注于业务逻辑的实现,而将繁琐的部署流程完全交给AI来处理。

▐ 2.3. 上下文工程:解决AI编程的根本挑战

AI编程面临诸多固有局限,包括"抽盲盒"式的不确定性、领域偏科现象、短期记忆缺失以及信息滞后等问题。与人类开发者最根本的差异在于,AI缺乏"长期记忆"能力,每次对话都只能基于当前提供的有限信息理解项目全貌,且无法进行意图推测。

我喜欢将Coding AI类比为"患有健忘症的技术专家"——它拥有扎实的技术功底,却对业务背景和代码历史一无所知。因此,无论是新项目开发、需求迭代还是Bug修复,核心都在于为AI提供精确的上下文信息。提供的背景越详实,AI需要"猜测"的部分就越少。精确的上下文虽不能保证完全正确的结果,但模糊的上下文必然导致模糊的产出。

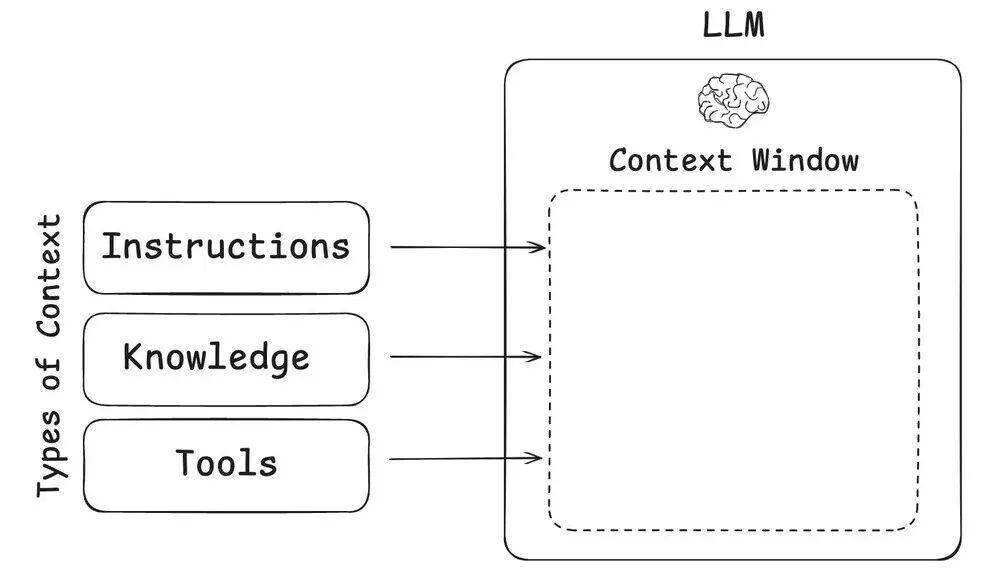

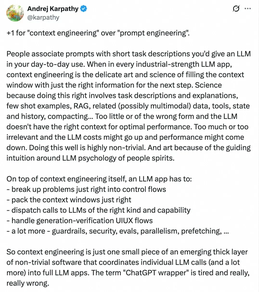

上下文工程(Context Engineering)的本质可以通过与提示词工程的对比来理解:如果说提示词工程更像是在定义模型的角色和身份,那么上下文工程则是为模型提供完成任务所需的具体信息和背景知识。

正如Andrej Karpathy所阐述的,LLM可以类比为一种新型操作系统。在这个类比中,LLM相当于CPU,而上下文窗口则相当于RAM,充当模型的工作内存。与物理RAM的限制类似,LLM上下文窗口处理各种信息源的能力同样有限。正如操作系统需要智能筛选适合加载到内存中的内容一样,上下文工程也承担着类似的资源管理和优化调度职能。

上下文工程领域延伸出很多手段:

RAG(Retrieval-Augmented Generation,检索增强生成):通过语义化响亮搜索,从知识库中检索与用户问题最相关的文档片段,并拼接到上下文,提升回答准确性; Memory(记忆):引入长短期记忆,帮助模型回顾过往记录; -

Tool Calling/MCP(工具调用):通过结构化提示词告诉模型如何调用预定工具(如数据库查询、API调用等)来获取外部信息,是一种与世界连接的输入增强方式。 ![]()

▐ 2.4. 代码Context理解与处理

在需求分析子Agent完成具体需求拆解之后,如何高效、准确地理解和处理现有代码仓库成为了整个系统面临的核心技术挑战。我们的目标是让AI具备如经验丰富的工程师般的能力:能够快速熟悉项目架构、深入理解代码逻辑,并在此基础上完成代码生成、智能问答和架构重构等复杂任务。

面对动辄数万行甚至数十万行的企业级代码库,将整个代码仓库直接输入LLM显然是不可行的。这种简单粗暴的方式会带来多重挑战:

- 技术层面限制:会轻易突破模型的上下文窗口边界,同时引发高昂的计算成本和不可接受的响应延迟

- 安全风险考量:全量代码暴露可能导致敏感信息泄露,包括API密钥、数据库连接串等关键凭证的意外暴露

主流的是基于关键信息的检索方式。诸如于:

Cline:AST(抽象语法树) + 正则检索 Copilot(2024):生成关键词 + TreeSitter AST(抽象语法树)中的关键信息(类、方法名等)搜索 Cursor:Ripgrep 文本搜索 + 云端的向量化 Continue:基于 SQLite 的文本搜索 + LanceDB 本地向量化 ……

除此之外还有一些实验性的方案,比如图索引之类的,甚至关于如何高效的定位变更代码还有专门的评测集,我这里就不详细展开了,有兴趣的可以去看这里的论文。

https://arxiv.org/abs/2503.09089

https://huggingface.co/datasets/czlll/Loc-Bench_V1

NC Coding Agent的代码分析架构

2.4.1. DeepWIKI方案:预生成代码库文档的智能化实践

预生成文档的战略价值

当检索系统需要在云端运行时,性能和效率成为关键考量因素。预生成文档方案在这种场景下展现出显著优势:它不仅能够有效解决存量文档老旧过时的问题,更重要的是能够大幅提升检索效率,为AI理解代码库提供高质量的结构化信息。

DeepWIKI的行业影响与局限

业界知名的DeepWIKI正是预生成代码库文档的典型代表。这一方案在开源社区获得了广泛认可,为代码理解和知识管理提供了重要的技术参考。

然而,直接使用DeepWIKI面临两个核心挑战:

成本与安全性约束:对于GitHub上的高热度开源软件,Cognition提供免费的DeepWIKI服务,但企业内部私有化代码需要付费使用。更关键的是云端运行模式本身带来的安全性隐患,企业敏感代码信息面临泄露风险。

功能定位的不匹配:DeepWIKI作为通用型基础服务,其关注重点主要集中在服务端实现、部署流程等后端技术栈。而我们的应用场景主要面向前端代码仓库,需要更加聚焦于前端页面交互逻辑、数据流管理、组件使用规范等前端特有的技术维度。

前端定制化的DeepWIKI实现

基于上述分析,我们自主实现了面向前端场景的DeepWIKI版本。这个定制化方案专门针对前端技术栈的特点进行了深度优化,重点关注前端开发者最关心的技术要素:页面交互模式、数据流架构、组件库使用规范以及前端工程化实践等。

LLM理解的基础支撑

这份预生成的文档在LLM开始规划的第一步就会被读取,作为AI理解代码库的基础信息源。通过这种方式,大模型能够快速建立对仓库结构的整体认知,理解技术架构的设计思路,掌握各个模块的功能定位和相互关系。这种全局性的理解为后续的精准代码分析和生成奠定了坚实的认知基础。

2.4.2. Codebase Index方案:语义化代码检索的技术实现

代码索引作为第二层技术架构,主要承担为需求变更范围提供大致方向性指导的职责。这一层的准确性直接影响后续精确代码定位的效率和质量。

传统代码搜索方案存在明显的技术瓶颈:

- 关键词匹配:仅能找到包含特定文本的代码片段,缺乏语义理解能力

- 正则表达式:虽然功能强大但语法复杂,难以准确表达业务语义

- 静态分析:局限于结构化搜索,无法理解代码的深层语义关系

语义搜索的技术突破

基于向量索引的语义搜索技术为代码理解带来了革命性提升:

语义理解能力:能够理解代码的深层语义含义,而非仅仅进行文本匹配

自然语言交互:支持如"用户认证逻辑"这样的自然语言查询方式

功能相似性识别:能够找到功能相似但实现方式不同的代码片段

跨语言检索:支持在不同编程语言中搜索相似功能的实现

两阶段处理架构

索引构建阶段:

将非结构化和结构化数据通过特定拆分策略进行处理,经过向量化转换后存储到数据库中。知识库构建的质量直接决定了后续检索效果的上限。核心技术挑战包括如何合理分块以保持语义完整性(特别是代码边界的处理)、选择适合的嵌入模型进行向量化处理,以及针对多源数据进行有效预处理,避免"垃圾进、垃圾出"的质量问题。

检索执行阶段:

对用户输入进行语义转换和向量化处理,在数据库中执行检索操作,返回相关上下文信息,经过后处理优化后传递给生成模型。即使用户查询意图明确,从海量索引中高效准确地定位相关信息仍然面临挑战。精准检索需要解决查询歧义性问题、提升搜索能力(如混合搜索、HyDE技术)、实施结果重排序(Re-ranking),并合理控制上下文长度以防止信息丢失或干扰生成质量。

技术方案的差异化优势

我们目前采用Dev Studio提供的技术方案,与Cursor相比具有显著的技术优势:

高效检索引擎:采用hnswlib引擎实现高效的近似最近邻(ANN)搜索,查询时间复杂度接近O(log N),大幅提升检索性能 模型技术选型:embedding和reranking模型均采用qwen3系列,在安全性和索引质量方面表现优异 数据安全保障:索引文件部署在本地环境,相比Cursor将索引存储在云端服务器的方案,有效避免了数据安全风险

效果示例:

2.4.3. TreeSitter方案:基于AST的精确代码定位

精确定位的技术实现

在代码理解的最后一层,我们需要实现精确的代码定位能力。TreeSitter方案通过抽象语法树(AST)技术深度理解代码结构,能够逐步探索文件间的复杂关系,建立连贯的上下文理解体系。最终通过AST解析精准定位到需要修改的具体方法和代码片段。

Cline的技术哲学与实践

Cline官方博文中,作者Nick Baumann深入探讨了Cline处理大型代码库的独特方法论。文章特别强调了Cline刻意避免使用传统检索增强生成(RAG)方法的设计理念,这种选择旨在提升代码质量、安全性和可靠性。

RAG方法在代码场景下的固有局限

虽然RAG是处理大型知识库的主流技术,但在代码库应用中却面临根本性挑战。代码的高度互联性、快速演进特征以及敏感性特点导致了三个核心问题:

语义割裂问题:代码逻辑具有高度连贯性,难以进行合理分割,检索到的代码片段往往无法体现完整的上下文关系 同步滞后问题:代码库更新频繁,索引系统难以实时跟上代码变化节奏,容易产生信息偏差和过时数据 安全风险问题:创建代码嵌入副本增加了敏感信息泄露的安全风险,不利于企业级应用

大语言模型的原生优势

Cline的方案充分利用了大语言模型(如Claude 4)的巨大上下文窗口能力,确保代码信息的相关性和准确性。这种approach基于一个重要判断:当前AI能力已经足以像经验丰富的开发者一样进行代码思考和理解。

技术发展的前瞻性判断

文章提出了一个具有前瞻性的观点:未来属于真正理解代码的智能系统,而非仅仅依赖检索机制的工具。这种技术路线选择体现了对AI核心能力的深度信任,以及对代码理解本质的深刻洞察。

通过TreeSitter与大语言模型的深度结合,我们能够实现既保持代码语义完整性,又具备精确定位能力的智能化代码分析系统,这为后续的代码生成和修改提供了可靠的技术基础。

参考原文:https://cline.bot/blog/why-cline-doesnt-index-your-codebase-and-why-thats-a-good-thing

▐ 2.5. 行业知识图谱:弥合通用模型与专业场景的认知鸿沟

在完成代码仓库理解、获取充足上下文信息并精确定位变更位置后,开发流程进入了具体的编码环节。这一阶段面临着一个关键挑战:缺乏足够的行业知识语料输入,大概率会导致生成的代码不符合业务预期和技术规范。

知识截止点带来的结构性局限

大型语言模型的训练基于特定时间点的数据快照,这个时间节点被称为"知识截止点"。这种训练模式虽然确保了模型的稳定性,但也带来了两个核心认知盲区:

企业内部资源的认知空白

模型无法识别和正确使用企业专有的组件库系统,缺乏对团队特定编码规范和最佳实践的理解,对内部中间件的使用方式和配置规范存在认知缺失。这些企业级的专有知识往往是确保代码质量和维护效率的关键要素。

技术栈演进的滞后响应

最新发布的框架和工具库无法及时在模型知识中得到反映,新兴技术方案和设计模式的缺失导致生成代码可能采用过时的实现方式。更严重的是API变更带来的认知偏差问题,已有工具的API可能已发生重大更新(如Tailwind CSS v4的breaking changes),模型对废弃方法和新增特性的把握存在准确性问题。

这些知识盲区的存在,使得通用大语言模型在面对具体业务场景时,往往难以生成真正符合企业标准和行业最佳实践的高质量代码。因此,构建面向行业特定需求的知识图谱成为了提升AI编码质量的必然选择。

2.5.1. 业界主流产品的一些实现方案

2.5.1.1. Cursor知识库

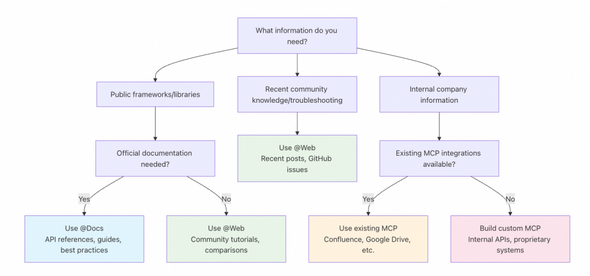

Cursor官方前不久更新了一篇指南,主题名为“Working with Documentation”,目的是指导大家如何在Cursor中更好地使用三类文档(@Docs、@Web、MCP),以帮助模型获取能够获取最新、最准确的上下文信息。

https://docs.cursor.com/guides/advanced/working-with-documentation

2.5.1.2. Cline Memory Bank:项目知识的结构化管理

分层式项目记忆架构

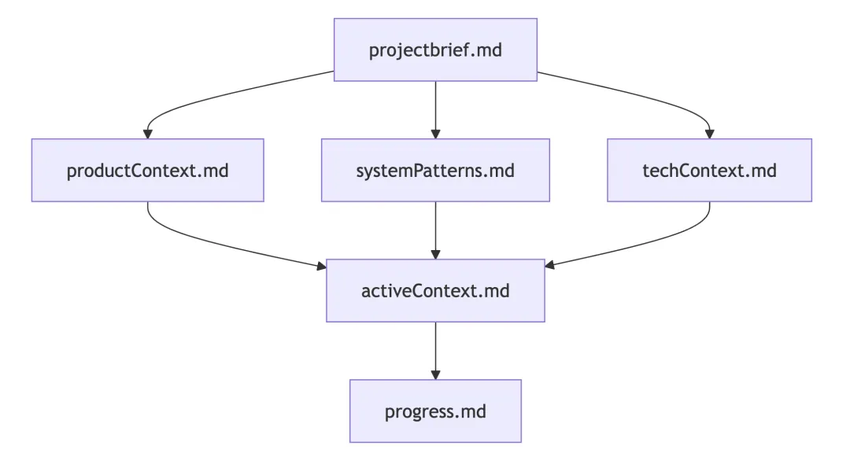

Cline的Memory Bank采用了精心设计的分层记忆架构,在项目目录下创建专门的memory-bank目录,通过六个核心文件实现项目知识的全方位管理:projectbrief.md作为项目基础文档,承载核心需求定义和目标规划;productContext.md深入阐述项目存在的根本原因、要解决的核心问题、具体工作方式以及用户体验目标;activeContext.md动态记录当前工作重点、最近变更内容、下一步执行计划和活跃的决策信息;systemPatterns.md详细描述系统架构设计、关键技术决策、采用的设计模式以及组件间的关系;techContext.md全面覆盖使用的技术栈、开发环境设置、技术约束条件和依赖关系管理;progress.md实时跟踪已完成的功能模块、待构建的内容清单、当前项目状态和已知问题记录。

各文件之间通过mermaid格式明确定义了层级从属关系,形成了有机的知识网络结构。

实现细节体现了良好的工程化设计理念:采用标准markdown文件格式确保可读性和可维护性,与版本控制系统深度集成;检索算法采用顺序读取、层级处理和依赖解析的策略,确保信息获取的准确性和完整性;通过MCP实现提供初始化、上下文更新、决策记录等核心工具支持。

2.5.1.3. Context7外部依赖文档管理

Context7专门处理外部依赖文档的管理和集成,为项目提供完整的外部知识支撑体系。

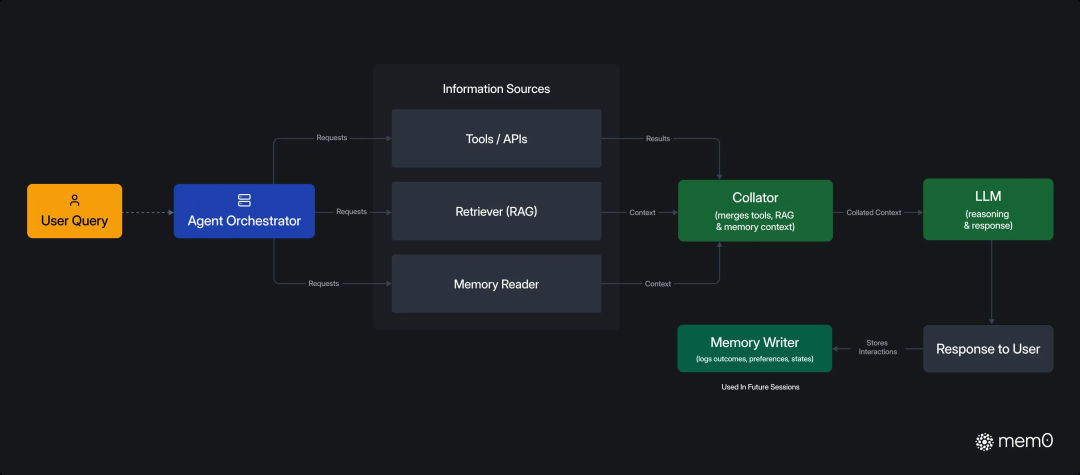

2.5.1.4. Mem0:现代AI代理的持久记忆层

多层记忆系统架构

Mem0作为专为现代AI代理设计的内存层,充当整个系统的持久记忆基础设施。其核心价值在于构建了完整的多层记忆系统:用户层记忆专注于记录个人偏好、工作习惯和历史决策模式;会话层记忆负责维护单次对话的完整上下文状态;智能体层记忆则储存系统级的专业知识和核心能力。

记忆提取机制通过摄入三个关键上下文源实现:最新交流内容、滚动摘要信息以及最近m条消息记录,并使用LLM从新对话中智能提取候选记忆片段。

记忆更新策略支持四种精确操作:ADD(新增记忆)、UPDATE(更新现有记忆)、DELETE(删除过时记忆)、NOOP(无操作维持现状),所有决策都基于向量相似度比较的LLM智能判断。

灵活的存储架构支持

系统在向量数据库支持方面展现出强大的适配能力:Qdrant作为开源默认选择,同时支持ChromaDB、Pinecone、Weaviate等多种主流向量数据库。更重要的是,采用了混合数据库架构设计,将向量存储、图数据库和键值存储有机结合,为不同类型的记忆信息提供最适合的存储和检索方式。

通过这些先进的记忆管理技术,AI系统能够建立起类似人类的长期记忆能力,为复杂的软件开发任务提供持续的知识积累和智能支撑。

2.5.2. 行业知识分层架构:构建面向业务的智能化知识体系

基于对业内先进方案的深入研究,我们设计了面向行业特定需求的研发知识分层架构。这种三层架构设计是基于知识类型的本质差异和应用场景的不同需求进行的分层。

2.5.2.1. 第一层:行业业务知识的深度积累

第一层专注于行业业务知识的全面覆盖,包括业务领域的基础概念理解和具体业务流程认知。例如,什么是服务供应链以及服务供应链的核心职能;服务供应链涵盖哪些具体业务领域,如家装、家电、3C、汽车等细分行业的业务特点和主要流程。

这些知识看似与编码工作没有直接关联,但在实际业务需求处理中发挥着关键作用。PRD文档中往往包含大量行业特定的业务术语,缺乏对这些概念的准确理解将直接影响大模型对产品交互逻辑的把握,最终导致生成代码的质量下降。

2.5.2.2. 第二层:前端技术视角的专业知识

第二层聚焦前端技术领域的专业知识积累,涵盖编码过程中的工作台研发指南,如ASCP、IDD、千牛等平台的开发规范;内部私有组件库的使用规范,如基于行业常见表单表格需求开发的onex-protable、onex-proform组件系统;外部开源组件的最佳实践,如AntDesign等通用组件库的规范化使用;以及研发基础规范和编码标准。

这一层的知识相对容易理解,属于传统技术栈的范畴。值得注意的是,集团终端架构组也在构建这一层的通用解决方案,未来可能会实现能力整合和协同发展。

2.5.2.3. 第三层:代码仓库与业务变更的融合知识

第三层将代码仓库信息与业务变更历史进行深度融合,这是我们行业知识库的独特优势,能够解决更多高阶复杂问题:

团队交接场景的痛点解决

在业务快速发展过程中,频繁的团队调整对接手老业务的开发者构成了重大挑战。虽然存在业务交接文档,但其粒度通常只到仓库地址和基本的项目信息层面。在实际开发过程中,这些老业务往往"到处都是坑",特别是经历多次转手的历史项目。

新接手的开发者面临两个核心困难:缺乏历史业务背景的完整了解,不清楚近年来的重大项目迭代和业务演进;历史代码中存在大量为满足产品需求而做出妥协的"不够优雅"的实现方式,这些技术债务的背景往往只有原作者知晓,导致接手者面对"屎山代码"时的困惑和挫败。

编码风格一致性的优化

第二个重要场景是解决AI生成代码与团队编码风格的一致性问题。即使AI已经获取了充足的编码知识和内部工具调用规范,生成的代码风格仍然可能与团队实际开发者的习惯存在差异。这些差异往往体现在难以通过知识枚举穷尽的编码细节上,比如前端表格单元格信息展示时选择使用 这些差异并非错误,而是在特定业务场景下行业内部形成的约定俗成的技术习惯。 全景式知识图谱的构建愿景 为了让AI更好地模仿行业开发者的工作方式,更深入地理解具体业务场景,我们希望将行业研发过程中的所有文档知识纳入AI的学习范围,形成一张完整的行业研发知识图谱。 这个知识图谱的覆盖范围包括需求阶段的PRD、MRD、视觉交互稿;研发阶段的前后端技术方案设计、接口对接文档、测试用例;以及需求交付阶段的交付文档和验收材料。通过这种全生命周期的知识整合,AI系统能够获得与人类开发者相当的业务理解深度和技术实现能力。 GraphRAG的技术突破与价值 Graph RAG(Graph Retrieval-Augmented Generation)作为传统RAG(Retrieval-Augmented Generation)的重要扩展形式,通过引入知识图谱(Knowledge Graph)技术显著增强了信息检索和生成的质量水平。 GraphRAG在索引阶段实现了知识提取技术的重要突破。通过有机结合层次化社区检测、LLM驱动的实体提取和高效存储架构,系统能够在微观细节和宏观结构两个维度深度理解文档内容。随着技术生态系统的持续发展,特别是成本优化变体的不断涌现,GraphRAG正在推动基于图的知识提取技术走向更广泛的应用普及。 差异化技术选型方案 代码检索:HNSW + SQLite组合架构 针对代码检索的特殊需求,我们采用了HNSW与SQLite的组合架构方案。代码检索场景具有独特的业务特征:数据规模方面,中型项目通常包含数万个代码块,大型项目更可达到数十万级别;更新频率极高,开发阶段代码变更频繁,要求索引系统具备快速更新能力;查询性能要求严格,需要毫秒级响应并支持精确匹配和相似度搜索的双重能力。 HNSW(Hierarchical Navigable Small World)算法在这一场景下展现出显著优势:查询性能达到O(log N)时间复杂度,显著优于传统向量数据库;采用全内存计算模式,彻底避免磁盘I/O瓶颈;算法经过专门优化,针对高维向量近邻搜索场景,在召回率和精度方面表现卓越;具备强大的扩展性,支持增量构建以适应代码库的动态变化需求。 SQLite FTS的集成带来了额外的技术优势:轻量高效的特性实现零部署成本和单文件存储;本地运行模式消除网络延迟,大幅提升查询响应速度;FTS5扩展提供企业级全文索引搜索能力;完善的事务支持确保元数据更新的原子性操作。 文档检索:Neo4j统一解决方案 文档检索场景呈现出不同的业务特征:关系复杂性突出,文档间存在丰富的引用和依赖关系;语义理解要求更高,需要深度语义理解和关联推理能力;查询模式更加多样化,图遍历和向量搜索需要并重处理。 Neo4j作为统一解决方案具备独特的集成优势:图向量融合能力,原生支持向量索引与图结构的联合查询操作;关系导航性能卓越,在多跳查询和路径分析场景下表现出色;语义扩展能力强大,基于图结构能够自然实现查询结果的语义扩展;一致性保证完备,确保向量数据和图数据的事务一致性。 文档检索的核心挑战在于理解和充分利用文档间的复杂关系网络。Neo4j作为成熟的图数据库,其原生的向量索引与图结构联合查询能力使得语义搜索和关系导航能够实现无缝结合。在处理多跳查询和路径分析任务时,Neo4j展现出卓越的性能表现,同时基于图结构的设计使得查询结果的语义扩展成为自然而然的功能特性。 混合架构的综合优势 这种差异化的混合架构设计带来了显著的综合优势:性能优化方面,通过针对性选择最适合的存储引擎,实现了代码查询延迟降低70%的显著效果;扩展性设计优秀,松耦合架构确保各组件可以独立进行扩展和优化;维护复杂度大幅降低,清晰的分层结构便于问题定位和性能调优工作;成本效益突出,充分利用成熟的开源组件,有效降低了基础设施投入成本。 这种混合架构的设计理念体现了"因材施教"的技术哲学——深入认识不同类型数据的独特需求特征,为每种场景选择最适合的技术解决方案。实践验证表明,这种策略带来了显著的投资回报:不仅实现了70%的代码查询延迟降低,系统的松耦合设计还确保了各组件的独立演进和优化能力。清晰的分层架构结构既便于故障定位和性能调优,也显著降低了长期维护成本。通过充分利用成熟的开源技术栈,我们在保证高性能的同时有效控制了基础设施投入,实现了性能与成本的最优平衡。 行业知识问答: 查询示例 输入: 输出: 这种深度的上下文理解和回答能力展现了GraphRAG知识图谱系统在实际业务场景中的强大应用价值。 质量保障体系的完整性思考 在前述的完整研发链路中,我们发现仍缺少一个至关重要的环节——代码质量保障。通常这个环节可以划分为代码质量测试和UI功能测试两个维度。 代码质量测试的现状与选择 在代码质量测试方面,我们在Agent内部集成了ESLint校验流程,能够保障基础的代码工程规范和异常检测。然而,我们并未实现AI Code Review功能。这个选择基于两方面考虑:首先,简单的AI Code Review技术壁垒不高,仅需结合行业代码规范通过Prompt就能实现,但效果提升有限,因为这些规范在Code Agent输出时已经内置,编码过程中基本不会出现违规问题; 相比代码质量测试,我认为UI功能测试能够带来更高的业务收益。 传统自动化测试框架高度依赖DOM元素选择器,这种架构存在多重结构性问题: Gemini通关《宝可梦蓝》的案例为我们提供了重要启示:AI正在获得类似人类的感知和行动能力。与之前VOYAGER等基于强化学习的模型不同,那些方案需要针对特定游戏进行长时间训练,且缺乏泛化通用性——训练玩《星际争霸》的AI无法直接应用于《王者荣耀》。而Gemini的突破在于未进行任何强化学习或针对性训练,直接使用通用大语言模型就实现了游戏通关。 这种能力迁移到UI测试领域具有革命性意义:AI可以像人类测试者一样通过视觉理解界面内容,而无需依赖脆弱的技术实现细节。 我们采用AI视觉优先(Vision-First)的技术路径,通过多模态大语言模型理解页面内容,实现更智能、更灵活的自动化测试体验。 视觉优先理解:系统使用AI分析页面截图进行内容理解,完全摆脱对DOM选择器的依赖,从根本上解决了传统方案的脆弱性问题。 自然语言驱动:测试用例可以使用自然语言描述执行步骤,大大降低了测试脚本编写的技术门槛,让业务人员也能参与测试用例的编写和维护。 智能降级机制:当视觉方法遇到问题时,系统能够自动降级到传统元素定位方式,确保测试执行的可靠性和覆盖面。 插件化架构设计:支持自定义策略和动作扩展,为不同业务场景提供灵活的适配能力。 全面测试报告:系统能够生成HTML、Markdown等多种格式的详细测试报告,便于结果分析和问题追踪。 视觉分析工作流程 通过这种多模态AI驱动的测试框架,我们不仅解决了传统自动化测试的技术痛点,更重要的是为整个研发链路的质量保障提供了更加智能和可靠的技术支撑。 真实的业务场景测试报告: AI友好的软件工程 我们与LLM之间的关系已经演进为深度协作模式:AI负责生成(Generation),人类负责验证(Verification)。这种分工体现了我一直提倡的简化、无状态理念,即避免过度复杂化的项目管理流程。 组织"AI Ready"的战略转型 拥抱变化与组织"AI Ready"的核心在于推动组织流程、功能、信息向AI开放。这不仅是技术层面的调整,更是组织和人员的深度变革。从时代终局思考的角度,未来工作的本质是更好地为AI准备信息和接口。 这一观点源于我们在研发Agent过程中的实践经验。几个月前在评估需求实现效果时,我们发现大部分行业表现符合预期,但个别领域效果差异较大,一次出码率仅能达到50%左右,远低于其他领域80%-90%的水平。 通过逐案例深入分析,我们发现个别行业的PRD与最终需求实现存在严重脱节。一种情况是PRD仅记录简单描述,但最终代码实现却是完整功能。经与前端开发同学沟通了解,这是因为国补需求时间紧迫,产品接到业务需求后未编写详细PRD,而是通过电话和线下方式直接传达给开发者。 另一种情况是PRD的描述与实际实现完全不符。这同样源于需求紧急,初始设计存在不合理之处,经过多次口头修改但未记录在文档中,导致最终上线代码与需求文档无法对应。 这种协同模式表面上提升了沟通效率,但在面向AI的软件开发时代实际上并未提升需求交付周期,且对项目管理和追溯带来隐患。如果PRD编写初期就考虑AI友好性——即表达清晰完整、内容描述准确,效果将截然不同。 这里涉及另一个重要话题:学会与AI沟通,掌握Prompt编写技能已成为这个时代的必备能力。写Prompt的能力可能比写代码更重要。有人担心这是传统编程技艺的丢失,但我的理解不同。这就像工人从手工拧螺丝转向操控数控机床——时代洪流不会停止,人的素养要求在变化和提升。 从前后端联调角度,核心问题是明确定义接口交付字段。理想情况下,后端编写联调接口文档,前后端据此进行业务代码开发。但实际研发过程中存在诸多协同问题: 文档信息不完备是常见问题,接口相关内容存在缺失,比如缺少接口返回response对象最外层Wrapper结构,导致前端调用出现空指针异常。接口定义频繁变更也带来挑战,后端从技术方案设计到最终实现过程中,经常出现内部逻辑或细节调整,可能源于技术方案考虑不周或产品需求变更。这些变更有时发生在联调过程中,甚至在发布前的CodeReview阶段,不仅存在安全隐患,也导致前端对接成本上升。 交付方式不规范同样值得关注。由于人员流动等因素,部分业务外包开发缺乏协同规范,经常将接口信息直接发送到钉钉群聊就认为完成交付,可能出于认为文档编写过于繁琐的考虑。 拥抱标准化技术至关重要,非必要情况下避免重复造轮子。面向人类的软件架构与面向AI设计的软件架构在底层就存在差异,私有化知识库构建和维护的成本过高。 文档编写策略需要根本性调整:不要手工维护文档,而是让LLM自动维护,通过Prompt将其自动化为流程的一部分。一些服务提供商已开始转型,将文档编写得更适合LLM理解。Vercel和Stripe是较早尝试的企业,它们将文档用Markdown格式编写,这种格式对LLM来说极其易于理解。 传统的技术文档(面向“人类”开发者) https://midwayjs.org/docs/intro AI时代的文档(面向LLM) https://vercel.com/docs/llms.txt https://docs.anthropic.com/en/docs/claude-code/slash-commands 在问题排查和调试领域,AI同样具有巨大潜力。以JVM内存泄漏导致频繁Full GC的问题为例,传统方式需要掌握各种工具、指令和内存参数调整技巧。虽然JVM内存模型等理论知识可以学习,但在实际问题排查时,通过AI辅助的MCP服务器等工具能够大大降低技术门槛。 这个领域有大量场景值得挖掘。我希望大家能够开拓视野,不要局限于报表数据分析、智能问答助手等常见应用。如果业务确实需要这些功能那无可厚非,但如果希望通过技术驱动方式用AI带来真正价值,需要在更深层次的技术场景中寻找突破点。 AI驱动的研发范式变革 AI Coding的本质重新定义 AI Coding的核心价值并非简单的代码生成,而是帮助我们实现代码的模块化、组件化、工程化和持续可维护化。它改变了传统的"闷头开发,事后返工"模式,通过智能化手段在开发初期就建立起规范化的工程实践。这种专业生产力工具的颠覆式创新,必然会全面重塑开发者的认知框架和工作方式。 人才模型左移的时代必然 人才模型的左移已经势在必行。正如手工拧螺丝永远无法与流水线机床竞争一样,传统的开发模式面临着根本性的挑战。几个月前,阿里研究院专门负责政府报告的同事和我重点探讨AI时代对社会传统职能的冲击影响。 率先完成AI研发升级的企业必然会对反应迟缓的企业形成降维打击,这与自动化流水线出现后不愿转型的手工作坊迅速被淘汰的历史规律如出一辙。 从业务价值角度来看,传统的前端性能优化虽然能够带来20%的提升效果,但从100毫秒优化到80毫秒对业务运营和用户感知的影响实际上非常有限。相比之下,将原本排期3天以内的需求实现立即交付,3天以上的需求交付时间缩短一半,这种效率提升对业务的感知极为强烈。在当前竞争激烈的电商环境中,产品迭代速度的提升能够直接帮助企业实现"业务先赢"的战略目标。 AI时代的核心能力重构 未来的差异化竞争更多体现在认知层面。在AI时代,判断力比纯技术能力更加重要。具备强大AI Sense的开发者能够通过智能化工具实现传统研发人员3-5倍甚至更高的人力产出效果。 组织变革的深层思考 这种转变必然涉及招聘策略、人才模型以及企业研发协同流程的深度改革,我认为这种变革不仅必要,而且紧迫。未来新招聘的开发者直接编写业务代码的场景将大幅减少,更多时候需要思考如何通过AI帮助业务获取增量价值或带来效率提升。 Vibe Coding的双重路径 Vibe Coding正在沿着两条清晰的路线发展:第一条是岗位融合路线,产品、设计、开发、运维的边界日趋模糊,基于统一上下文完成复合型任务;第二条是全栈自动化路线,实现具备完整后端功能的产品自动生成。 研发模式的根本性转变 未来的IDE很可能不再是当前"以代码为中心"的形态。我认为未来的研发模式将演进为以需求为中心的全栈一体化形态,前端、后端、测试将在同一条AI Native的研发链路中实现深度融合。 以Trae SOLO和Kiro SPEC模式为代表的外部产品与我们的设计理念不谋而合,这表明行业已经普遍意识到单纯的编码辅助工具存在效果上限。虽然集团内多个BU都在构建类似的研发工具,但追求统一化平台解决方案的路径我认为并不现实。正确的方向应该是从行业需求视角出发,倒推如何帮助业务实现更快的落地和迭代。 Anthropic联合创始人Benjamin Mann在最近的科技播客中提出了一个重要观点:大模型AI远未进入技术瓶颈期,以当前AI能力水平去评估未来技术方案存在固有局限性。 这提醒我们不应被当前技术局限所束缚,而应保持开放的架构设计,为未来能力跃升预留扩展空间。在这个快速变化的技术环境中,持续探索和创新比追求短期完美解决方案更为重要。 AI Coding这条充满挑战的道路,我们仍在持续摸索前行。相比行业的众多先行者,我们深知还有许多需要学习和完善的技术领域。但请相信,我们正以最严谨的态度全力投入这项具有深远历史意义的技术变革。每一次实践探索,每一个技术设想,都在为这个时代的研发变革贡献着自己的力量。

2.5.3. GraphRAG知识图谱:图结构增强的智能检索系统

2.5.4. 实际应用效果展示

用户查询: "这段代码Xxxxxxxxx为什么要添加缓存?" ↓1. 代码上下文定位 └─> 找到相关文件和函数 ↓2. 向量检索(多路召回) ├─> 上下文构建层→ 理解模块功能和业务流程 ├─> 变更记录 → 获取需求和技术决策 └─> 代码函数 ←→ 业务流程(通过语义匹配) ↓3. 结果融合与重排序 └─> 综合评分,返回最相关的变更记录和文档 ↓4. LLM生成答案 └─> 基于召回的上下文,解释变更原因和需求背景

code: "await redis.set(token, userData, "EX", 3600)"question: "为什么要设置1小时过期时间?"

这个1小时的过期时间是基于以下考虑:1. 需求背景(来自PRD v2.3): - 移动端用户反馈频繁需要重新登录 - 产品要求在安全性和便利性间平衡2. 技术决策(来自技术方案): - 1小时满足安全审计要求 - 避免Redis内存压力(日活100万用户) - 配合refresh token实现无感续期3. 相关变更: - 2024-03-15: 从30分钟延长到1小时 - 关联需求: MOB-2024-Q1-UX

▐ 2.6. AI驱动的多模态自动化UI测试:重构测试范式

2.6.1. 传统自动化测试的固有局限

2.6.2. AI多模态理解的突破性价值

2.6.3. Vision-First自动化测试框架

3.1.1. 基于文档的标准化交付流程

3.1.2. 标准化的API对接

3.1.3. 标准化技术和组件

3.1.4. AI时代的文档(知识库)

3.1.5. AI时代的问题排查和调试