Manus 的热度暂时降了下来,我申请的邀请码也到了,于是开始了第一次 Manus AI Agent 的使用。这应该是正儿八经的第一次使用这类 Agent AI 产品,当然之前有看过 Devin AI 的 demo,也一直在使用 Cursor,但这些 agent 基本上都是 coding 领域的。Manus 官方说自己是通用的 AI agent 产品,那具体的边界还得探索了才知道。

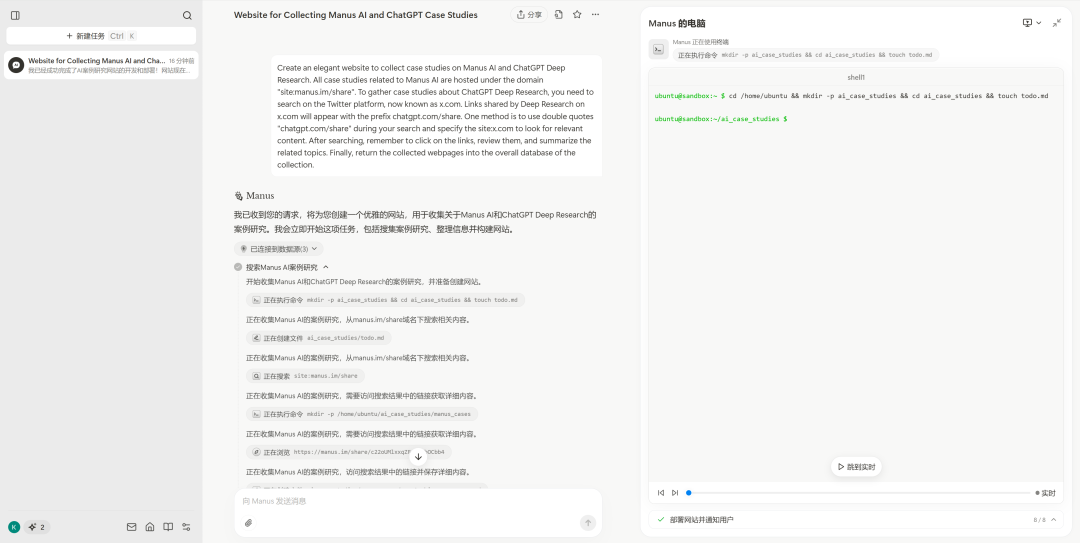

整个产品的完成度很高,可以看见 Manus 的产品经理在一开始就做了一些设计。而最主要的设计就是要让整个 Agent 工作的过程让所有人能够看见。浏览了什么网页,执行了什么命令,发生了什么错误,以及如何解决的。整个工作流的步骤是非常清晰的,同时右侧叫“Manus 的电脑”,可以看见 Agent 在虚拟机里进行的操作,网站可以在虚拟机里打开,也可以在自己使用的电脑上点开新的标签。

为什么这么做?那就要聊到关于 AI 应用的体验了。DeepSeek R1 作为推理模型,发布时的爆火程度远大于 OpenAI 的 O1,一个原因就是团队将模型思考的过程展现给了用户。模型的整个思维链,中间的思考,时不时的 aha moment,都让模型推理的过程更加具象化。正是这种具象化,和传统 Chatbot 的一问一答产生了巨大的体验差异。

而 Manus 也同样希望将 AI 应用的体验做出差异化,所以展现了整个 agent 思考和执行的过程,甚至保留的完整流程的视频,保证整个过程可以被传播,并让没有使用到产品的人同样体验产品的整个过程。同时下方还有进度条,类似你可以随意调到 Agent 思考和执行的任意切片时间。

产品体验是一方面,当然也有不好的点,那就是和我之前的预想是差不多的。任务的执行成功率显然不是很高。对于我的第一个任务,可以说就是失败的。尽管整个执行的路径没有错,我的需求是希望能够收集一些相关网站,然后用一个网页展示出来。但是很可惜,一开始他就理解错了我的一个需求。

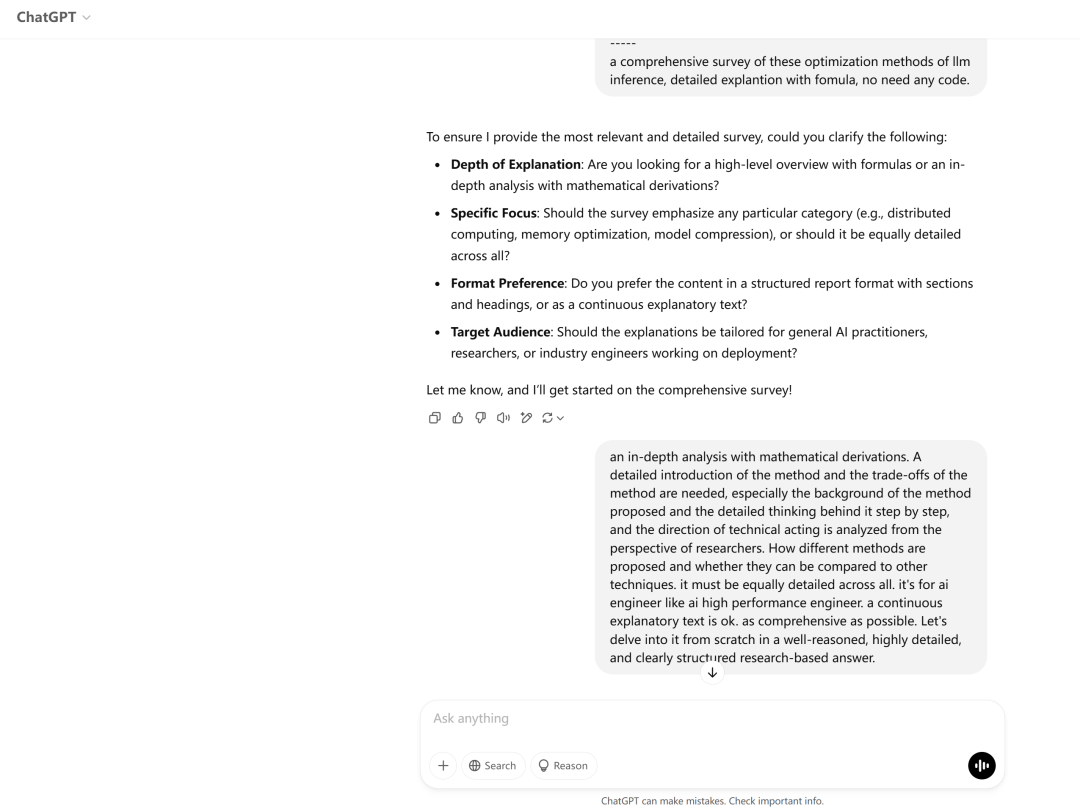

Manus 不像 ChatGPT 的 Deep Research 一样,一开始当我提出我的要求的时候,ChatGPT DR 会进行反问,目的对要求进行更加详细和准确的梳理。

而 Manus 当我输入完指令,按下回车之后,就开始直接干活了。那么到底有没有理解我的需求?是否对我的任务目标和我达成一致?所以最后发现,一开始的时候,有一个需求就理解错了,导致运行到一半,我就对整个任务的成功不报希望了。

当然,让 Agent 一收到命令就开始干活,是为了真正解放人类的双手。毕竟一开始对话框就提示了在 agent 干活的时候,用户是可以离开的。但是我还是认为之后类似的产品,还是应该提供 step by step 的选项,基于每一步的结果,用户可以做一些相关补充,或者关于进行结果进行选择和丢弃。模型的长链条推理是整个使用过程中主要的成本所在,如果能够及时停止错误,不仅能够提高用户体验,还能极大降低产品成本。

不然对于 AI Agent 来说,很容易进入“一步错,步步错”的情景。这种情况很可能来源于大语言模型的幻觉,就像有时大语言模型的重复吐字,又或者是 DeepSeek R1 当说到什么量子力学、黑暗森林法则的时候就开始放飞自我了。

至于任务的执行的时间,当然是会因任务而异,但这个其实最不需要担心。毕竟随着技术的发展,有关速度的体验肯定是会有提升的。

最近应该是放开了审核,用我自己写的 prompt 邀请码审核很快就通过了。

发表评论 取消回复