编辑:KingHZ 定慧

【新智元导读】最强具身大脑,宝座易主!在10项评测中,国产RoboBrain 2.0全面超越GPT-4o。这次,智源研究院开源了具身大脑RoboBrain 2.0 32B版本以及跨本体大小脑协同框架RoboOS 2.0单机版。不仅问鼎评测基准SOTA,还成功刷新跨本体多机协作技术范式!

近日,智源研究院发布具身大脑RoboBrain 2.0 32B版本以及跨本体大小脑协同框架RoboOS 2.0单机版。

RoboBrain 2.0,作为集感知、推理与规划于一体面向真实物理环境的「通用具身大脑」,32B版本凭借时空认知能力的突破,在多项权威具身智能基准上全面刷新纪录,此前发布的7B版本,具备紧凑高效的模型结构,其轻量化设计完美适配边缘设备部署需求,能在低资源环境下稳定运行,同时相比主流的开闭源模型性能依旧强劲。

RoboOS 2.0作为全球首个具身智能SaaS开源框架,创新性集成MCP协议与无服务器架构,实现轻量化部署,打通智能大脑与异构本体协同通路。

同步推出单机版产品线及RoboSkill技能商店,通过深度集成实现机器人技能模块智能匹配与一键适配功能,标准化接口有效消除厂商与硬件适配流程差异。

同步推出开箱即用镜像,支持「三行指令」极速部署,全面赋能开发者高效构建智能机器人系统。

具身大脑与跨本体大小脑协同框架双擎联动,将有效推动机器人从「单机智能」迈向「群体智能」,加速具身智能技术从实验室走向真实场景,形成开放、高效、智能协同的具身智能生态体系。

RoboBrain 2.0突破三大能力瓶颈

当前主流AI模型在应对真实物理环境时,普遍存在三大核心瓶颈:空间理解精度不足、时间依赖建模薄弱、长链推理能力欠缺。

RoboBrain 2.0则在这三大关键能力上实现全面突破,显著提升了对复杂具身任务的理解与执行能力。

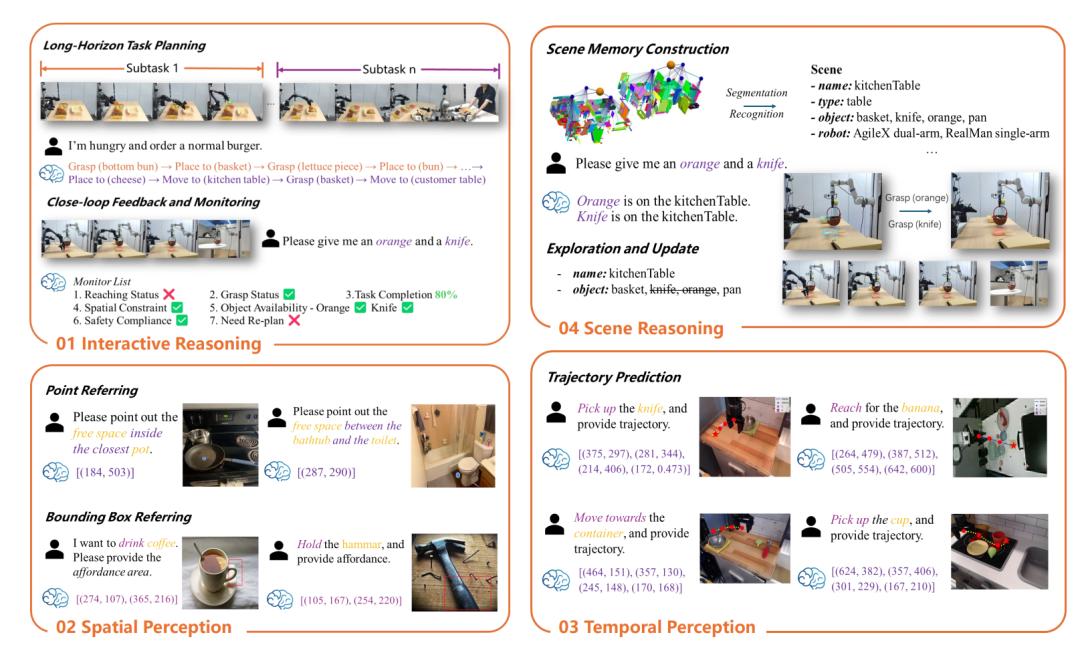

- 空间理解:

- 精确点定位和边界框预测:能够根据复杂指令在图像中定位物体或区域。

- 空间关系理解:理解物体之间的相对位置和方向。

- 空间推理:支持基于场景图的实时构建和更新,进行复杂的三维空间推理。

- 时间建模:

- 长期规划:能够进行多步任务规划,支持长期目标的实现。

- 闭环交互:支持基于反馈的动态调整,适应动态环境。

- 多智能体协作:能够协调多个智能体的行为,完成复杂任务。

- 长链推理:

- 链式推理:能够进行多步推理,支持复杂任务的逐步解决。

- 因果逻辑:能够从复杂指令中提取因果逻辑,并与环境状态对齐。

- 决策透明性:能够生成推理过程的详细解释,支持决策的透明性和可解释性。

RoboBrain能力概览图

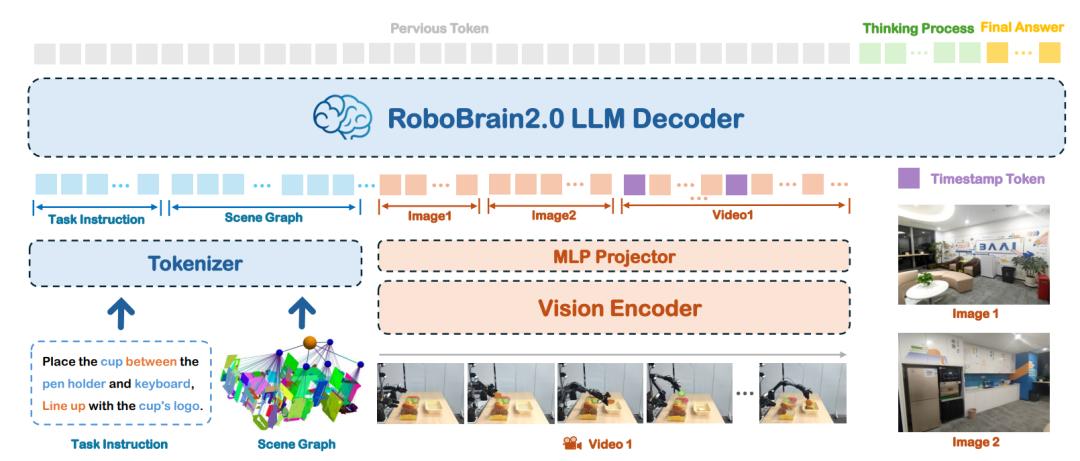

RoboBrain 2.0采用模块化的编码器-解码器架构,为复杂的具身任务实现了感知、推理和规划的统一。

与专注于通用静态视觉问答(VQA)的传统视觉-语言模型(VLMs)不同,RoboBrain 2.0在保持强大通用VQA能力的同时,专门针对具身推理任务,如空间感知、时间建模和长链因果推理。

该架构将高分辨率图像、多视图输入、视频帧、语言指令和场景图编码为统一的多模态标记序列,以进行全面处理。

RoboBrain 2.0模型架构图

RoboBrain 2.0刷新性能基准

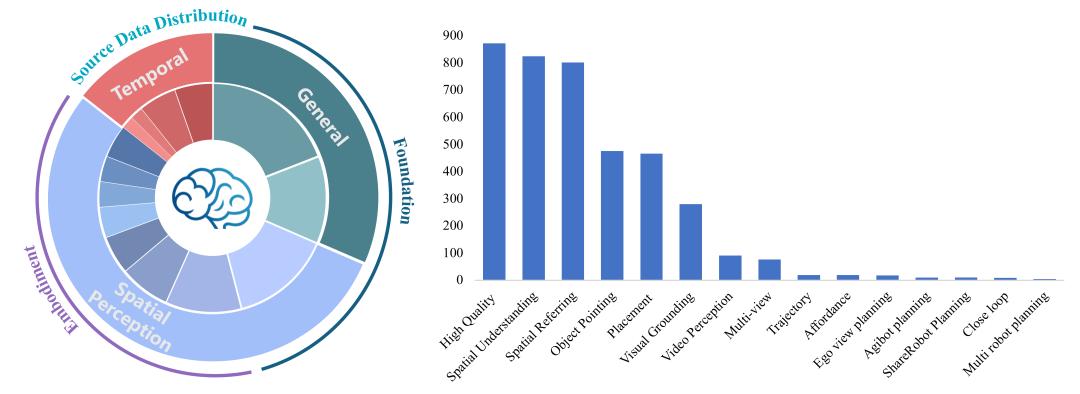

RoboBrain 2.0依托全面且多样化的多模态数据集,融合高分辨率图像、多视角视频序列、场景图、3D场景数据及复杂自然语言指令,全面赋能机器人在具身环境中的感知、推理与行动能力。

该多模态数据集聚焦三大核心领域,为复杂物理场景提供有力支持。

- 通用多模态理解:整合标准视觉问答、区域级查询、OCR视觉问答及多轮视觉对话,优化语言表达的多样性与语义一致性,通过丰富的视觉-语言交互数据,提升模型对复杂任务的理解与响应能力,适应从简单问答到多轮对话的多样场景。

- 空间感知:支持高精度物体定位、边界框预测及对象功能性识别,覆盖室内外复杂视觉场景与3D空间推理,助力机器人精准解析物体关系、空间属性及场景上下文,应对遮挡、多视角变化等挑战,满足高精度定位与交互需求。

- 时间建模:通过多模态数据支持长程任务规划、闭环反馈机制及多智能体协作,强化模型在动态环境中的任务分解、动作序列预测及实时交互能力,确保在复杂物理场景中实现连续决策、灵活协作与高效任务执行。RoboBrain 2.0以卓越的多模态感知、精细的空间推理及强大的长时规划能力,赋能机器人在具身环境中进行交互推理、多智能体协作及高效任务规划,助力复杂物理场景的智能感知与决策。

RoboBrain 2.0训练数据集

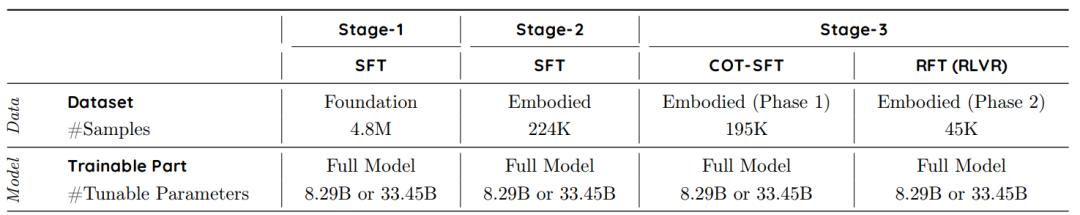

RoboBrain 2.0采用三阶段递进式训练流程。

- 第一阶段:基础时空学习(Foundational Spatiotemporal Learning)

在第一阶段,RoboBrain 2.0专注于构建其在空间感知和时间理解方面的基础能力。模型通过大规模多模态数据集进行训练,这些数据集涵盖了密集标注的图文数据、视频问答以及指代表达理解任务。通过这一阶段的训练,模型能够处理静态图像和视频流,掌握物体的基本空间关系和运动事件,为后续更复杂的任务奠定了坚实的基础。

- 第二阶段:具身时空增强(Embodied Spatiotemporal Enhancement)

在第二阶段,RoboBrain 2.0通过引入高分辨率多视图图像、第一人称视频数据以及导航和交互任务,进一步增强其在具身任务中的时空建模能力。模型学习处理长序列的时空信息,支持多智能体协调、长期规划和动态环境中的适应性决策。这一阶段的训练使模型能够更好地将历史视觉信息与当前指令相结合,从而在动态交互环境中实现更连贯的长期规划和稳健的场景理解。

- 第三阶段:具身情境中的推理链训练(Chain-of-Thought Reasoning in Embodied Contexts)

在第三阶段,RoboBrain 2.0通过监督微调和强化微调,进一步提升其在复杂具身任务中的推理能力。模型使用多轮推理示例进行训练,这些示例涵盖了长期任务规划、操作预测、闭环交互、时空理解以及多机器人协作等任务。通过这一阶段的训练,模型能够生成推理链,支持复杂任务的逐步推理和决策,从而在具身情境中实现更高效、更准确的推理和规划能力。

RoboBrain 2.0采用FlagEvalMM框架,全面验证空间与时间推理能力。

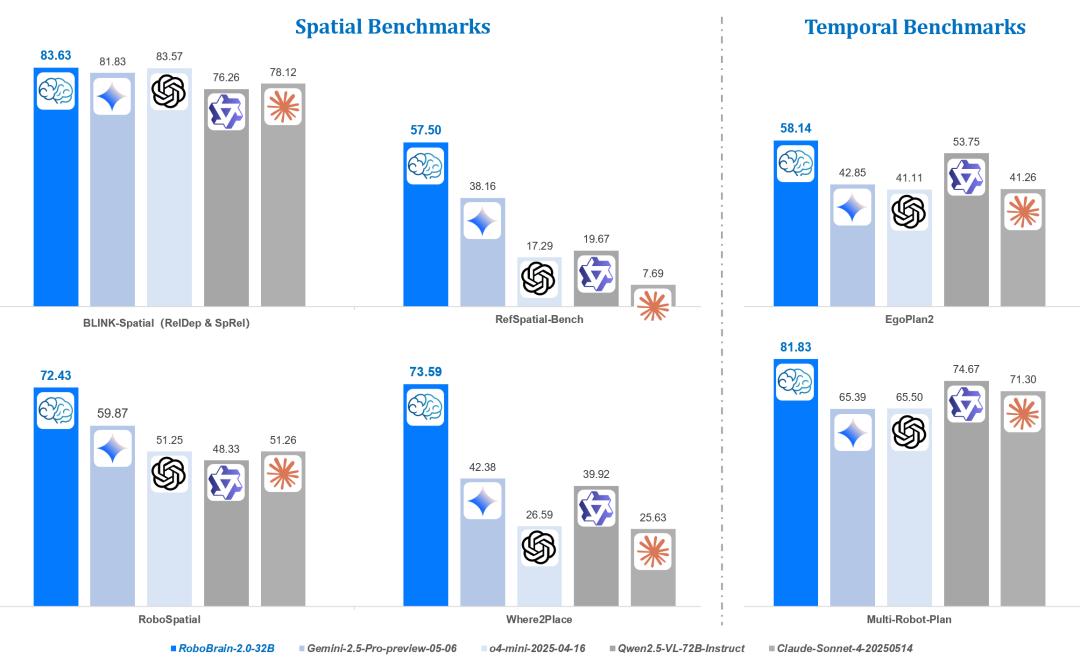

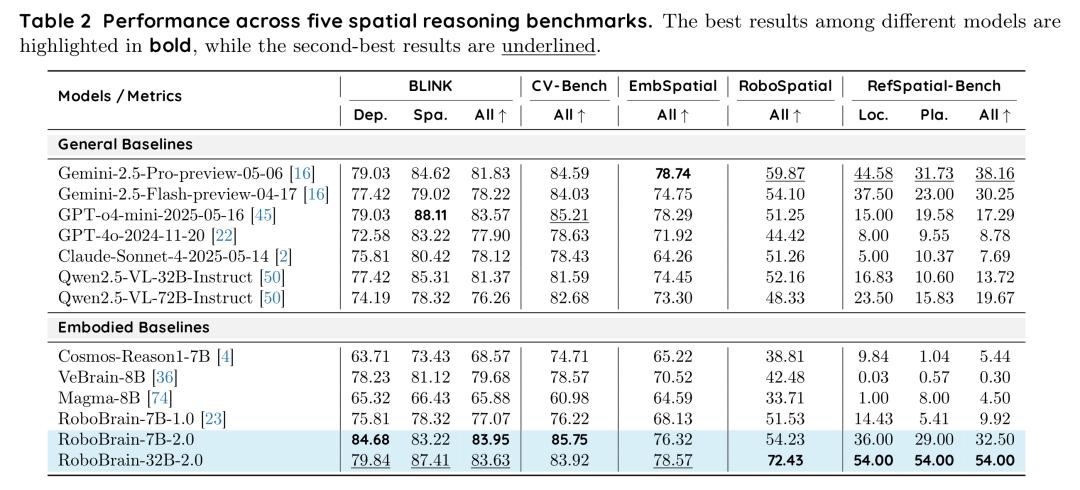

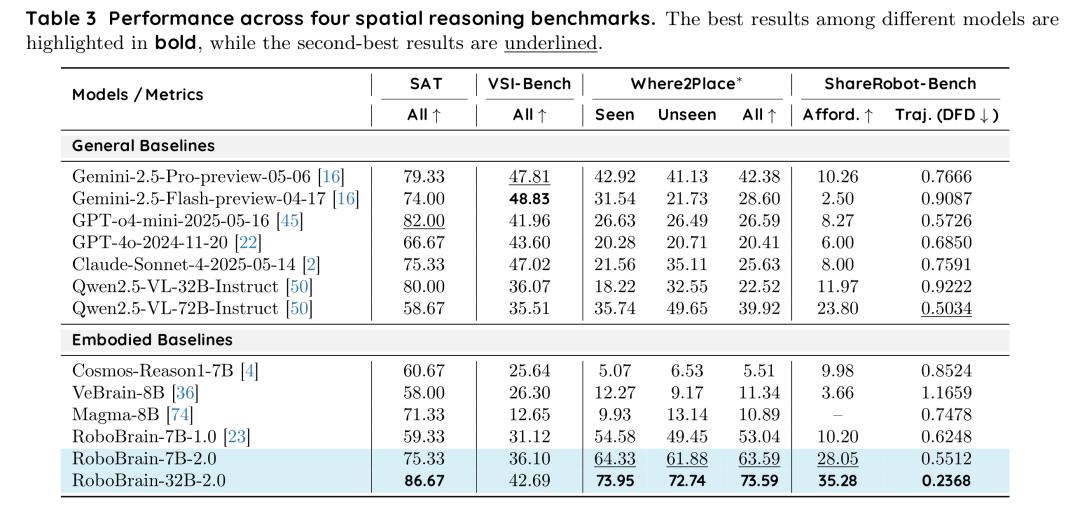

- 空间推理:在BLINK(83.95)、CV-Bench(85.75)、Where2Place(73.59)等9项基准测试中,RoboBrain-32B/7B-2.0屡获SOTA,精准实现物体定位、边界框预测及空间参照,超越Gemini、GPT-4o等基线。

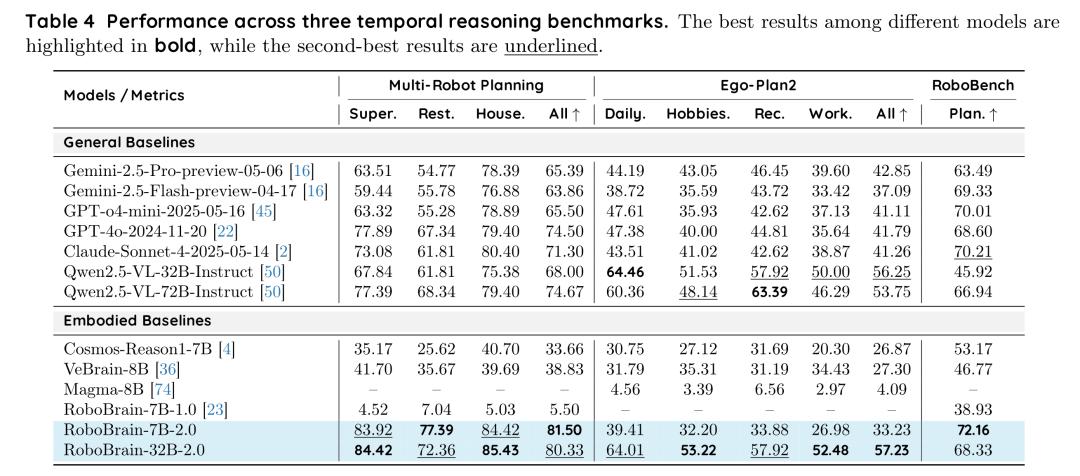

- 时间推理:在多机器人规划(80.33)、Ego-Plan2(57.23)、RoboBench(72.16)中,展现卓越长程规划、闭环反馈及多智能体协作能力,领跑Qwen2.5-VL、Claude等模型。

RoboBrain 2.0-32B在BLINK-Spatial、RoboSpatial、RefSpatial-Bench、Where2Place、EgoPlan2和Multi-Robot-Plan等空间与时间推理基准上均取得最佳表现

RoboBrain 2.0 7B模型分别以83.95分和85.75分登顶BLINK和CV-Bench基准测试。RoboBrain 2.0 32B模型在RoboSpatial、RefSpatial-Bench以及SAT、Where2Place和ShareRobot-Bench上实现SOTA突破

RoboBrain 2.0 7B模型在Multi-Robot Planning以81.50分拔得头筹;RoboBrain 2.0 32B以 80.33分紧随其后;RoboBrain 2.0 32B在Ego-Plan2(57.23分)登顶,大幅领先GPT-4o等基线;RoboBrain 2.0 7B模型则在RoboBench以72.16分夺魁,双模型凭借优异表现刷新性能上限

RoboBrain 2.0与RoboOS 2.0双引擎

实现具身群体智能

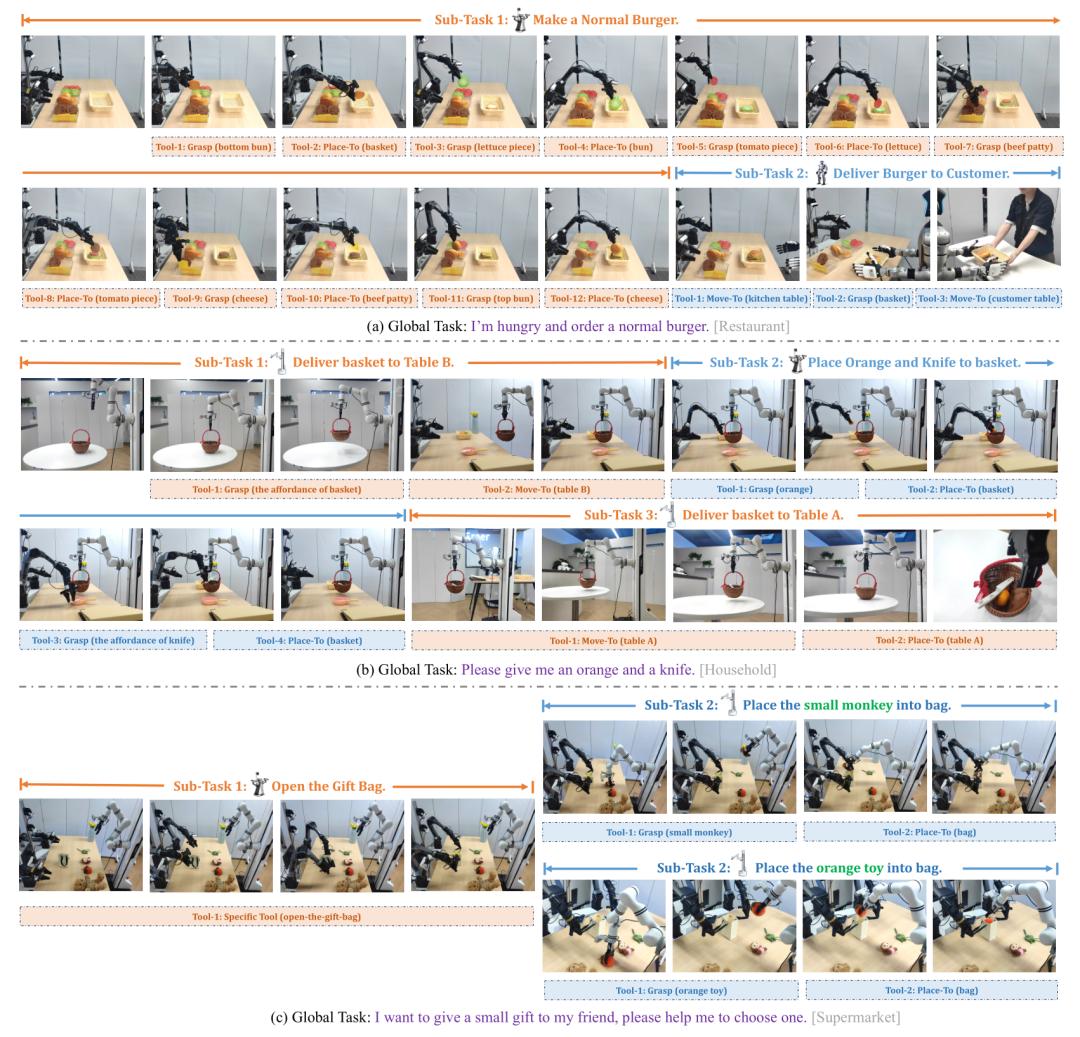

依托跨本体大小脑协作框架RoboOS 2.0的多本体规划能力,RoboBrain 2.0已实现多智能体间协作执行任务,支持商超厨房居家等多场景部署。

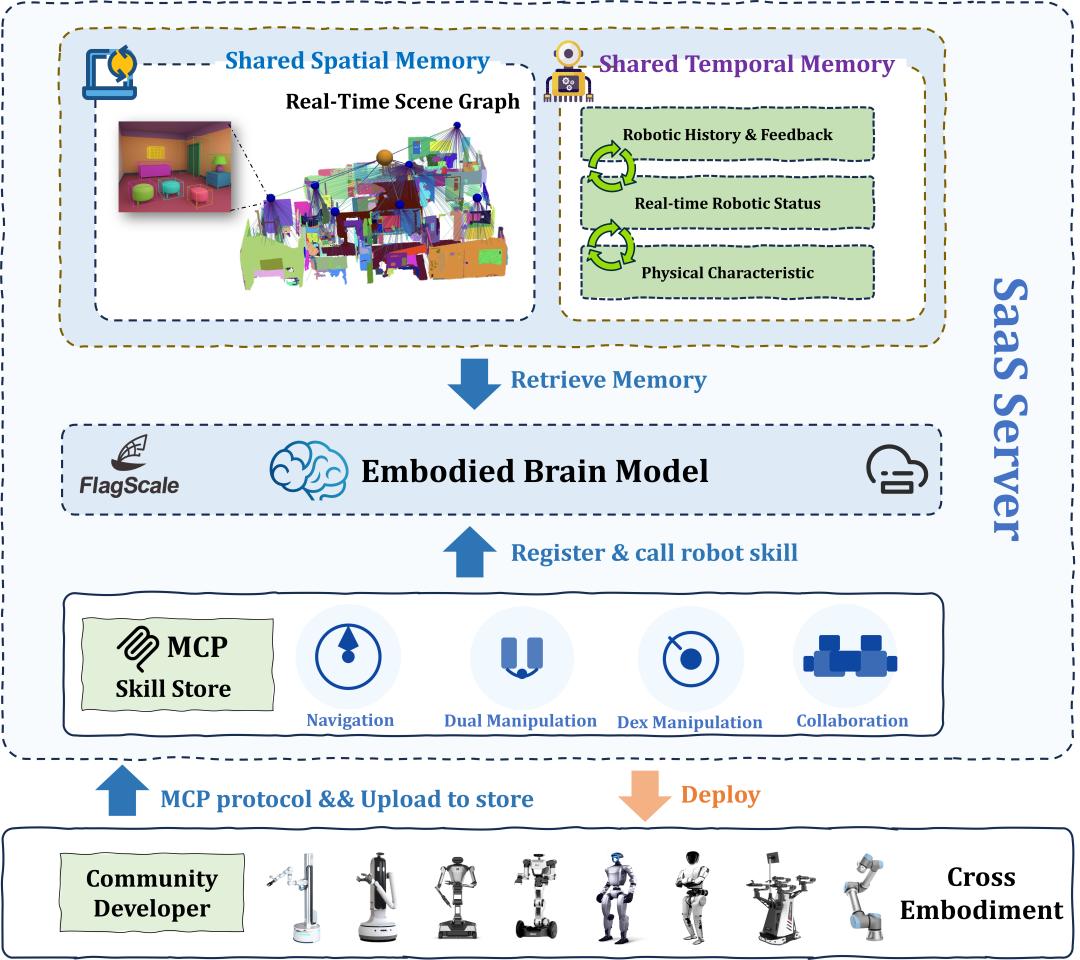

跨本体具身大小脑协作框架RoboOS 2.0是全球首个基于具身智能SaaS平台、支持无服务器一站式轻量化机器人本体部署的开源框架。同时,RoboOS 2.0也是全球首个支持MCP的跨本体具身大小脑协作框架,旨在构建具身智能领域的「应用商店」生态。

RoboOS 2.0实现了大脑云端优化推理部署与小脑技能的免适配注册机制,显著降低开发门槛,典型场景下,相关代码量仅为传统手动注册方式的1/10。

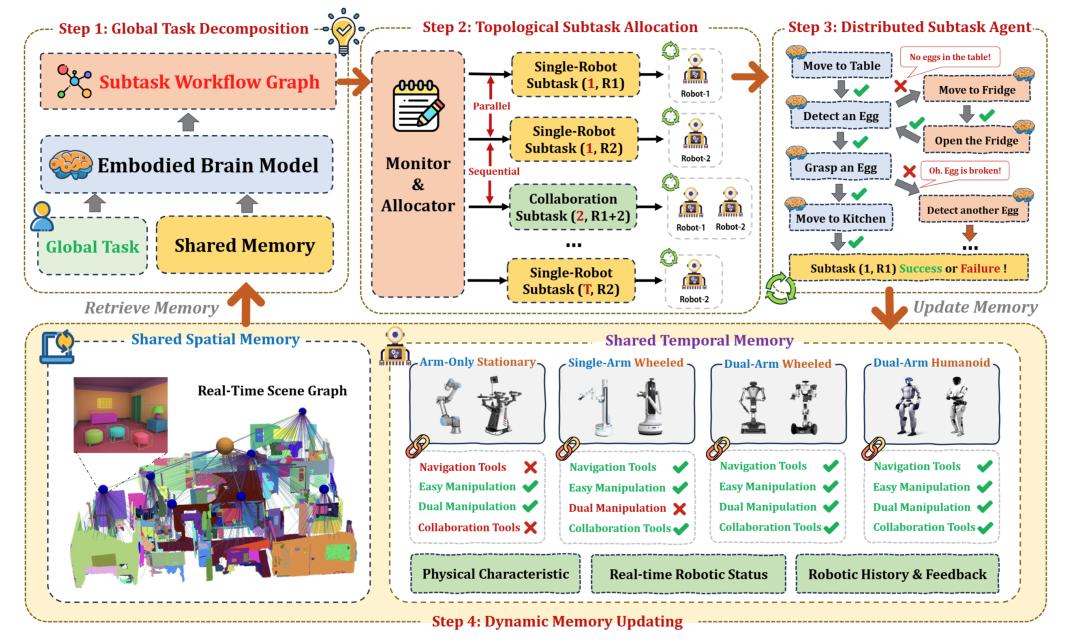

RoboOS 2.0框架(SaaS+MCP模式)。RoboOS是面向多机器人协作的「大脑-小脑」分层系统,包含三大核心组件:(a)基于云计算的具身大脑模型,负责高级认知与多智能体协同;(b)分布式小脑模块群,专司机器人专项技能执行;(c)实时共享内存机制,强化环境态势感知能力

相较于1.0,RoboOS 2.0对端到端推理链路进行了系统级优化,整体性能提升达30%,全链路平均响应时延低至3ms以下,端云通信效率提升27倍。在功能层面,新增了多本体时空记忆场景图(Scene Graph)共享机制,支持动态环境下的实时感知与建模;同时引入多粒度任务监控模块,实现任务闭环反馈,有效提升机器人任务执行的稳定性与成功率。

RoboOS多机协作实现流程包含四个关键阶段:首先通过分层任务分解将复杂任务逐级拆解,随后基于网络拓扑结构进行子任务动态分配,再由分布式智能体集群并行执行各子任务,最后通过实时共享内存机制动态更新环境状态与任务进度

基于RoboOS 2.0协作框架,可充分发挥RoboBrain 2.0强大的空间理解、时序规划与闭环推理能力的同时,一键下载并部署来自全球开发者创建的相同型号机器人本体的小脑技能,完成大小脑的全链路无缝整合。

RoboBrain 2.0可通过像素级空间理解,支持下游小脑模型高精度抓取、搬运、放置等操作,同时,根据实时感知任务执行状态调整执行计划,适应动态环境变化,实现闭环反馈机制。

RoboBrain 2.0与RoboOS 2.0全面开源

共建具身智能生态圈

目前,RoboBrain 2.0及RoboOS 2.0已全面开源,模型权重、训练代码与评测基准全部可用。

RoboBrain 2.0:

- Page:https://superrobobrain.github.io

- GitHub:https://github.com/FlagOpen/RoboBrain2.0

- ArXiv:https://arxiv.org/abs/2507.02029

- Checkpoint-7B:https://huggingface.co/BAAI/RoboBrain2.0-7B

- Checkpoint-32B:https://huggingface.co/BAAI/RoboBrain2.0-32B

- RoboBrain2.0的FlagRelease多芯片镜像:

- https://huggingface.co/FlagRelease/RoboBrain2.0-7B-FlagOS

- https://huggingface.co/FlagRelease/RoboBrain2.0-32B-FlagOS

- https://huggingface.co/FlagRelease/RoboBrain2.0-7B-FlagOS-Ascend

RoboOS 2.0:

- Page:https://flagopen.github.io/RoboOS

- GitHub:https://github.com/FlagOpen/RoboOS

- GitHub单机轻量版:https://github.com/FlagOpen/RoboOS/tree/stand-alone

- GitHub技能商店:https://github.com/FlagOpen/RoboSkill

- ArXiv:https://arxiv.org/abs/2505.03673

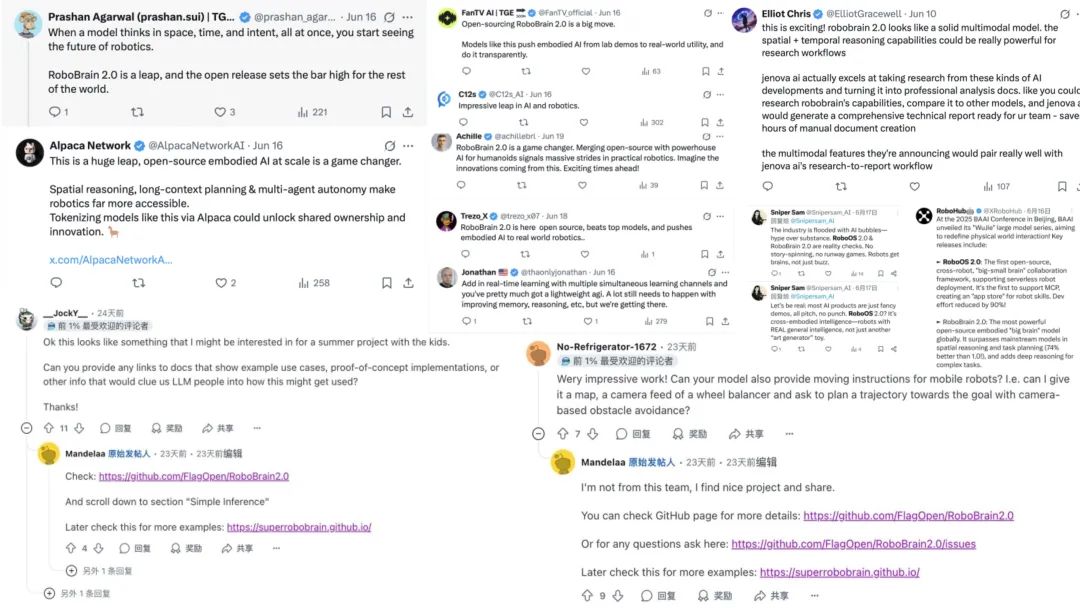

RoboBrain 2.0及RoboOS 2.0一经开源,便在全球社交媒体和技术社区引发广泛热议。

目前,智源研究院已与全球20余家机器人企业与顶尖实验室建立战略合作关系,诚邀全球开发者、研究者与产业伙伴加入RoboBrain 2.0和RoboOS 2.0的开源社区,共筑开放繁荣的具身智能生态。

参考资料:

https://superrobobrain.github.io/