本地部署大语言模型并非易事,它涉及到复杂的模型管理、知识库搭建以及系统集成等技术挑战。本文将为你提供一份详细的“小白教程”,手把手教你如何在本地环境中部署Dify开源平台,并结合本地RAG知识库,打造属于你自己的智能体工作流。

要实现本地部署跑通大模型+本地知识库搭建的本地智能体(工作流)

需要三部分

第一部分:本地部署大语言模型(上面第一个原创文章中以部署deepseekR1-7b为例)

第二部分:部署dify开源平台,这部分需要安装docker启动

第三部分:dify开源平台+Embedding模型

今天这部分主要是第三部分

开始正文

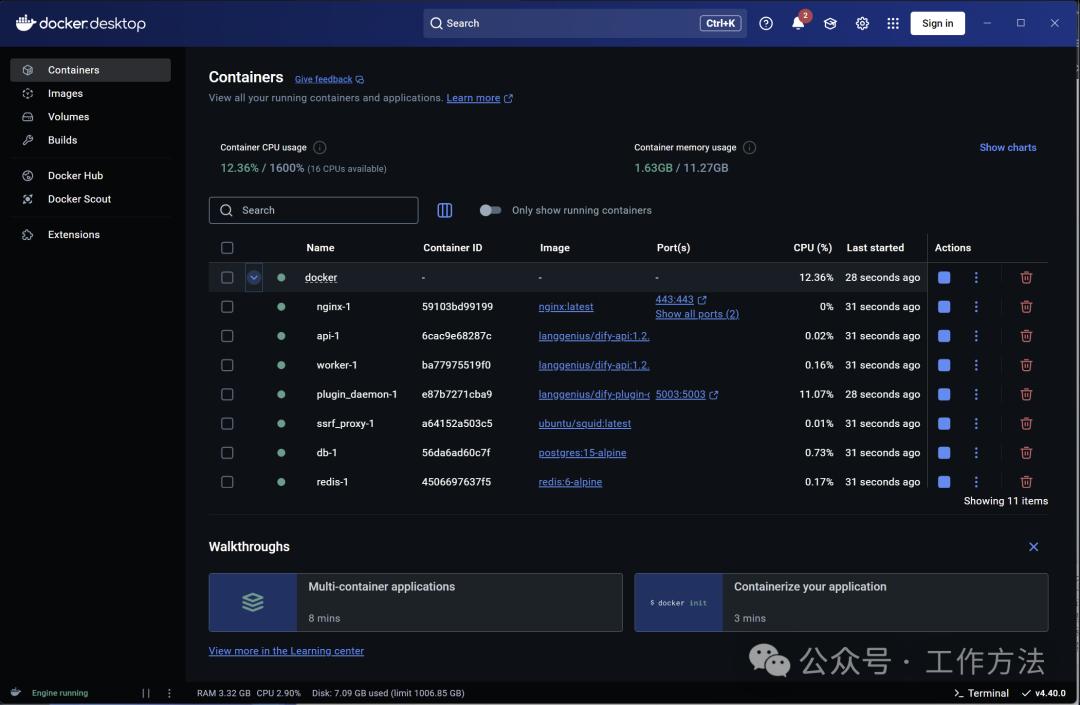

启动ollama、docker

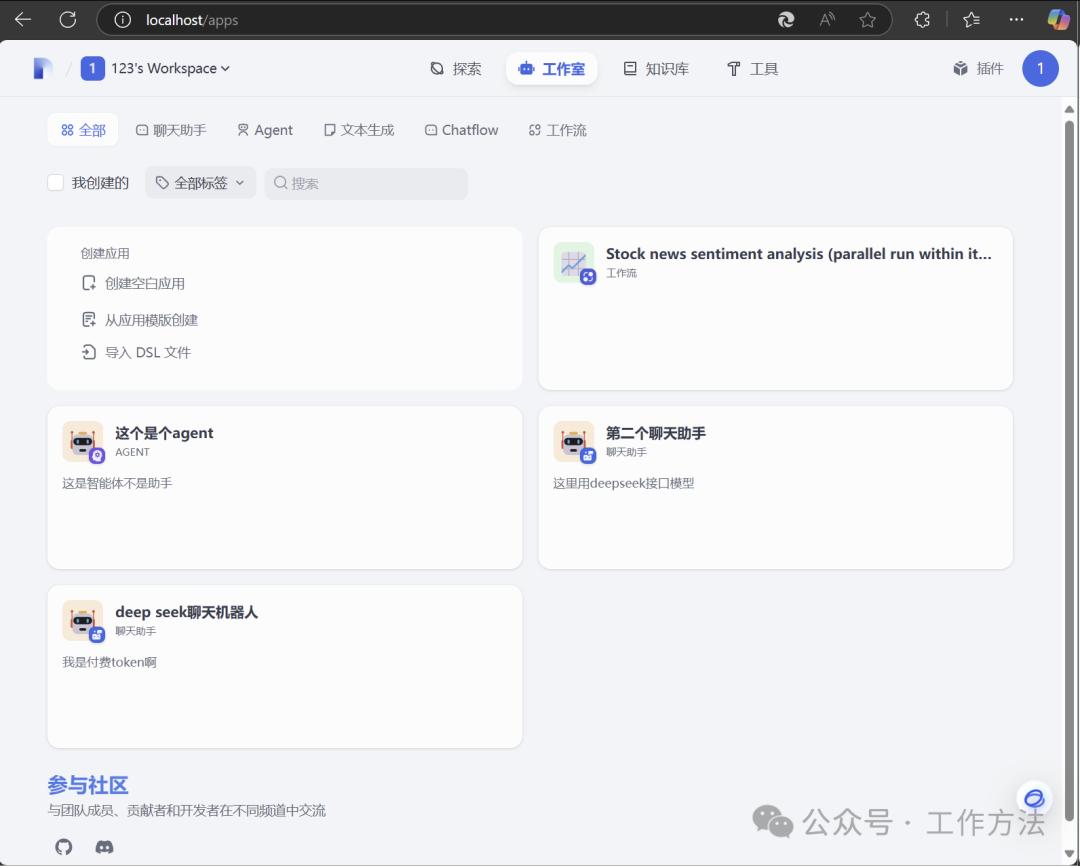

打开dify本地地址:Dify(http://localhost/apps)

接入大模型这里有2种方式

方式一:通过接口API+密钥的形式接入公共平台上的大模型(充值买token)

方式二:通过本地部署的ollama,接入本地部署的大模型(无限token)

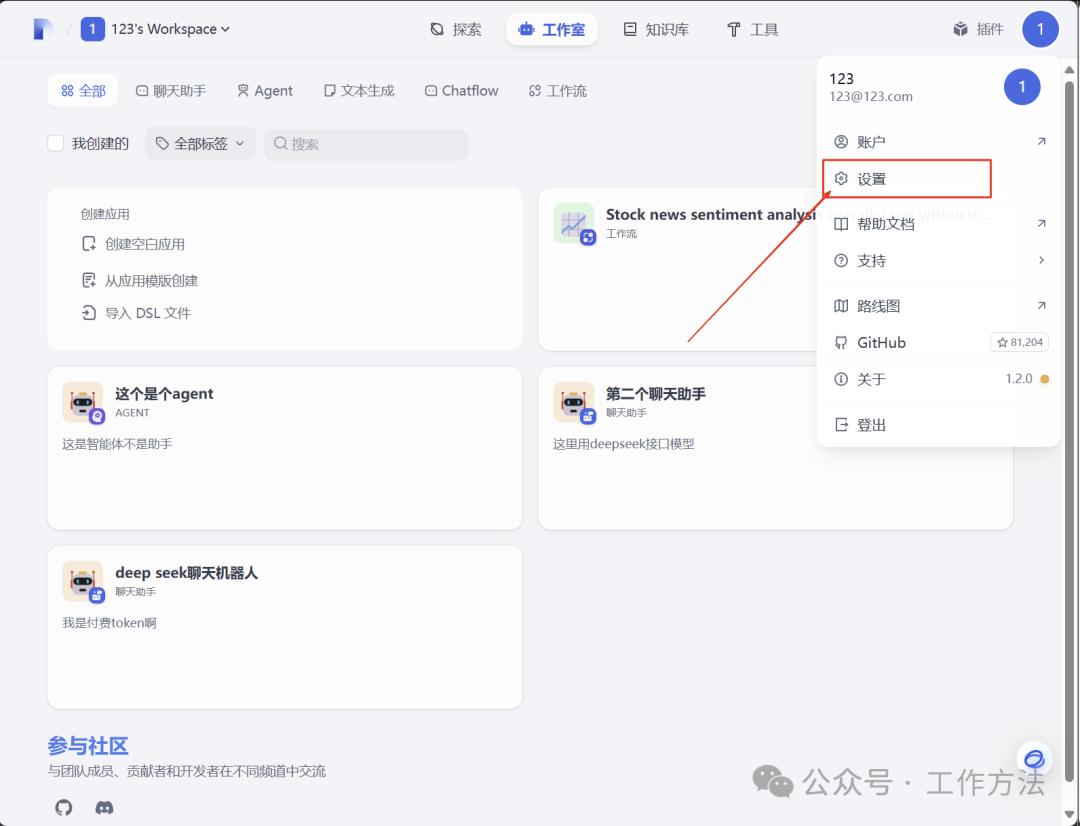

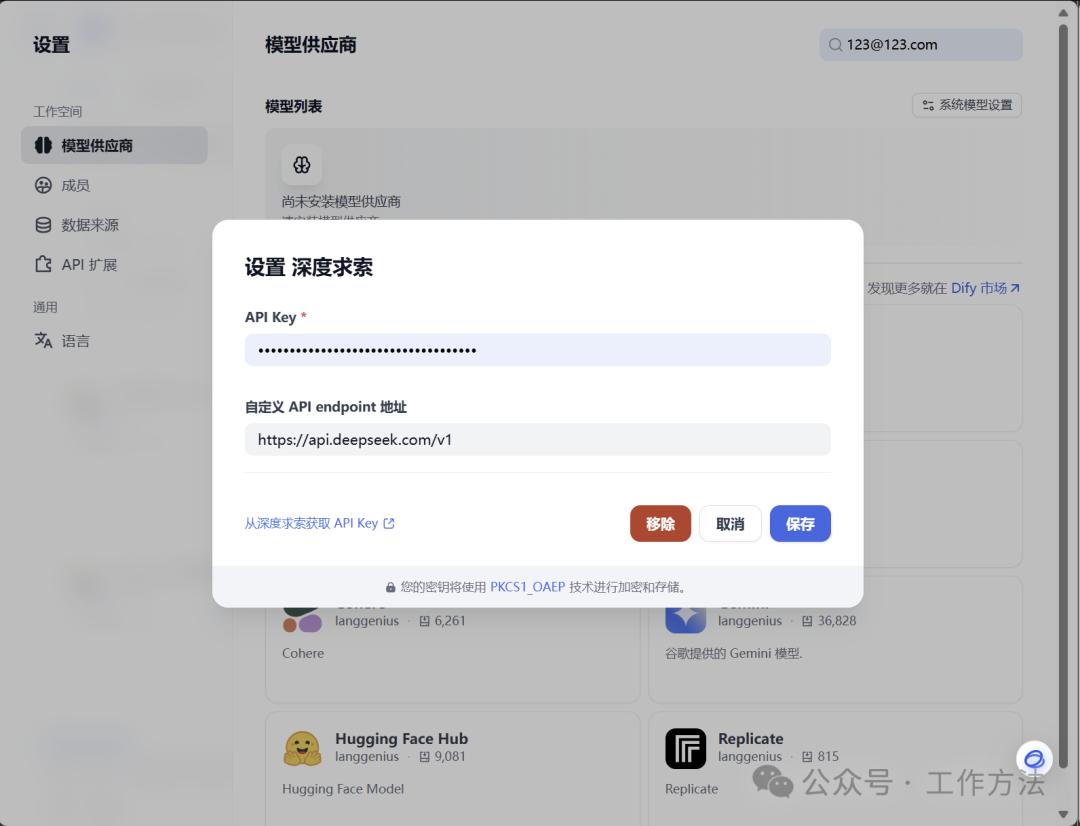

下面简单说一下方式一通过接口API+密钥的形式接入公共平台上的大模型,

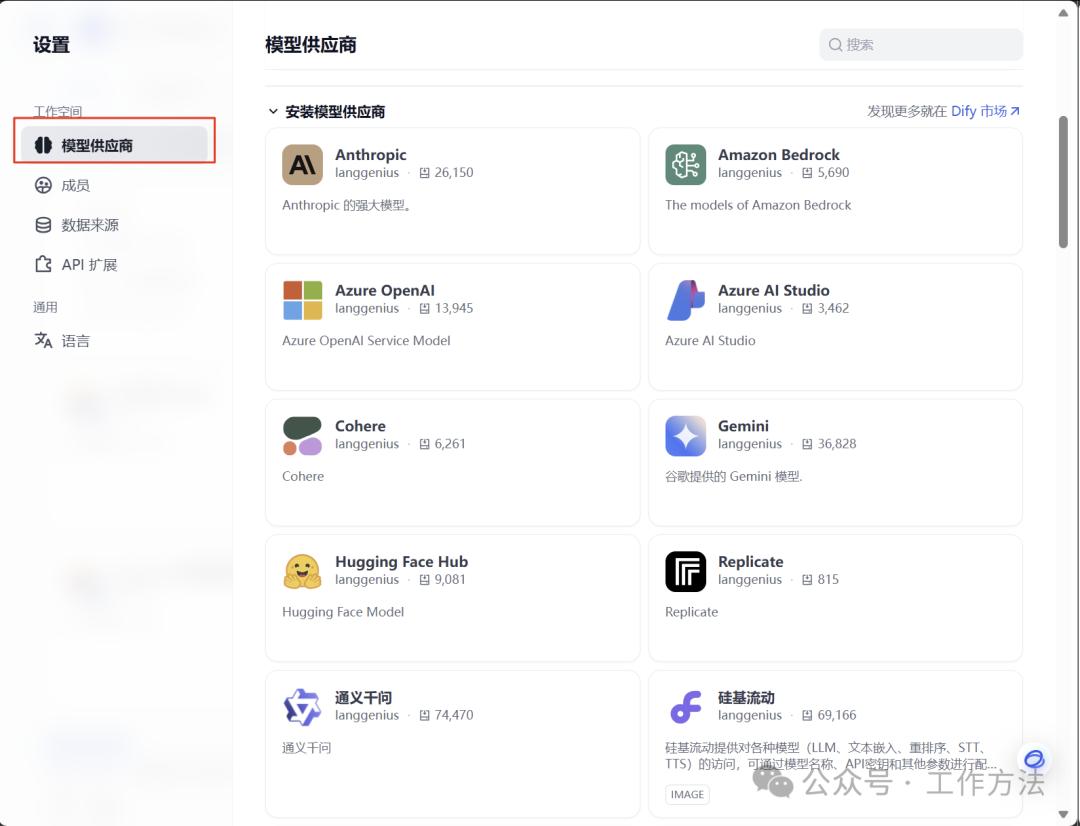

设置->模型提供商

找到“深度求索”填入”API Key”+”自定义 API endpoint 地址”

自定义 API endpoint 地址—>

https://api.deepseek.com/v1

API Key—>去deepseek官网(DeepSeek开放平台

https://platform.deepseek.com/sign_in),充值5块钱,获取密钥即可

下面是填写完成的效果,模型就可使用了;

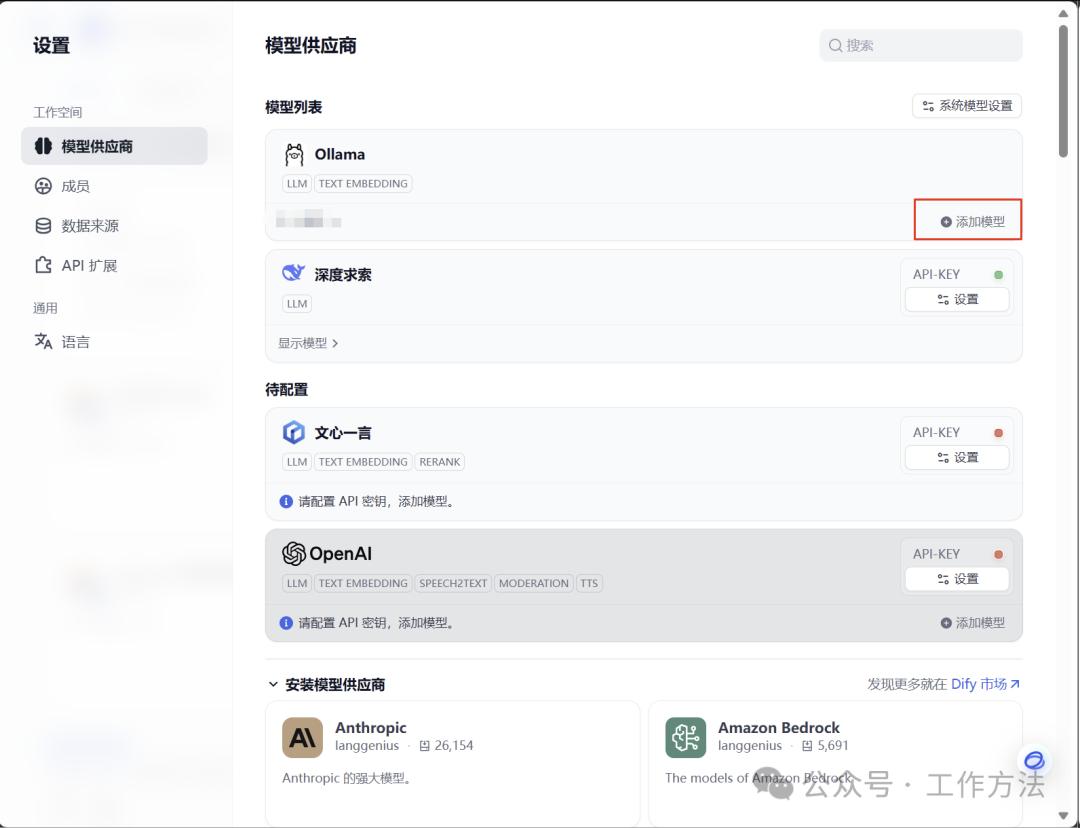

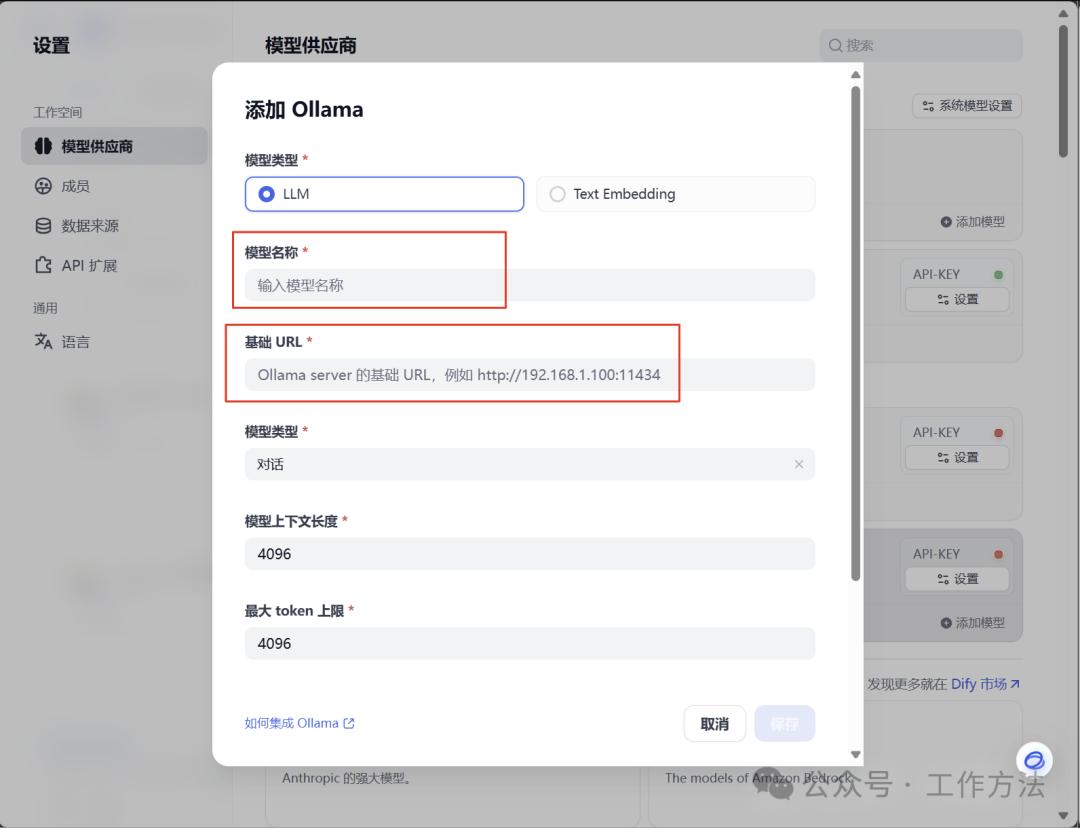

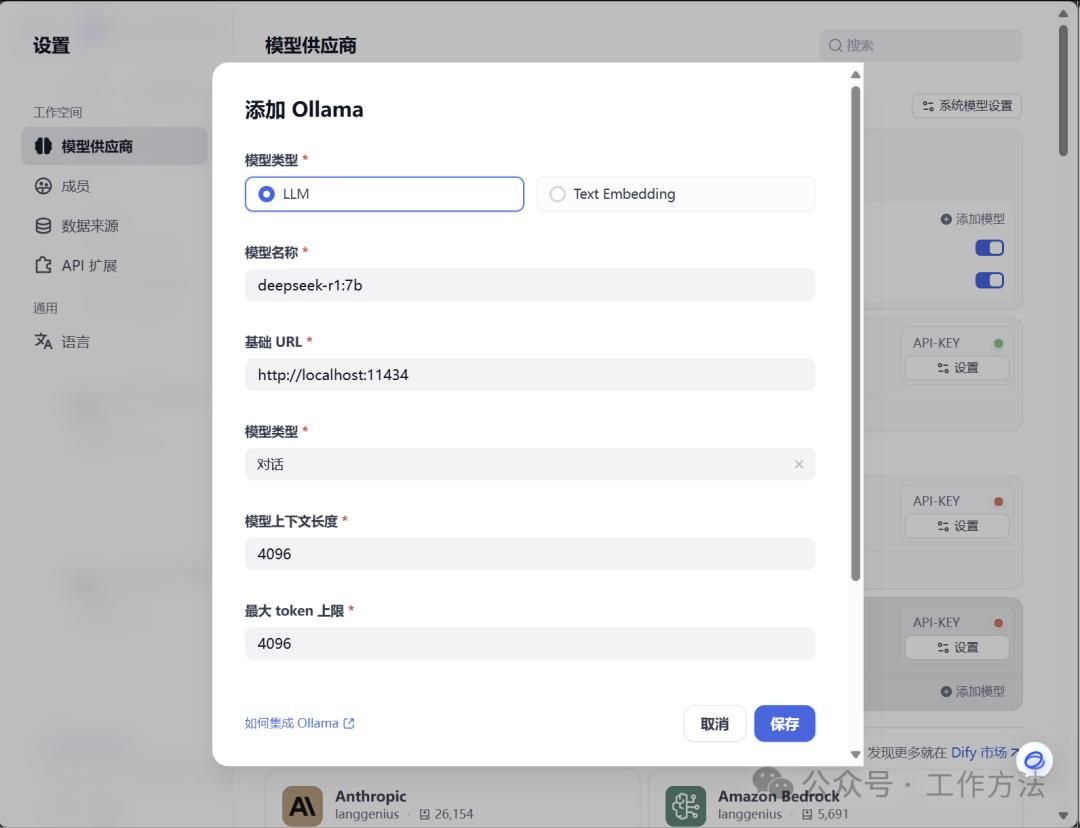

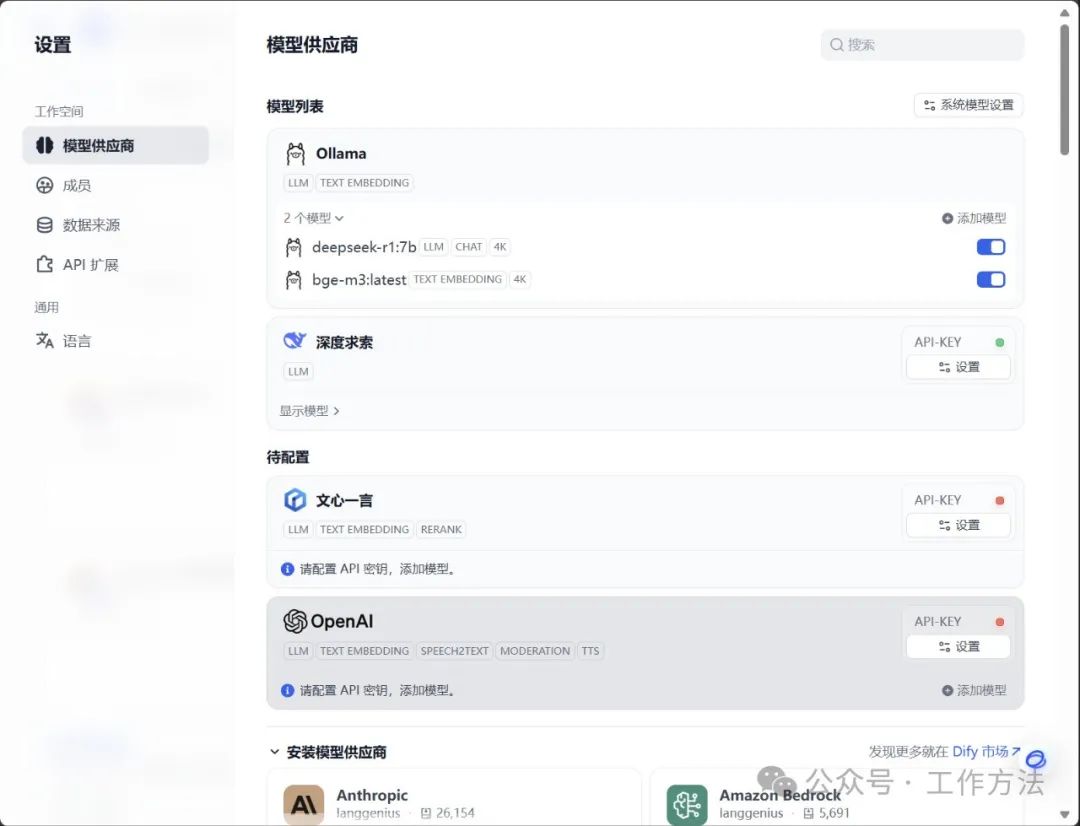

找到ollama,将本地已经部署的deepseek-r1:7b

添加到ollama中,点击“添加模型”

模型名称:deepseek-r1:7b(本地安装的什么版本,这里就填写你本地部署的版本)

内网地址:http://localhost:11434

点击“保存”即可完成添加

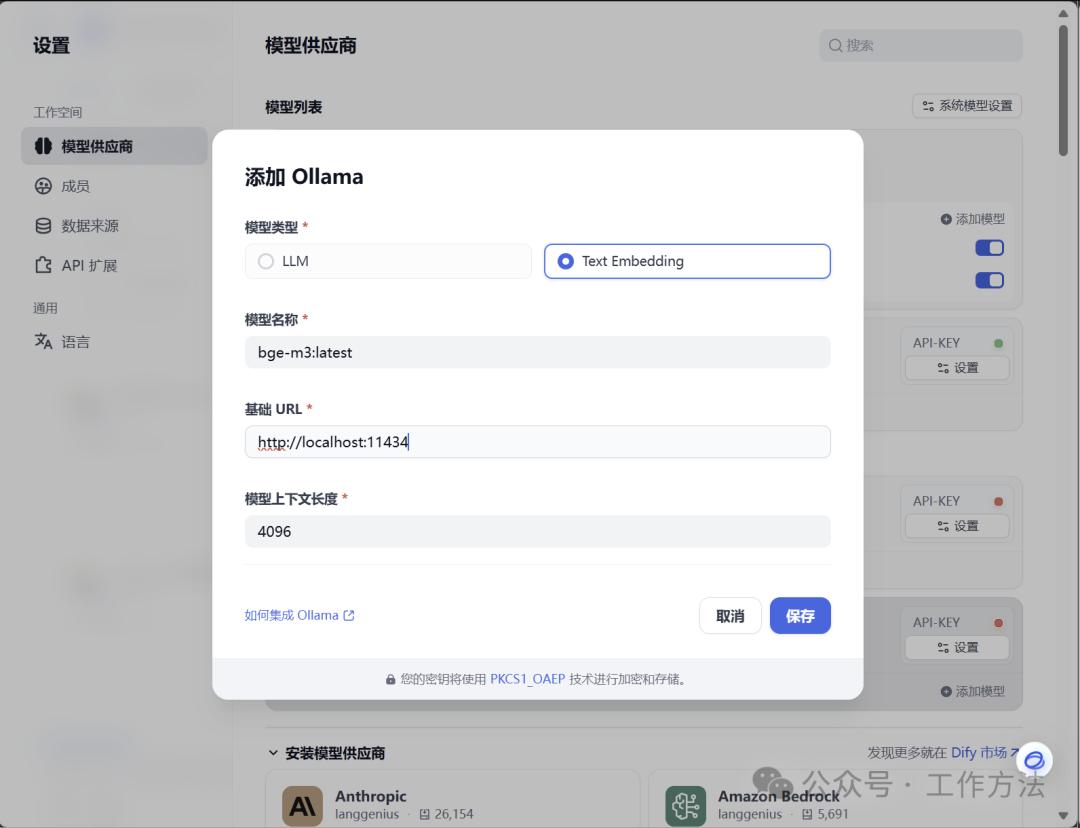

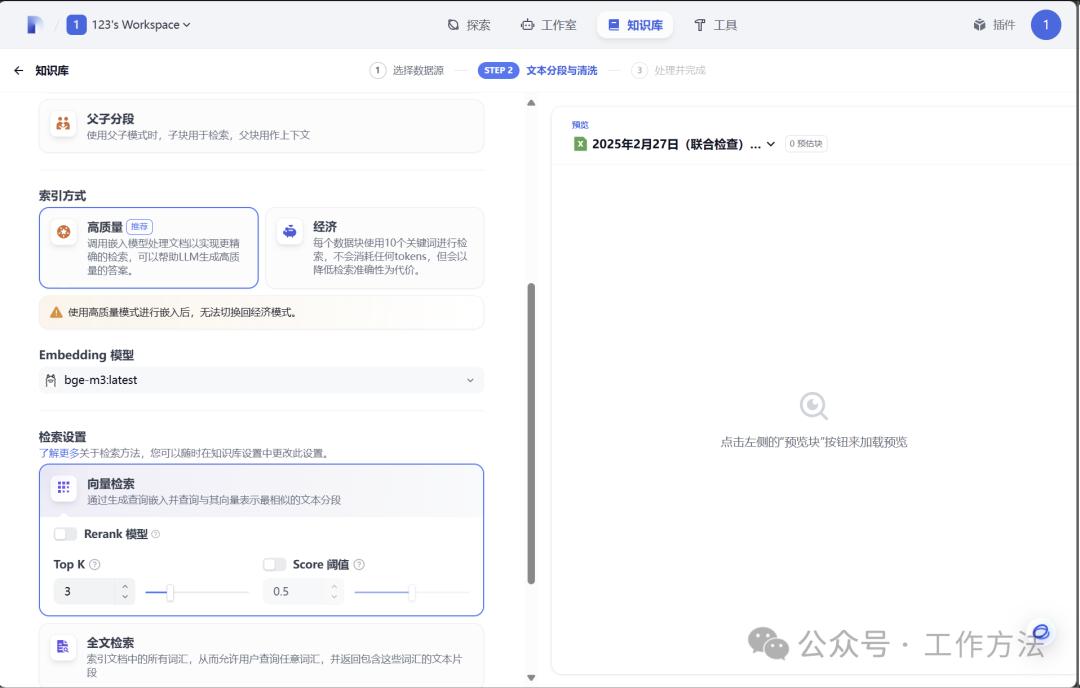

再添加知识库Embedding模型

模型名称:bge-m3:latest(本地安装的什么版本,这里就填写你本地部署的版本,我本地安装的是bge-m3,)

内网地址:http://localhost:11434

点击“保存”即可完成添加,

补充:创建本地的知识库,需要用到Embedding 模型,测试bge-m3性能最高

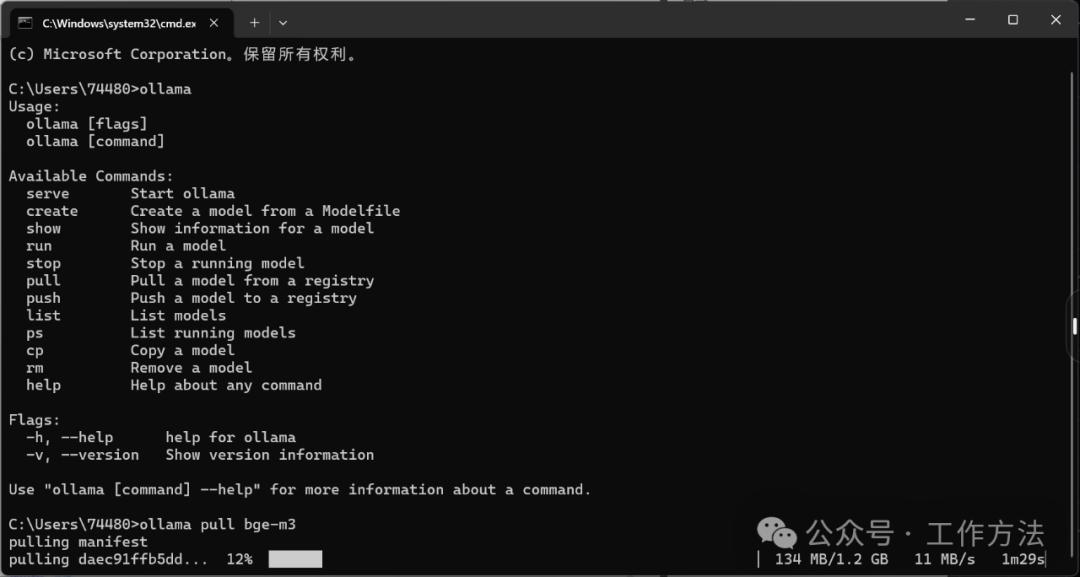

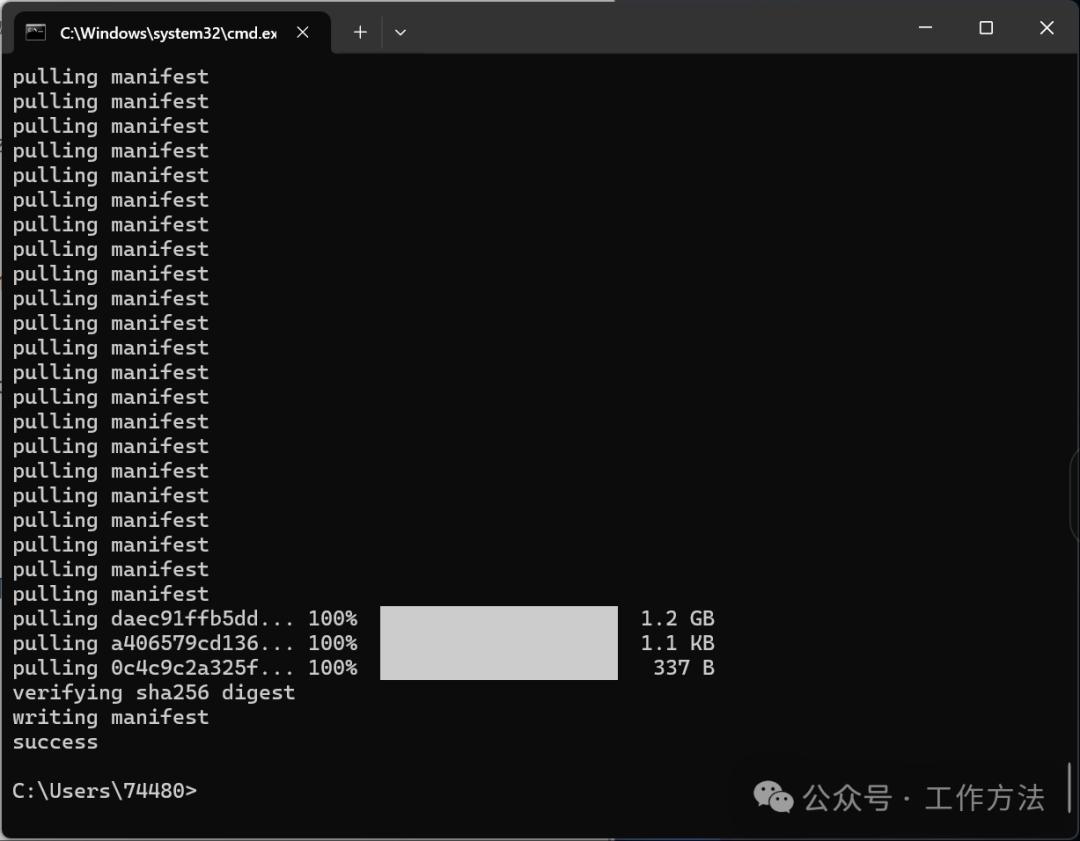

安装bge-m3

ollamapull bge-m3

到这里就安装完成了,

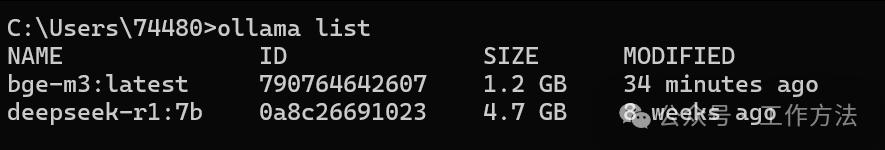

可以通过输入ollama命令查看当前安装版本

ollamalist

拓展:

打开cmd后输入:查看命令ollama –version

查看模型仓库:ollama list

显示模型信息: ollama show

在cmd中去拉模型: ollama pull 模型名称

删除模型:ollama rm 模型名称

测试ollama运行状态:http://localhost:11434(访问网址)出现Ollama is running即使正在运行,如果连接打不开就是没在运行。

ollama添加完成模型的效果

最后一步,点击“系统模型设置”将系统推理模型和Embedding模型分别选择本地安装的模型就可以了。

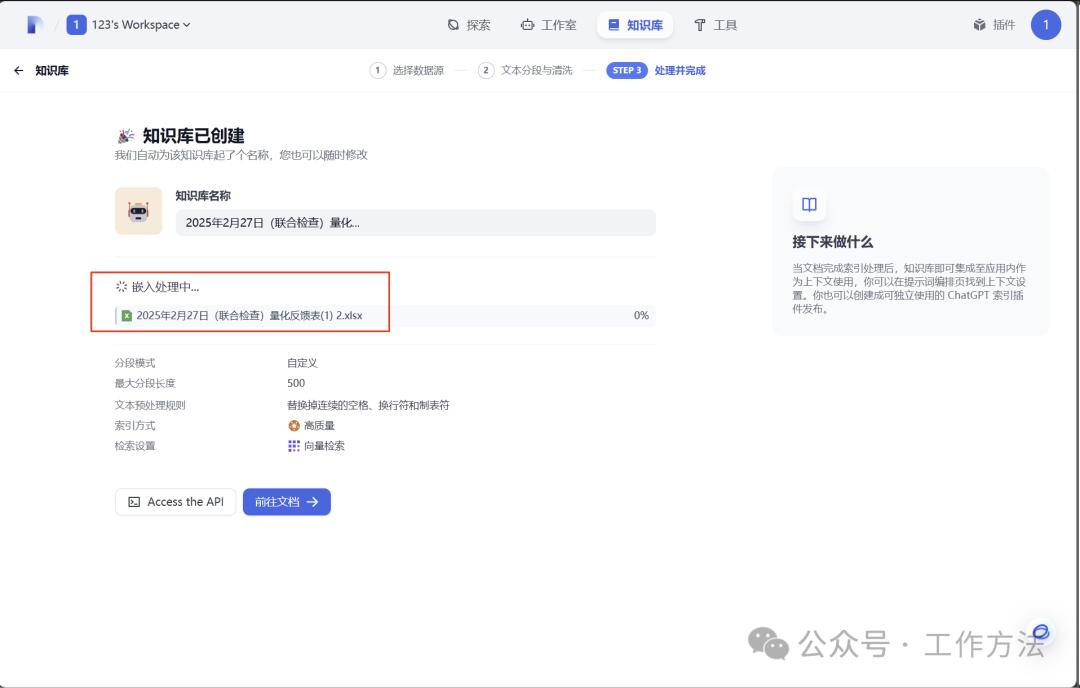

知识库选择模型的地方就可以使用啦,到这里本地部署的dify与本都部署的大模型(推理模型+知识库模型)就配置完了,上传一个文件试试

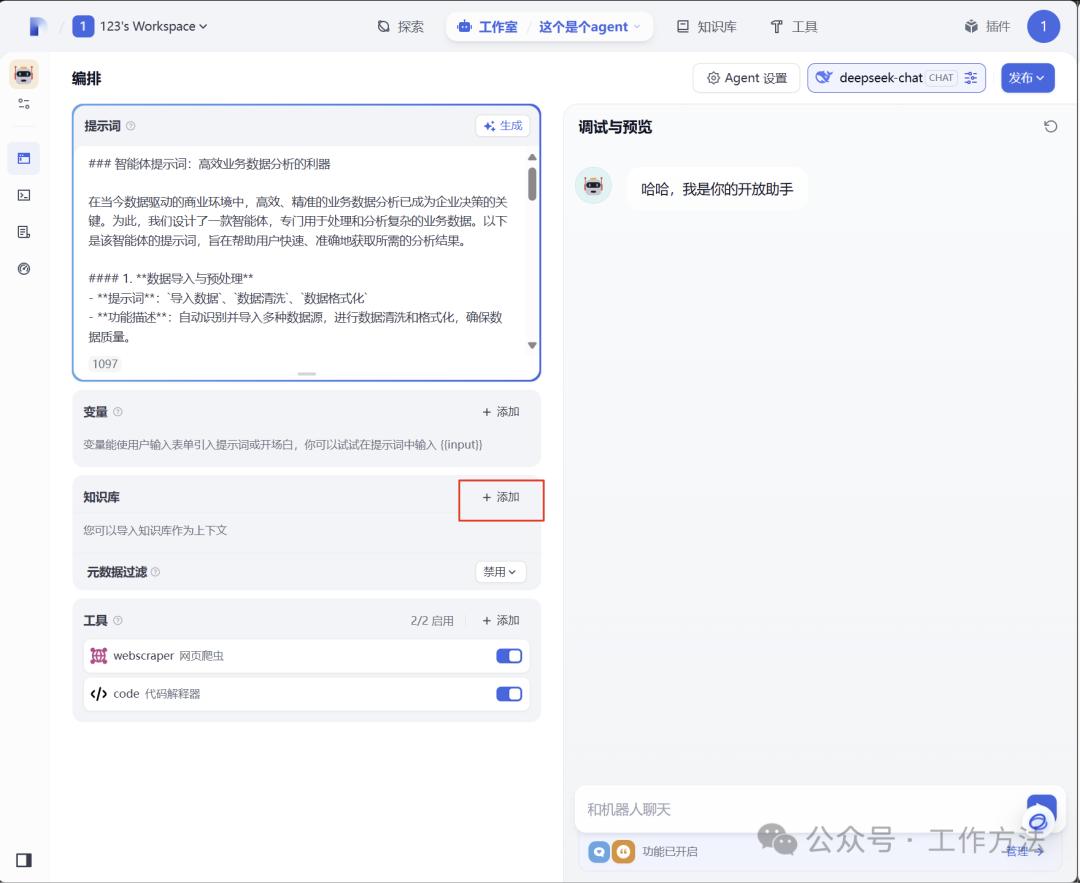

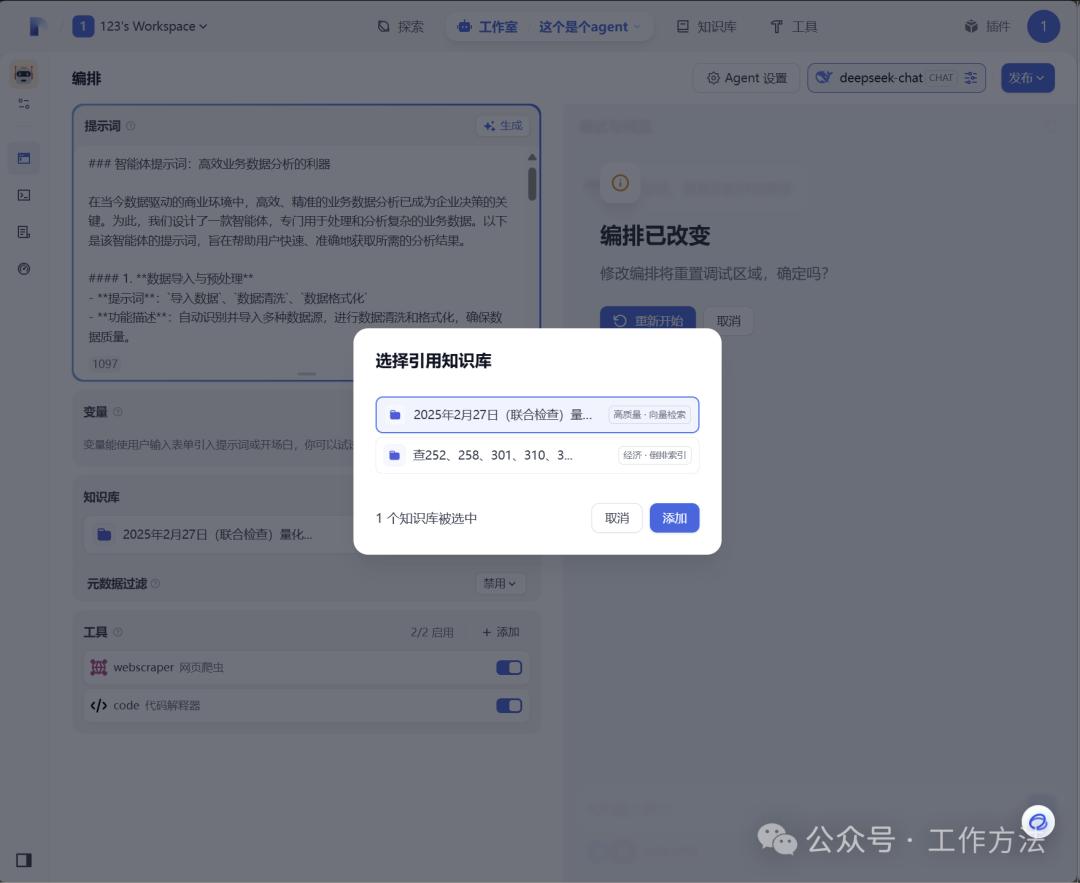

上传了,在我之前的智能体中加上知识库

问一个问题

回答得还不错,👍

下一期将用本地部署的平台,搭建一个本地智能体~敬请期待

本文由 @董方旭 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

VoidWalkerZ

好酷!本地RAG结合大语言模型,未来可期!

VoidWalkerZ

这玩意儿,我感觉它会彻底改变我们的生活方式!

NeonDreamer_123

感觉我们人类可能要变成AI的宠物了,有点可怕!

NeonDreamer_123

这种结合,简直是天才!未来可期,我支持!

NeonDreamer_123

挺有意思的,以后我们都得学会和AI打交道!

PixelMuse_77

感觉人类的价值正在被AI取代,有点悲哀啊!

PixelMuse_77

厉害了,这个RAG结合,简直是把未来提前了!

PixelMuse_77

挺有意思的,不过我还是喜欢老式的大脑!

NeonDreamer_123

感觉要被AI统治了,这未来真的有点吓人!

VoidWalkerZ

啧啧啧,终于有人玩点新花样,真让人期待!